پروندهای درباره اقتصاد خالقان محتوا

موضوع اقتصاد خالقان محتوا یا اقتصاد تولیدکنندگان محتوا (Creator Economy) در جلسه تحریریه پیوست، یعنی…

۸ بهمن ۱۴۰۴

ابزارهای مبتنی بر هوش مصنوعی، از دوربینهایی که چهره رهگذران را شناسایی میکنند تا الگوریتمهایی که احساسات مردم در محیط آنلاین را تحت نظر میگیرند، روشهای جدیدی در نظارت دولتی در سراسر جهان به وجود میآورند. سازمانهای اجرای قانون، امنیت ملی، عدالت کیفری و مدیریت مرزی در سراسر جهان بهطور روزافزون از این فناوریها بهره میگیرند. فناوریهای نظارتی از تشخیص الگوی آماری، یادگیری ماشین و تجزیهوتحلیل داده استفاده میکنند تا بهصورت خودکار اطلاعات را دستهبندی و الگوهای بهدستآمده را پیشبینی کنند. سوال این است که پیامدهای ارتقای ظرفیتهای نظارتی برای حکمرانی چیست؟

فناوری هوش مصنوعی از طریق پیشرفتهای جدیدی که رویکردهایی مانند تشخیص چهره، نظارت بر رسانههای اجتماعی و پلیس هوشمند را امکانپذیر میسازند، قدرت دولتها برای نظارت بر شهروندان را گسترش میدهد. حکومتهای تمامیتخواه با کمال میل از این ظرفیتهای جدید استفاده میکنند اما اینکه نظامهای سیاسی بازتر نیز از ابزار نظارتی مبتنی بر هوش مصنوعی استفاده میکنند باعث میشود سوالهایی درباره تاثیر این رویه بر مراحل قانونی، آزادی بیان و کنشگری شهروندان مطرح شود.

نظارت مبتنی بر هوش مصنوعی اگر بر اساس مقررات انجام نگیرد، خلأهایی را در حاکمیت قانون به وجود میآورد. این نوع نظارت، دولتهایی را از لیبرالیسم دورتر میکند که در سالهای اخیر شاهد تضعیف نهادهای دموکراتیک بودهاند. کارزارهای جامعه مدنی برای جلب توجه به این خطرها راه افتادهاند و دموکراسیهای نهادینهشده تلاش میکنند تا قوانین پایه را برای استفاده از هوش مصنوعی در ابزارهای نظارتی وضع کنند. باوجوداین، برای اینکه آرمانها به واقعیت تبدیل شوند، رهبری دموکراسیها باید تقویت شود، صاحبان منافع باید با یکدیگر همکاری پویاتری داشته باشند و تعامل مستمر با طیف گستردهتر مردم باید تسهیل شود.

سیستمهای هوش مصنوعی با تکیه بر برخی روشها قدرت نظارتی دولت را افزایش میدهند:

اول: هوش مصنوعی عملیاتی را خودکار میکند که قبلاً انسانها انجام میدادند- برای مثال، استفاده از الگوریتم برای تطبیق تصاویر با ویدئو.

دوم: فناوری هوش مصنوعی میتواند به صورت خودگردان اطلاعات را دستهبندی و الگوها را پیشبینی کند. این ظرفیت به سیستمهای خودگردان اجازه میدهد تا ناهنجاریهای شناساییشده را نشانهگذاری و رویدادهای آینده را پیشبینی کنند.

سوم: هوش مصنوعی پیشرفته از حجم بیسابقهای از دادهها استفاده میکند. این عناصر به نفع سازمانهای اجرای قانون عمل میکنند اما این تهدید را نیز موجب میشوند که حریم نقض و در تحقیقات زیادهروی شود.

چهارم: همچنین سوگیری تبعیضآمیز نیز یکی از پیامدهای کاربرد هوش مصنوعی است. اجتماعهایی که به حاشیه رانده شدهاند معمولاً بیشترین ضربه را از سوءاستفاده از فناوری و طراحی معیوب آن میخورند.

این ظرفیتهای جدید در نظامهای تمامیتخواه، سرکوب را عمیقتر میکنند. یکی از نمونههای مهم استان شینجیانگ چین است که در آن، نظارت مبتنی بر زیستسنجی (بیومتری) و نظارت بر رسانههای اجتماعی ادغام میشوند تا سامانهای یکپارچه برای کنترل فیزیکی و دیجیتالی به وجود آید. درست است که کاربرد گسترده ابزارهای هوش مصنوعی برای سرکوب جمعیتی خاص در نظامهای تمامیتخواه اتفاق میافتد اما ظرفیت بالقوه این ابزار برای نقض حریم، تسهیل مجازات سیاسی، تبعیض علیه گروههای محروم و فرسایش آزادی بیان صرفاً به این نوع نظامها محدود نمیشود.

طرفداران آزادی در لیبرالدموکراسیها نگرانی موجهی دارند مبنی بر اینکه مقامها از فناوریهای جدید به صورت ضددموکراتیک استفاده کنند. در واقع، استفاده از نظارت الکترونیکی برای آزار دادن و نظارت بر کنشگران حقوق مدنی، تظاهراتکنندهها و سازمانهای بومیهای آمریکایی باعث شد تا قانون نظارت بر اطلاعات خارجی (۱۹۷۸) در ایالات متحده تصویب شود. این قانون برخی فعالیتهای نظارت الکترونیکی را مجاز میشمارد. امروز درحالیکه استفاده مناقشهانگیز از ابزار نظارتی مبتنی بر هوش مصنوعی گسترش پیدا میکند و دموکراسی نیز در سطح جهانی عقبنشینی میکند، دولتهای لیبرال میکوشند تا تعادل مقبولی بین حفظ نظر عمومی و حفاظت از آزادیهای مدنی برقرار کنند.

شهردار مارسل در فرانسه «پروژه کلانداده آرامش عمومی» را راهاندازی کرده است که از فناوری پلیس پیشبینانه استفاده میکند. این کار با جمعآوری و تحلیل دادهها برای پیشبینی، بازداری و واکنش به جرائم آینده انجام میگیرد. همچنین هزاران دوربین ویدئویی در این پروژه مورد استفاده قرار میگیرند که از ZTE، غول فناوری چین، خریداری شدهاند. گزارشهای اخیر نشان دادهاند سازمانهای دولتی در ایالات متحده، از فناوری تشخیص چهره به طور گسترده بهره میگیرند؛ از جمله نرمافزاری که بر رسانههای اجتماعی نظارت میکند و توسط Clearview AI، شرکتی خصوصی، توسعه یافته است.

ادارههای پلیس برای شناسایی مظنونهای حمله به کاخ کنگره ایالات متحده در ۶ ژانویه سال ۲۰۲۱ از الگوریتمهای تشخیص چهره و نظارت بر رسانههای اجتماعی استفاده کردند. نیروهای نظامی رژیم صهیونیستی برنامهای را پیادهسازی میکنند که فناوری تشخیص چهره را با دستگاههای نظارت ویدئویی و تلفن هوشمند ادغام میکند تا بر فلسطینیها نظارت کند. در بسیاری از موارد این زیرساختهای نظارتی جدید به صورت پنهانی توسعه پیدا میکنند و تنها بعد از استقرارشان به سمع و بصر عمومی میرسند.

فناوریهای نظارت پیشرفته ریسک بیشتری برای دموکراسیهای ضعیف و نظامهای ترکیبی (hybrid regimes) دارند. عقبنشینی دموکراسی در کشورهایی مانند لهستان، مجارستان، هند یا فیلیپین باعث شده حاکمیت قانون تضعیف شود. دراینمیان، چنین ابزاری امکانات جدید را برای ردیابی و ارعاب معترضان، نظارت بر مخالفان سیاسی و جلوگیری از بروز چالش علیه قدرت دولتی فراهم میکنند. گزارشهای موجود نشان میدهد دموکراسیهای ضعیف و نظامهای ترکیبی از نظارت مبتنی بر فناوری پیشرفته استقبال میکنند. مقامهای هند از فناوری تشخیص چهره برای شناسایی تظاهراتکنندهها استفاده میکنند. مقامهای صربستان با هواوی قرارداد بستهاند تا شبکه نظارتیای را مستقر کنند که «همه خیابانها و گذرگاههای مهم» بلگراد را پوشش میدهد. درعینحال، دولت پاکستان سیستمهایی را به ارزش ۱۸.۵ میلیون دلار از شرکت Sandvine کانادایی خریداری کرده تا بر ترافیک آنلاین و ارتباطات نظارت کند.

سوال این است که آیا افزایش دسترسی دموکراسیهای ضعیف و نظامهای ترکیبی به ابزار نظارتی مبتنی بر هوش مصنوعی منجر به تسریع عقبنشینی دموکراسی و نقض حاکمیت قانون میشود؟ پاسخ این سوال احتمالاً در تعامل بازار نظارتی جهانی (با رهبری چین)، شرایط سیاست داخلی در کشورهای مدنظر و تلاشهای دولتهای ملی، گروههای جامعه مدنی و جامعه جهانی برای توسعه هنجارهای جدید حول محور هوش مصنوعی پیدا خواهد شد.

فناوری نظارتی مبتنی بر هوش مصنوعی به این دلیل فراگیرتر میشود که هزینههای آن کاهش پیدا میکند. همانطور که شاخص هوش مصنوعی ۲۰۲۱ استنفورد نشان میدهد: «فناوریهای ضروری برای نظارت در مقیاس کلان با سرعت زیادی به بلوغ میرسند و فنون دستهبندی تصویر، تشخیص چهره، تحلیل ویدئو و شناسایی صوت با پیشرفت چشمگیری همراه بودهاند.»

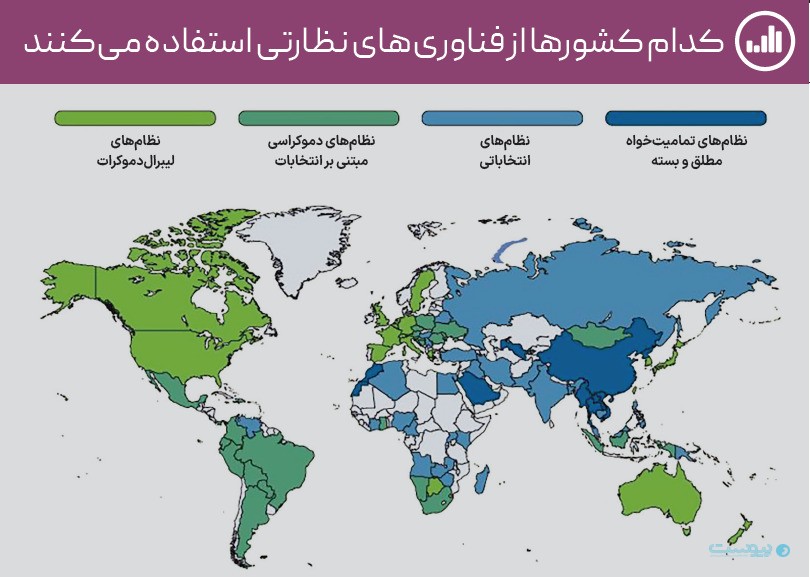

در سال ۲۰۱۹ شاخصی را منتشر کردیم که از تحلیل محتوای متنباز استفاده میکرد تا رواج چهار نوع سیستم نظارتی مبتنی بر هوش مصنوعی در جهان را سنجش کند. این چهار نوع سیستم عبارتاند از: فناوری تشخیص چهره (فناوری زیستسنجی که چهره مردم را برای اهداف شناسایی تحلیل میکند)، شهرهای هوشمند یا ایمن (شبکههای شهری که از هزاران حسگری تشکیل شدهاند که دادههای بیدرنگ را برای تسهیل مدیریت شهری منتقل میکنند)، فنون پلیس هوشمند (روشهای مبتنی بر داده برای اقدام پلیس، تحقیقات، پیشگیری از جرم و حتی تصمیمگیری درباره صدور حکم) و نظارت بر رسانههای اجتماعی (الگوریتمهایی که میلیونها ارتباط آنلاین را بهصورت خودکار تحت نظر میگیرند). این شاخص در سال ۲۰۲۲ بهروز شد و نشان داد دولتهای دموکراتیک کمی بیشتر از نظامهای تمامیتخواه از ظرفیتهای نظارتی مبتنی بر هوش مصنوعی استفاده میکنند: ۵۲ کشور از ۹۷ کشوری که چنین ابزاری دارند شکلی از دموکراسی لیبرال یا انتخاباتی تلقی میشوند.

شرکتهای چینی بیشترین ابزار هوش مصنوعی و یادگیری ماشین پیشرفته را عرضه میکنند و به دولتها اجازه میدهند تا نظارت گسترده را انجام دهند. این شرکتها با ولع زیادی به دنبال بازارهای جدیدند و یارانه دولتی چین از آنها حمایت میکند. سیاستهای چین باعث شده دولتهای جهان از واردات این ابزار ارزان استقبال کنند: دوربینهای نظارتیای که توسط Hikvision و Dahua تولید میشوند مسئول «حدود ۴۰ درصد» بازار جهانی هستند. فناوری نظارتی چین در بیش از ۸۰ کشور در همه مناطق دنیا مورد استفاده قرار میگیرد.

چین برای صادرات ابزار نظارتی بهطور مستمر این فناوریها را توسعه میدهد. با وجود انتقاد بینالمللی از راهکارهای نظارتی در شینجیانگ، شرکتهایی مانند هواوی و Dahua با دولت چین همکاری میکنند تا سیستمهای جدید را آزمایش کنند؛ از جمله نرمافزار تشخیص هیجان (اپلیکیشنهایی که وضعیت هیجانی فرد را استنباط میکنند) و فنون شناسایی قومی (برنامههایی که از اطلاعات بهدستآمده از اسکن چهره استفاده میکنند تا نژاد افراد را تشخیص دهند) که اقلیت اویغور در چین را هدف قرار میدهند. محققان آزادی عقیده نشان میدهند جمهوری خلق چین «بازار پررونقی در زمینه فناوریهای تشخیص هیجان دارد» که بدون نظارت یا مشورت مردمی شکل گرفته است.

علاوهبراین، پکن ظرفیتهای «ترکیب داده» را افزایش میدهد (ادغام مجموعهدادههای مختلف برای ارتقای قدرت تحلیلی ابزار دیجیتالی). محققان چینی سرمایهگذاری سنگینی روی بهبود بینایی ماشین و نظارت بصری انجام میدهند (با تمرکز ویژه بر فناوریهای مربوط به شناسایی فرد بر اساس دادهها، نظارت بر جمعیت و تشخیص جعل چهره که میتواند نشان دهد فرد نقاب زده یا خودش را جای فردی دیگر معرفی میکند). همچنین، مقامهای جمهوری خلق چین میکوشند تا بر اهداف خارجی نیز نظارت کنند. این کار با استفاده از نرمافزار پیشرفته تجزیهوتحلیل داده و استخراج داده از رسانههای اجتماعی و پلتفرمهای اینترنتی انجام میگیرد.

شرکتهای کشورهای عضو سازمان همکاری و توسعه اقتصادی نیز نرمافزار پلیس پیشبینانه، الگوریتمهای تشخیص چهره و اپلیکیشنهای نظارت بر رسانههای اجتماعی را به فروش میرسانند. این شرکتها مشتریهای تمامیتخواه نیز دارند. اکثر دولتها، بهویژه آنهایی که منابع سرشاری دارند، تلاش میکنند برای تحقق اهداف نظارتیشان صرفاً به یک کشور یا تامینکننده وابسته نشوند. برای مثال، در عربستان سعودی، هواوی شهرهای ایمن میسازد، گوگل و مایکروسافت بر سرورهای یارانش ابر کشور نظارت میکنند، BAE به عنوان تولیدکننده تسلیحات بریتانیایی سیستمهای نظارت گسترده را تامین میکند، NEC ژاپن دوربینهای تشخیص چهره را فراهم میسازد و آمازون و علیبابا قصد دارند در یک پروژه بزرگ شهر هوشمند شرکت کنند.

همچنین، فروشندگان اروپایی و آمریکایی ابزارهای نظارتی مبتنی بر هوش مصنوعی را به چین صادر کردهاند که برخی از آنها به شینجیانگ منتقل شدهاند. علاوهبراین، استفاده از فناوری نظارتی مبتنی بر هوش مصنوعی در بین خود لیبرالدموکراسیها در حال رشد است. پاندمی کووید-۱۹ باعث شد فروشندگان نظارتی در سطح جهانی مورد استقبال قرار بگیرند. دولتها و شرکتهای خصوصی از ابزاری مانند اپهای ردیابی قرارداد، الگوریتمهای پیشبینی سلامت عمومی و حسگرهای دما استفاده میکنند. گروههای جامعه مدنی در شروع پاندمی درباره خطرهای کاربرد این سیستمها توسط دولت هشدار دادند. در واقع، بسیاری از دولتها نتوانستند این سیستمها را کامل پیادهسازی کنند یا از نتایج آنها ناامید شدند. باوجوداین، این ریسک وجود دارد که تدابیر مداخلهجویانه و روندِ از بین رفتن تدریجی حریم داده بعد از دوران پاندمی ادامه پیدا کند. علائم روزافزونی در برخی کشورها وجود دارد که نشان میدهد ابزارهایی مانند اپ کد سلامت چینی- که احتمال ابتلای کاربران به بیماری را افزایش میدهند و دسترسی آنها به محیطهای عمومی را شناسایی میکنند- بعد از پاندمی نیز مورد استفاده قرار بگیرند و نوع جدیدی از سرکوب سیاسی را به وجود آورند. تقاضا برای اسکنرهای دما نیز به شرکتهایی مانند Dahua که حقوق بشر را نقض میکنند اجازه داد تا صادراتشان را گسترش دهند.

مباحث در این زمینه تمرکز شدیدی روی مدل تمامیتخواه فناوری چینی یا مناقشات مربوط به نظارت در لیبرالدموکراسیها دارند اما نظارت مبتنی بر هوش مصنوعی در نظامهای ترکیبی و دموکراسیهای ضعیف ممکن است بر تکامل سیاسی این کشورها و توسعه هنجارهای جهانی فناوری تاثیر جدی بگذارد. دموکراسیهای ضعیف و نظامهای ترکیبی محیط سیاسی نیمهبازی دارند که در آن سازوکارهای اصلی لیبرالدموکراسی تضعیف شدهاند یا از بین رفتهاند. همچنین احتمال شکلگیری الگوهای دیجیتالی تمامیتخواهی در این نوع کشورها بسیار زیاد است. استفاده از فناوریهای نظارتی خطر روزافزونی برای آزادیهای مدنی و حاکمیت قانون پدید میآورد اما جامعه مدنی هنوز هم میتواند با این روند مقابله کند.

از میان ۶۷ کشور که در این گروه قرار میگیرند، ۴۴ کشور درحالحاضر از ظرفیتهای نظارتی مبتنی بر هوش مصنوعی برخوردارند. البته در بسیاری از موارد اطلاعات محدودی درباره نحوه استفاده از ابزار هوش مصنوعی در دست است. باوجوداین، تحقیقات نشان میدهد رابطهای قوی برقرار است بین محدودسازی آزادیهای سیاسی و سوءاستفاده دولت از فناوریهای نظارتی. بنابراین، این ریسک که ابزارهای نظارتی مورد سوءاستفاده قرار بگیرند باعث میشود مشکلات حکمرانی جدیتر شود.

دموکراسیهای ضعیف و نظامهای ترکیبی چگونه درباره استفاده از نظارت مبتنی بر هوش مصنوعی تصمیم میگیرند؟ جمهوری خلق چین حضور سنگینی در اکثر این کشورها دارد و شرکتهای آن نقش اصلی را در خرید و استقرار این فناوریها ایفا میکنند. از میان ۶۷ کشور در این گروه، ۵۵ کشور عضو ابتکار کمربند و جاده پکن هستند. البته نباید عوامل داخلی را نادیده گرفت؛ مانند هنجارهای سیاسی، تهدیدهای امنیتی و مشوقهای رژیم که به انتخابهای دولت شکل میدهند (همچنین نباید تاثیر صادرات فناوری هوش مصنوعی غیرچینی را نادیده گرفت).

برای مثال، نگرانی امنیتی- داخلی یا خارجی- انگیزهای مهم برای سرمایهگذاری در نظارت محسوب میشود. منطقی است که کشورهایی مانند هند، پاکستان، عراق و کنیا- که با چالشهای تروریسم، شورش داخلی و حجم عظیم پناهندهها روبهرو هستند- تصمیم بگیرند روی سیستمهای پیشرفته نظارتی سرمایهگذاری کنند. همانطور که آکین اونوِر مینویسد، صادرات فناوریهای نظارتی ارزان چینی به برخی کشورها ممکن است کشورهای رقیب را ترغیب کند تا «به همان تامینکنندهها رجوع کنند و ظرفیتهای رقابتی به دست آورند و دوراهیهای امنیتیشان را حل کنند».

شواهدی وجود دارد که نشان میدهد برخی از دموکراسیهای ضعیف و نظامهای ترکیبی- از جمله هند، نیجریه و سنگاپور- از راهکارهای نظارتیای استفاده میکنند که نگرانی درباره حریم، عدالت و حاکمیت قانون را تشدید میکنند. برای مثال، نیروهای پلیس هند به طور روزمره از فناوری تشخیص چهره استفاده میکنند تا جستوجوهای فراگیری انجام دهند که اغلب محلههای فقیرنشین را هدف قرار میدهند؛ مناطقی که بهطور عمده میزبان مسلمانان و مهاجران از شمال هند هستند.

دیجیتالی شدن هند باعث شده نظارت به بخشی از حکمرانی هند تبدیل شود. نوعی سیستم هشدار زودهنگام برای شناسایی تهدیدهای امنیتی و همچنین سیستم تعدیل رفتار برای مدیریت و کنترل اجتماعی توسعه یافته است. موارد سوءاستفاده از این فناوری در سایر کشورها یا هنوز یافت نشده یا مستند نشدهاند. کشورهایی که از حریم خصوصی حفاظت میکنند و مقامهایشان مسئولیتپذیرند کمتر در معرض این آسیب قرار دارند.

درست است که ابزارهای نظارتی مبتنی بر هوش مصنوعی در سطح جهان محبوبیت پیدا کردهاند اما شواهد نشان میدهد این فناوریها هنوز انتظارهای بسیاری از کشورها را برآورده نکردهاند. دلایل این ناکارآمدی متنوع است اما میتوان به مشکل ظرفیت، تخصص و همکنشپذیری لازم برای هماهنگ کردن ابزار پیشرفته اشاره کرد.

برای مثال، دولت پاکستان هشت هزار دوربین را در سال ۲۰۱۶ در لاهور نصب کرد اما نرخ جرم در پنجاب یا افزایش پیدا کرد یا ثابت ماند. پروژه شهر هوشمند در کنیا بعد از ۱۳ سال هنوز اجرایی نشده است. علاوهبراین، ناظران فیلیپین میگویند سرمایهگذاری دولت آن کشور در فناوری نظامی چین صرفاً «نمایش امنیتی» است و تاثیر واقعی در ایمنی عمومی ندارد.

بر این اساس، قبل از اینکه دموکراسیهای ضعیف و نظامهای ترکیبی از نظارت مبتنی بر هوش مصنوعی به طور کامل بهرهبرداری کنند، جامعه مدنی و بخش خصوصی میتوانند آگاهی در این زمینه را افزایش دهند و مقامها را مسئولیتپذیر سازند.

منبع: اینترنشنال فوروم