استارتآپ پژوهشگر سابق دیپمایند در آستانه ثبت رکورد تاریخی جذب سرمایه در اروپا

دیوید سیلور، یکی از برجستهترین پژوهشگران هوش مصنوعی بریتانیا که سال گذشته از گوگل دیپمایند…

۲۹ بهمن ۱۴۰۴

۲۳ مهر ۱۴۰۴

زمان مطالعه : ۶ دقیقه

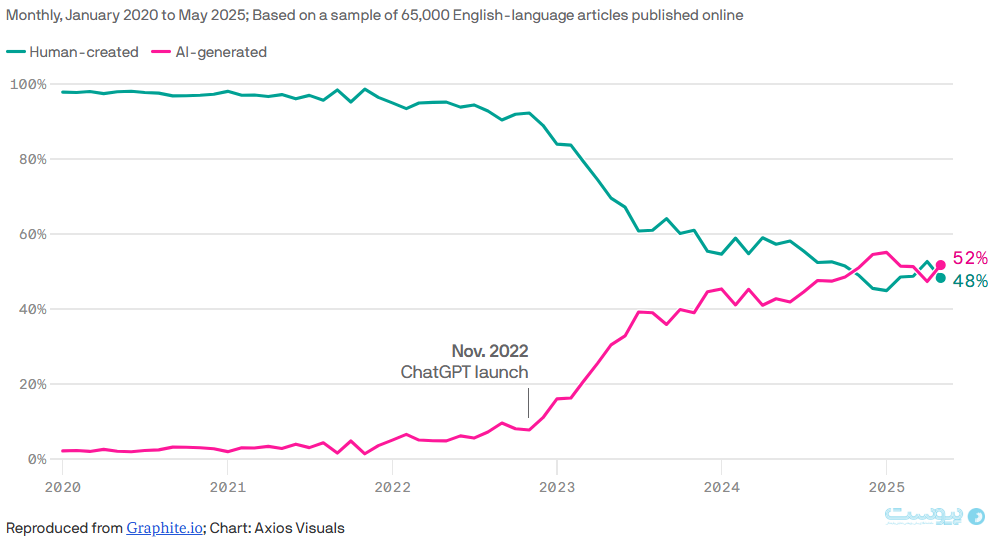

تازهترین گزارش شرکت Graphite، یکی از شرکتهای فعال در حوزه بهینهسازی موتورهای جستوجو (SEO) نشان میدهد که براساس آخرین دادههای سال ۲۰۲۴، سهم محتوای تولید شده با هوش مصنوعی به حدود نیمی از مقالات رسیده است، رقمی که نشانگر رشد چشمگیر این دسته محتوایی دارد اما با پیشبینی سلطه کامل محتوای ساخته هوش مصنوعی تا سال ۲۰۲۶ در اینترنت در تضا داست. با این حال دادههای این گزارش نشان میدهد که گوگل و چتباتها به نظر رتبه بهتری برای محتوای انسانی در بخش جستجوی خود در نظر میگیرند و رتبه محتوای ساخته هوش مصنوعی پایینتر است و این یافته میتواند خبر خوبی برای تولید کنندگان محتوا باشد.

به گزارش پیوست به نقل از اکسیوس، دادههای گرافیت نشان میدهد که گرچه در مقطعی از سال ۲۰۲۴ محتوای تولیدشده با هوش مصنوعی از محتوای انسانی پیشی گرفت، اما اکنون شاهد یک تعادل نسبی میان محتوای انسانی و ماشینی در وب برقرار است.

این شرکت گزارش خود را براساس تحلیل ۶۵ هزار صفحه وبی که در از تاریخ ۲۰۲۰ تا ۲۰۲۵ منتشر شدهاند، منتشر کرده است. دادهها این گزارش حاکی از آن است که از زمان عرضه ChatGPT در سال ۲۰۲۲، درصد مقالات تولیدشده توسط هوش مصنوعی بهطور چشمگیری افزایش یافته است. به طوری که در نوامبر ۲۰۲۴، برای مدتی کوتاه، سهم مقالات نوشته هوش مصنوعی از محتوای انسانی بیشتر شد، اما از آن زمان تاکنون هر دو نوع محتوا در سطحی تقریبا برابر باقی ماندهاند.

این یافتهها برخلاف پیشبینی بدبینانهی یوروپل، ژانس اتحادیه اروپا برای همکاری در اجرای قانون، در سال ۲۰۲۲ است که تخمین زده بود تا سال ۲۰۲۶، ۹۰ درصد از محتوای آنلاین را هوش مصنوعی تولید خواهد کرد.

شرکت گرافیت برای انجام این مطالعه از پایگاه داده متنباز Common Crawl استفاده کرده است که آرشیو عظمی با بیش از ۳۰۰ میلیارد صفحهی وب است و ماهانه بین ۳ تا ۵ میلیارد صفحهی جدید به آن اضافه میشود.

این شرکت سپس با کمک ابزار Surfer که سامانهای است برای تشخیص متن هوش مصنوعی از انسانی، سهم هرکدام از این دوجبهه را از محتوای تولید شده در اینترنت مورد بررسی قرار داد.

معیار مورد استفاده برای تفکیک محتوای انسانی از هوش منصوعی نیز به این صورت بود که اگر ۵۰ درصد یا کمتر از متن مقاله توسط انسان نوشته شده بود، آن محتوا بهعنوان محتوای تولیدشده با هوش مصنوعی طبقهبندی میشد.

گرافیت برای ارزیابی دقت این سامانه از دو مجموعه داده مقایسهای استفاده کرد که یکی مجموعه مقالات نوشته شده با GPT-4o شرکت اوپنایآی بود تا خطای منفی مورد بررسی قرار گیرد و دیگری نیز مجموعهای مقالاتی بود که پیش از عرضه ChatGPT منتشر شده بودند تا از آنها بهعنوان نمونههای انسانی استفاده شود.

نتیجهی آزمایش نشان داد که Surfer دارای ۴.۲ خطای مثبت کاذب است و به اشتباه محتوای انسانی را بهعنوان نوشته هوش مصنوعی دستهبندی می کند و تنها ۰.۶ خطای منفی کاذب داردکه یعنی محتوای هوش مصنوعی را بهعنوان نوشته انسانی تشخیص میدهد.

یکی از یافتههای مهم گزارش این است که تشخیص دقیق محتوای انسانی از ماشینی هرروز در حال دشوارتر شدن است که علت اصلی آن، همکاری گستردهی انسانها با ابزارهای هوش مصنوعی در تولید متن است.

سخنگوی گوگل در گفتوگو با اکسیوس در این باره گفت: «در حال حاضر، مرز روشنی میان محتوای انسانی و محتوای تولیدشده با هوش مصنوعی وجود ندارد. بسیاری از نویسندگان از هوش مصنوعی برای کمک در نگارش استفاده میکنند، اما همچنان انسان نقش اصلی را دارد. در واقع، رابطهی انسان و هوش مصنوعی بیش از آنکه در تضاد با هم باشد، نوعی همزیستی است.»

به همین دلیل، حتی با وجود ابزارهای دقیق تشخیص، نمیتوان با قطعیت گفت یک مقاله کاملا نوشته انسان یا کاملا ماشینی است. اما دادههای این گزارش خبر خوبی برای تولیدکنندگان محتوای انسانی را نیز در خود دارد و آن اینکه به نظر گوگل محتوای تولید شده توسط انسان را در جایگاه بهتری نسبت به محتوای هوش مصنوعی ردهبندی میکند.

در بخش دیگری از پژوهش، شرکت گرافیت به بررسی رتبهبندی مقالات در موتورهای جستوجو و چتباتها پرداخته است. یافتههای این بررسی نشان میدهد که در نگاه کلی محتوای نوشته انسان همچنان رتبه بالاتری را نسبت به نوشتههای هوش مصنوعی در جستجوی گوگل و چتباتها دارد.

طبق دادههای گرافیت:

از این رو به نظر میرسد موتورهای جستوجو و سیستمهای هوش مصنوعی اولویت بالاتری برای محتوای انسانی قائل هستند که احتمالا به کیفیت، اصالت، و عمق تحلیلی بیشتر این دسته از محتوا بازمیگردد. همچنین، بسیاری از مزارع محتوایی که در گذشته حجم زیادی از محتوای ماشینی را منتشر میکردند نیز متوجه این مساله شدهاند و دریافتند که این نوع محتوا در رتبهبندی گوگل کارایی لازم را ندارد.

با این حال گرافیت یادآور میشود که پایگاه داده Common Crawl شامل تمام اینترنت نیست، اما نمونه بزرگی و جامعی از دادههای آموزشی مدلهای زبانی بزرگ از همین منبع استخراج شده که نشانگر اهمیت آن است.

اما با توجه به اینکه بخش مهمی از محتوای پولی و اختصاصی وبسایتها که عمدتا نوشته انسان هستند در این دستاست حضور ندارند و دسترسی Common Crawl را مسدود کردهاند، میتوان استنباط کرد که سهم واقعی محتوای انسانی اینترنت، به ویژه از بخش با کیفیت و تاثیر گذار آن، بالاتر از آن چیزی است که در دادههای گزارش گرافیت مشاهده میکنیم.

در سالهای اخیر و با شهرت گرفتن هوش مصنوعی مولد، خلاصههای تولید شده توسط این ابزارها به بخش مهمی از تجربه جستجو و پرسشوپاسخ کاربران تبدیل شده است. اما گرچه برخی از خلاصههای تولیدشده توسط هوش مصنوعی در موتورهای جستوجو یا پلتفرمهای محتوایی عملکرد نسبتا خوبی دارند، نظرسنجی جدید مرکز تحقیقاتی Pew نشان میدهد که اعتماد عمومی به این خلاصهها پایین است.

طبق یافتههای این مرکز تنها ۲۰ درصد از کاربران خلاصههای هوش مصنوعی در جستجو را بسیار مفید یا کاملا مفید ارزیابی می:نند و تنها ۶ درصد از کاربران میگویند به این خلاصهها اعتماد زیادی دارند.

این آمار نشان میدهد که کاربران هنوز و بهویژه زمانی که موضوعات پیچیده، تحلیلی یا مبتنی بر نظر شخصی را مد نظر دارند، ترجیح میدهند تا مطالب نوشته انسان را مطالعه کنند.

در نگاه کلی یافتههای گزارش گرافیت نشان میدهد که آینده احتمالا در تسلط کامل نوشتههای هوش مصنوعی نخوهد بود و انسان و AI در یک قالب همزیستی و مکمل به فضای آینده وب شکل میدهند.

اگرچه نگرانیهایی دربارهی خفگی اینترنت با حجم بالای محتوای ماشینی وجود دارد، اما گزارش گرافیت نشان میدهد که حداقل در حال حاضر نشانهای از فروپاشی این نظام دیده نمیشود. موتورهای جستوجو همچنان محتوای انسانی را ترجیح میدهند و کاربران نیز بیش از هر چیز، دنبال اصالت، دقت و نگاه انسانی هستند.