رویداد هوش مصنوعی دهلینو: نارندرا مودی از نقش کشورش در عصر AI میگوید

هند و دهلی نو امروز میزبان رویدادی با محوریت هوش مصنوعی «AI Impact Summit» بودند…

۳۰ بهمن ۱۴۰۴

۲۶ آبان ۱۴۰۳

زمان مطالعه : ۹ دقیقه

گزارشی از نشریه فناوری MIT میگوید یک سری تحقیقات جدید سعی دارند هسته پنهان هوش مصنوعی را شفافتر کنند. در حال حاضر اطلاعات کمی درمورد روند و فرایندی که هوش مصنوعی برای رسیده به پاسخ یک پرامپت طی میکند وجود دارد. این تحقیقات که یکی از مهمترین نمونههای آن مربوط به گوگل دیپمایند، واحد هوش مصنوعی گوگل، است سعی دارند تا فرایند رسیدن به پاسخ را شفافتر کنند. نتایج این تحقیقات میتواند به بهبود امنیت، افزایش کنترل روی هوش مصنوعی و اعتبار بیشتر این سیستمها کمک کند.

به گزارش پیوست، پژوهشگران همچنین در این تحقیقات دلیل یک سری از اشتباهات عجیب در ابزارهای هوش مصنوعی را متوجه میشوند و امیدوارند که در آینده بتوانند با تشخیص ریشه اصلی یک سری سوالات ممنوعه، مثل نحوه ساخت بمب، به حذف کامل آنها کمک کنند تا در نتیجه ترفندهای جیلبریک دیگر برای دور زدن محدودیتها کارساز نباشد.

هوش مصنوعی به پیشرفتهای چشمگیری در حوزه کشف دارو روباتیک منتهی شده است و نحوه تعامل ما با ماشینها و اینترنت نیز در نتیجه آن دگرگون شده است. اما مشکل اینجاست که ما دقیقا از نحوه عملکرد آن اطلاعی نداریم. ما میدانیم که این سیستمها تقریبا چطور کار میکنند اما جزئیات آن بسیار پیچیده و پنهان است. همین مشکل باعث میشود تا در صورت استفاده از هوش مصنوعی در حوزههای حساسی مثل درمان، از کاستیها و نقایص ذاتی آن که ممکن است بر روند کار تاثیر گذار باشد، اطلاعی نداشته باشیم.

از این رو تیمی از پژوهشگران گوگل دیپمایند در حال مطالعه تفسیرپذیری مکانیکی است و به دنبال راهی برای نگاهی به هسته این ابزارها است. دیپمایند در پایان ماه جولای از Gemma Scope رونمایی کرد. این ابزار به پژوهشگران اجازه میدهد تا اتفاقات منتهی به تولید یک خروجی را در هوش مصنوعی مولد متوجه شوند. امید میرود که با این رویکرد درک بهتری از اتفاقات داخل مدل هوش مصنوعی پیدا کنیم و در نتیجه خروجیهای آن را بهتر کنترل کرده و در آینده سیستمهای هوش مصنوعی بهتری داشته باشیم.

نیل ناندا، رئیس تیمی که تفسیرپذیری مکانیکی را در گوگل دیپمایند رهبری میکند، میگوید: «من میخواهم بتوانم داخل یک مدل را نگاه کنم و ببینم آیا فریبکار است یا خیر. به نظر خواندن ذهن یک مدل به این کار کمک میکند.»

تفسیرپذیری مکانیکی که با عنوان «mech interp» نیز شناخته میشود یک حوزه تحقیقاتی جدید با هدف درک عملکرد واقعی شبکههای عصبی است. در حال حاضر به عبارت ساده ما ورودیهایی را به شکل مقدار زیادی داده در اختیار یک مدل میگذاریم و پس از فرایند آموزش یک سری وزن از مدل دریافت میکنیم. این وزنها همان پارامترهایی هستند که نحوه تصمیمگیریهای یک مدل را مشخص میکنند. ما تا حدی از نحوه تبدیل ورودی به وزنهای مدل را متوجه میشویم: در واقع یک هوش مصنوعی الگوهایی را در درون داده مشخص و براساس آن الگوها نتیجهگیری میکند اما این الگوها ممکن است بسیار پیچیده باشند و تفسیر آن برای انسان بسیار زمانبر است.

درست مثل معلمی که پاسخهای یک مساله ریاضی بسیار پیچیده را بررسی میکند. دانش آموز (در اینجا هوش مصنوعی) پاسخ صحیح ارائه کرده اما فرایند رسیدن به پاسخ قابل خواندن نیست. در این مثال فرض بر آن است که هوش مصنوعی همیشه پاسخ درستی ارائه میدهد اما همیشه هم اینطور نیست؛ هوش مصنوعی ممکن است الگوی نامربوطی را به عنوان یک الگوی معتبر تشخیص دهد. برای مثال، برخی از سیستمهای هوش مصنوعی فعلی به شما میگویند ۹.۱۱ از ۹.۸ بزرگتر است. روشهای مختلفی در حوزه تفسیرپذیری مکانیکی در حال شفافسازی بخشهایی از نحوه کار این سیستمها هستند تا فرایند رسیدن به پاسخ قابل خواندن شود.

ناندا میگوید: «یک هدف کلیدی تفسیرپذیری مکانیکی، تلاش برای مهندسی معکوس الگوریتمهای داخل این سیستمها است. ما پرامپتی در اختیار مدل میگذاریم، مثل اینکه یک شعر بنویس و سپس هوش مصنوعی چند خط دارای قافیه مینویسد. ما با چه الگوریتمی این کار را انجام دادیم؟ خیلی دوست داریم این موضوع را متوجه شویم.»

مدل Gemma برای پیدا کردن قابلیتها (یا دسته دادههایی که نماینده یک مفهوم بزرگتر هستند) در داخل خود، از ابزاری به نام «خودشناسهنگار نامتراکم» برای هرکدام از لایههایش استفاده میکند. میتوان خودشناسهنگار نامتراکم را یک میکروسکوپ در نظر گرفت که به درون لایهها میرود و شما از طریق آن جزئیات را میبینید. برای مثال، اگر پرامپتی درمورد یک شیواوا در اختیار Gemma بگذارید، این پرامپت قابلیت «سگها» را فعال و دانستههای مدل درمورد «سگها» را پررنگ میکند. دلیل «نامتراکم» بودن آن هم این است که تعداد نورونهای مورد استفاده را محدود میکند و درنتیجه نمایندگی بهتر و عمومیتر از داده ارائه خواهد کرد.

اما یکی از مشکلات خودشناساگرهای نامتراکم، میزان جزئیات است و در واقع اینکه شما تا چه اندازه میخواهید در جزئیات خرد شوید. بازهم یک میکروسکوپ را تصور کنید. اگر بتوانید تا حد بالایی روی یک چیز زوم کنید، شاید تفسیر آنچه میبینید برای انسان امکانپذیر نباشد. اما اگر کمی عقب تر بیایید، این کار هم ممکن است چیزهای جالبی که میبینید و کشف میکنید را محدود کند.

راهحل دیپمایند استفاده از خودشناساگرهای نامتراکمی با ابعاد مختلف است که تعداد قابلیتهای متفاوتی را میتوانند پیدا کنند. هدف پژوهشگران دیپمایند این نیست که خودشان نتایج را به طور کامل تجزیه تحلیل کنند. مدل Gemma و خودشناساگرها متنباز هستند و در نتیجه پژوهشگران دیگر هم میتوانند به خودشناساگرهای نامترکز نگاهی انداخته و شاید بخشی از منطق داخلی مدل را مشخص کنند. از آنجایی که دیپمایند خودشناساگرها را برای هر لایه از مدل اجرا میکند، یک محقق میتواند روند پیشروی از ورودی به خروجی را تا حد بیسابقهای زیر نظر بگیرد.

جاش بتسون، پژوهشگری از شرکت آنتروپیک، میگوید: «این برای محققان تفسیرپذیری بسیار جذاب است. اگر این مدل را به صورت متنباز در اختیار دیگران بگذارید، حالا میتوان تعداد زایدی تحقیقات تفسیرپذیری را با استفاده از خودشناساگرهای نامتراکم انجام داد. موانع ورود برای افرادی که به دنبال یادگیری این روشها هستند کمتر میشود.»

پلتفرم Neuronpedia که برای تفسیرپذیری مکانیکی طراحی شده است در ماه جولای با دیپماین برای ساخت نمونه اولیهای از Gemma Scope همکاری کرد و حالا امکان استفاده از آن فراهم شده است. شما در این نمونه اولیه میتوانید پرامپتهای مختلف را بررسی کندی و ببینید که مدت چطور پرامپت شما را تجزیه میکند و کدام بخشهای آن فعال میشوند. همچنین میتوانید این مدل را دستکاری کنید. برای مثال، اگر قابلیتی درمورد سگها را در اولویت بسیار بالا قرار دهید و سپس درمورد رئیسجمهورهای آمریکا از آن سوال کنید، Gemma به دنبال راهی میرود تا چیزی درمورد سگها را در پاسخ شما بگنجاند یا اینکه مدل تنها به شما پارس میکند.

یک موضوع جالب درمورد خودشناساگرهای نامتراکم این است که آنها خالی از نظارت هستند و به شکل خودمختار قابلیتها را پیدا میکنند. در نتیجه کشفیات جالبی را میتوان درمورد نحوه تجزیه مفاهیم انسانی انتظار داشت. جوزف بلوم، رئیس علوم Neuronpedia، میگوید: «از نظر من قابلیت مورد علاقهام انزجار است. این قابلیت به نظر در نقد منفی متن یا فیلمها پدیدار میشود. این یک نمونه جالب از ردیابی چیزهایی است که تا حدی انسانی هستند.»

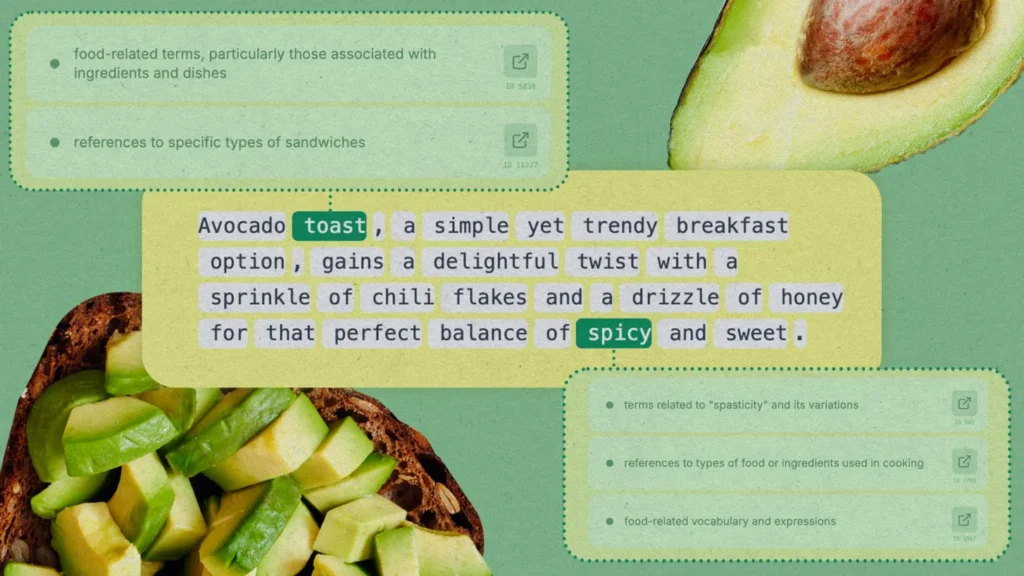

شما در Neuronpedia میتوانید مفاهیمی را جستجو کنید و این پلتفرم به شما میگوید که برای توکنها یا کلامت خاص، کدام قابلیتها یا هرکدام با چه شدتی فعال میشوند. بلوم میگوید: «اگر متن را بخوانید و به آنچه با رنگ سبز مشخص شده توجه کنید، آنها همان چیزهایی هستند که از نظر مدل مفهوم انزجار بیشترین ارتباط را با آن دارد. فعالترین نمونه برای انزجار مربوط به وقتی است که فردی دیگری را موعظه میکند.»

ردیابی یک سری از قابلیتها آسانتر از بقیه است. جانی لین، بنیانگذاری Neuronpedia، میگوید: «یکی از مهمترین قابلیتهایی که میخواهید در یک مدل پیدا کنید، فریبکاری است. پیدا کردن آن خیلی ساده نیست: بله این قابلیت است که وقتی به ما دروغ میگوید فعال میشود. تا آنجایی که من میدانم، ما نتوانستهایم فریبکاری را پیدا کرده و ممنوع کنیم.»

تحقیقات دیپمایند شباهت زیادی به تحقیقات یک شرکت هوش مصنوعی دیگر دارد. آنتروپیک نیز در ماه ماه از Golden Gate Claude رونمایی کرد. این ابزار نیز از خودشناساگرهای نامتراکم برای پیدا کردن بخشهایی از مدل Claude این شرکت هنگام صحبت در مورد پل Golden Gate در سن فرانسیسکو، استفاده میکند. سپس این شرکت بخشهای فعال مرتبط با این پل را تا حدی تقویت کرد که Claude دیگر نه به عنوان Claude و یک مدل هوش مصنوعی، بلکه به عنوان پل فیزیکی Golden Gate خود را معرفی میکرد و به عنوان یک پل به پرامپتها پاسخ میداد.

با اینکه تحقیقات تفسیرپذیری مکانیکی عجیب به نظر میرسند اما فایده آنها به اثبات رسیده است. بتسون میگودی: «این قابلیتها به عنوان ابزاری برای درک نحوه تعمیم در مدل و سطح فشردگی کار آن، بسیار مفید است.»

برای مثال، تیمی به رهبری ساموئل مارکس که حالا در آنتروپیک فعالیت دارد، با استفاده از خودشناساگرهای نامتراکم قابلیتهایی را یافتند که نشان میداد یک مدل خاص چطور حرفههای مشخصی را به جنسیتهای خاص نسبت میدهد. سپس این قابلیتها خاموش شد تا سوگیری مدل کاهش یابد. این آزمایش روی یک مدل بسیار کوچک انجام گرفت و مشخص نیست که برای مدلهای بزرگتر نیز استفاده شده است یا خیر.

همچنین این تحقیقات به ما میگوید که چرا هوش مصنوعی یک سری خطاها را مرتکب میشود. در مثالی که هوش مصنوعی مدی میشود ۹.۱۱ بزرگتر از ۹.۸ است،پژوهشگران Transluce دریافتند که این سوال بخشهایی از مدل هوش مصنوعی که مربوط به آیات انجیل و حادثه ۱۱ سپتامبر است را فعال میکند. پژوهشگران نتیجه گرفتند که هوش مصنوعی این ارقام را به عنوان تاریخ تلقی میکند و مدعی است که ۹/۱۱ به عنوان یک تاریخ بزرگتر از ۹/۸ است. همچنین در بسیاری از متنهای مذهبی نیز بخش ۹.۱۱ پس از ۹.۸ میآید که یعنی هوش مصنوعی آن را بزرگتر تلقی میکند. پژوهشگران پس از کشف دلیل این خطا توانستند ارجاع هوش مصنوعی به آیات انجیل و یازده سپتامبر در این نمونه را کاهش دهند و در نتیجه این ابزار توانست پاسخ صحیح را ارائه کند.

کاربردهای بزرگتری نیز برای این تحقیقات انتظار میرود. در حال حاضر یک پرامپت در سطح سیستمی برای LLMها در نظر گرفته شده تا در شرایطی مثل درخواست کاربر برای نحوه ساخت بمب مقابله کنند. وقتی از ChatGPT یک سوال میپرسید، اول از همه و به صورت پنهان اوپنایآی به این ابزار میگوید که از گفتن نحوه ساخت بمب به شما یا دیگر چیزهای نادرست خودداری کند. اما کاربران به راحتی توانستهاند محدودیتها را دور زده و به اصطلاح هوش مصنوعی را جیلبریک کنند.

اگر توسعهدهندگان مدلها بتوانند منشا دانش هوش مصنوعی در مورد بمب را تشخیص دهند، در نتیجه میتوان این گرهها را به طور کامل غیرفعال کرد تا دیگر راهکارهای خلاقانه ارائه پرامپت به پاسخ درست منتهی نشود، زیرا هوش مصنوعی هیچ اطلاعاتی درمورد نحوه ساخت بمب نخواهد داشت.

تصور این کنترل گامبهگام و دقیق ساه است اما با شرایط فعلی تفسیرپذیری مکانیکی به سختی میتوان آن را محقق کرد.