قطعی اینترنت و ترور نامرئی آینده هوش مصنوعی

در قرن بیستویکم، هیچ فناوریای به اندازه هوش مصنوعی به «اتصال» وابسته نیست. برخلاف صنایع…

۲۰ بهمن ۱۴۰۴

۱ مرداد ۱۴۰۳

زمان مطالعه : ۵ دقیقه

هدف یادداشت پیش رو بررسی این است که مفهوم عدالت چه راهنماییهایی میتواند برای سیاستگذاری در زمینه هوش مصنوعی ارائه دهد. به نظر میرسد که عدالت رالزی تاکید دارد که دسترسی و استفاده منصفانه برای همه افراد باید تضمین شود و شفافیت و مسئولیتپذیری در تصمیمسازیهای مربوط به این فناوریها رعایت شود.

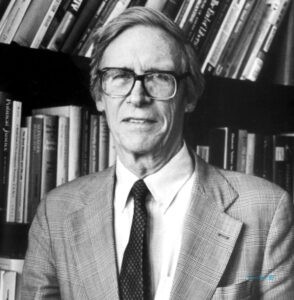

جان رالز (۱۹۲۱-۲۰۰۲) فیلسوف سیاسی لیبرال آمریکایی بر اهمیت مفهوم عدالت و اصول اخلاقی در سازماندهی جامعه مدرن تاکید داشت و بر این باور بود که دولت در برابر نابرابریها مسئولیتهایی دارد. او در کتاب «نظریهای در باب عدالت»، این ایده را طرح کرد که اعضای یک جامعه باید آزادیهای اساسی برابر و نیز برابری فرصت داشته باشند. بر چنین اساسی، هرگاه نابرابری ایجاد شود، باید بیشترین نفع به محرومترین اعضای جامعه برسد.

با چنین رویکردی، یکی از اهداف کلیدی سیاستگذاری پایدار در زمینه هوش مصنوعی باید اطمینان از عدالت در بهرهبرداری از این فناوری در تمامی جوامع باشد. این شامل ایجاد فرصتهای برابر دسترسی به فناوری برای همه شهروندان، جلوگیری از افزایش تفاوتهای اجتماعی، و کمک به حل مشکلات اجتماعی و اقتصادی است.

یعنی باید از بازتولید تبعیض و تضییع حقوق انسانی -به معنای مفاد متن بیانیه جهانی حقوق بشر- در طراحی و استفاده از الگوریتمها و سیستمهای هوش مصنوعی جلوگیری کرد و محیطی عادلانه برای توسعه، استفاده و انتشار فناوری هوش مصنوعی فراهم آورد. بر این اساس چند نکته شایان توجه است که در ادامه به آنها میپردازم.

در الگوریتمهای تحلیل رزومه برای انتخاب کارمندان، تصمیمگیری ممکن است بر اساس دادههای تاریخی صورت گیرد؛ دادههایی که ممکن است دربرگیرنده خطاهای شناختی، تعصبات و سوگیریهایی نسبت به جنسیت و نژاد باشند، این سوگیریها به تصمیمات الگوریتم نیز منتقل شوند.

در نمونه دیگر میتوان چنین در نظر گرفت که اگر در تاریخ ِیک شرکت، تمایل بیشتری به استخدام مردان وجود داشته باشد، الگوریتم ممکن است با الگوبرداری از این روند، متقاضیان زن را کمتر انتخاب کند. یا از این واقعیت که در بسیاری جوامع به دلایل مختلف، سطح دستمزد زنان در قبال کار مساوی، پایینتر از مردان است نتیجه گرفته شود که در آینده نیز باید چنین باشد.

در سیستمهای قضایی ممکن است الگوریتمی برای پیشبینی تکرار جرم طراحی شود که از دادههای تاریخی استفاده میکند و منجر به پیشبینی ناعادلانه درباره مهاجران یا رنگینپوستان شود. در سیستمهای مالی ممکن است الگوریتمهایی برای ارزیابی اعتبار بانکی بر اساس دادههای گذشته، بازتولیدکننده تبعیضهای اقتصادی باشد.

این موضوع میتواند دسترسی گروههای اقلیت و فرودست به خدمات مالی و وام را دشوار کند. در این مثالها تاکید بر دقت در طراحی و ارزیابی الگوریتمها، استفاده از دادههای متنوع و بدون سوگیری و نیز نظارت مستمر بر عملکرد سیستمها میتواند به کاهش تبعیض، کاهش تعصبات، و صیانت از حقوق انسانی کمک کند.

به معنای اطمینان از این است که همه افراد و اجتماعات، بدون تبعیض، به ابزارهای هوش مصنوعی و مزایای آن دسترسی داشته باشند و این میتواند شامل تکتک شهروندان با پسزمینهها و ظرفیتهای مختلف اقتصادی، مالی، اجتماعی، و فرهنگی باشد.

برای مثال در تبلیغات آنلاین ممکن است بر اساس دادههای موجود، آگهیهای شغلی مشخصی تنها به گروههای مشخصی (مثلا شهرها و ملیتهای خاص، جنسیت خاص یا فارغالتحصیلان دانشگاههای خاص) نشان داده شود و بهرهمندی دیگران از این فرصتها محدود شود.

عدالت در استفاده به این مفهوم است که استفاده از فناوری هوش مصنوعی با ارزشهای انسانی و حقوق پایه همراستا باشد و از بروز خطاها یا سوءاستفادههای عمدی یا سهوی بر علیه آن جلوگیری شود. به عنوان مثال، مناطق روستایی یا جوامع کمبرخوردار ممکن است به دلیل کمبود دادههای تاریخی یا نادیده گرفتن نیازهای خاصشان، از منابع بهداشتی کمتری بهرهمند شوند.

برای نمونه نباید الگوریتمهایی که به تصمیمات پزشکی میانجامند، تنها بر اساس دادههای گردآوری شده از گروههای خاصی متکی باشند. مثلا برخی الگوریتمهای تشخیص بیماری قلبی ممکن است در مورد زنان دقت کافی را نداشته باشند؛ چرا که علائم این بیماریها در میان زنان و مردان تفاوتهایی دارد و این منجر به تاخیر در تشخیص یا درمانهای ناکارآمد میشود.

همانگونه که ذکر شد این به معنای توزیع منصفانه تاثیرات مثبت/منفی فناوری هوش مصنوعی است. به این ترتیب که باید از ایجاد نابرابریهای جدید یا تشدید نابرابریهای موجود در جهان به دلیل استفاده از ابزارهای هوش مصنوعی پرهیز شود. به عبارت دیگر، نباید اجازه داد شرایطی فراهم شود که تبعیضهای تاریخی موجود در دادهها بازتولید شوند.

یعنی ایجاد شفافیت در تصمیمگیریها و عملکرد سیستمهای هوش مصنوعی و قبول مسئولیت از طرف سازمانها و دولتها برای تاثیراتی که بر جامعه و افراد میگذارند. این بدان مفهوم است که کاربران بتوانند نحوه عملکرد این سیستمها را درک کنند و در صورت بروز اشتباه، امکان طرح پیشنهادهای اصلاح فراهم باشد. مثلا در زمینه استفاده از پهپادهای نظامی، معیارهای دقیقی درنظر گرفته شود و بر شلیک به اهداف نظامی و غیرنظامی یا هر خسارت دیگری این نظارت وجود داشته باشد که عملکرد مطابق با قوانین بینالمللی و حقوق بشر باشد.

یعنی فراهم کردن فرصت دموکراتیک برای مشارکت عمومی و شرکت آحاد شهروندان در فرآیند تصمیمگیری و سیاستگذاری مرتبط با هوش مصنوعی تا از این اطمینان حاصل شود که نیازها و مصالح همه شهروندان متکثر جامعه در نظر گرفته خواهد شد و اعتماد عمومی جلب میشود.

این بهویژه به هنگام تدوین قوانین و مقررات برای استفاده از هوش مصنوعی اهمیت پیدا میکند. مثلا ایجاد پلتفرمهای آنلاین برای انعکاس دغدغهها و پیشنهادها به طوری که از دورافتادهترین مناطق امکان شرکت در فرآیندهای تصمیمگیری فراهم باشد. یا تشکیل کمیتههای مشورتی که شامل نمایندگان گروههای مختلف اقتصادی، فرهنگی، و اجتماعی باشد. اطلاعرسانی دقیق و شفاف در عرصه عمومی میتواند آگاهی عمومی و شرکت در فرآیندها را سادهتر کند.

در نهایت میتوان گفت بهکارگیری مفهوم عدالت در سیاستگذاری هوش مصنوعی به معنای تضمین استفاده منصفانه و بیطرفانه این فناوریها برای همه شهروندان جامعه بشری است. این استفاده باید با ارزشها و اصولی همچون عدالت و شفافیت سازگار باشد و به تقویت حقوق بشر و ارزشهای اخلاقی-انسانی بیانجامد.