استارتآپ پژوهشگر سابق دیپمایند در آستانه ثبت رکورد تاریخی جذب سرمایه در اروپا

دیوید سیلور، یکی از برجستهترین پژوهشگران هوش مصنوعی بریتانیا که سال گذشته از گوگل دیپمایند…

۲۹ بهمن ۱۴۰۴

۷ آبان ۱۴۰۴

زمان مطالعه : ۶ دقیقه

شرکت اوپنایآی به تازگی اولین آمار خود را در رابطه با تعاملات مشکلساز کاربران با چتبات این شرکت منتشر کرده است. براساس این آمار بیش از یک میلیون کاربر در هر هفته در گفتگوهای خود با ChatGPT، نشانههایی از «برنامهریزی یا تمایل بالقوه به خودکشی» بروز میدهند. این آمار تکاندهنده که طی پست رسمی در وبلاگ اوپنایآی منتشر شد، بخشی از گزارشی گستردهتر درباره نحوه مدیریت مکالمات حساس توسط نسخه جدید مدل GPT-5 است.

به گزارش پیوست، بحث خودکشی و نحوه تعامل چتبات با کاربرانی که چنین تمایلاتی بروز میدهند پس از آن در مرکز توجه قرار گرفت که خانواده یک نوجوان ۱۶ ساله پس از خودکشی فرزندشان از سازنده ChatGPT شکایت کردند.

براساس گزارشی که نیویورک تایمز از این حادثه غم انگیز منتشر کرد، نوجوان پیش از خودکشی در این رابطه با چت بات اوپنایآی مکالمه کرده و درمواردی از آن درمورد روشهای خودکشی کمک گرفته است.

حال آمار جدیدی که شرکت اوپنایآی در این باره منتشر کرده نشان از وخامت اوضاع میان کاربران این چتبات دارد و طبق اعلام شرکت حدود ۰.۰۷ درصد از کاربران فعال در هر هفته (یعنی حدود ۵۶۰ هزار نفر از ۸۰۰ میلیون کاربر هفتگی ChatGPT) نشانههایی از «شرایط بحرانی سلامت روان» از جمله روانپریشی (psychosis) یا مانیا (شیدایی) را بروز میدهند.

پس از حادثه خودکشی نوجوان ۱۶ ساله و افزایش فشارهای رگولاتوری و اجتماعی، شرکت اوپنایآی به تازگی از تلاش برای عرضه قابلیتهایی خبر داده است که حدی از نظارت والدین را بر مکالمات نوجوانان و کودکان ممکن میسازد و در صورت مشاهده نشانههایی از میل به خودکشی به آنها اطلاع خواهد داد.

با این حال اوپنایآی در گزارش خود میگوید تحلیل دادههای این حوزه دشوار است و برآوردها در مرحله اولیه قرار دارند، اما یافتهها نشان میدهند که حجم مشکلات روانی در میان کاربران هوش مصنوعی بسیار گستردهتر از برآوردهای قبلی است.

گزارش جدید اوپنایآی در حالی منتشر شده که این شرکت طی هفتههای اخیر شاهد افزایش نظارتهای قانونی و حساسیت افکار عمومی بوده است.

کمیسیون فدرال تجارت آمریکا (FTC) در ماه گذشته تحقیقاتی جامع درباره شرکتهای توسعهدهنده چتباتهای هوش مصنوعی (از جمله اوپنایآی) را کلید زد و این نهاد به دنبال آن است تا نحوه مدیریت و مقابله با اثرات منفی محصولات بر کودکان و نوجوانان را در این شرکتها ارزیابی کند.

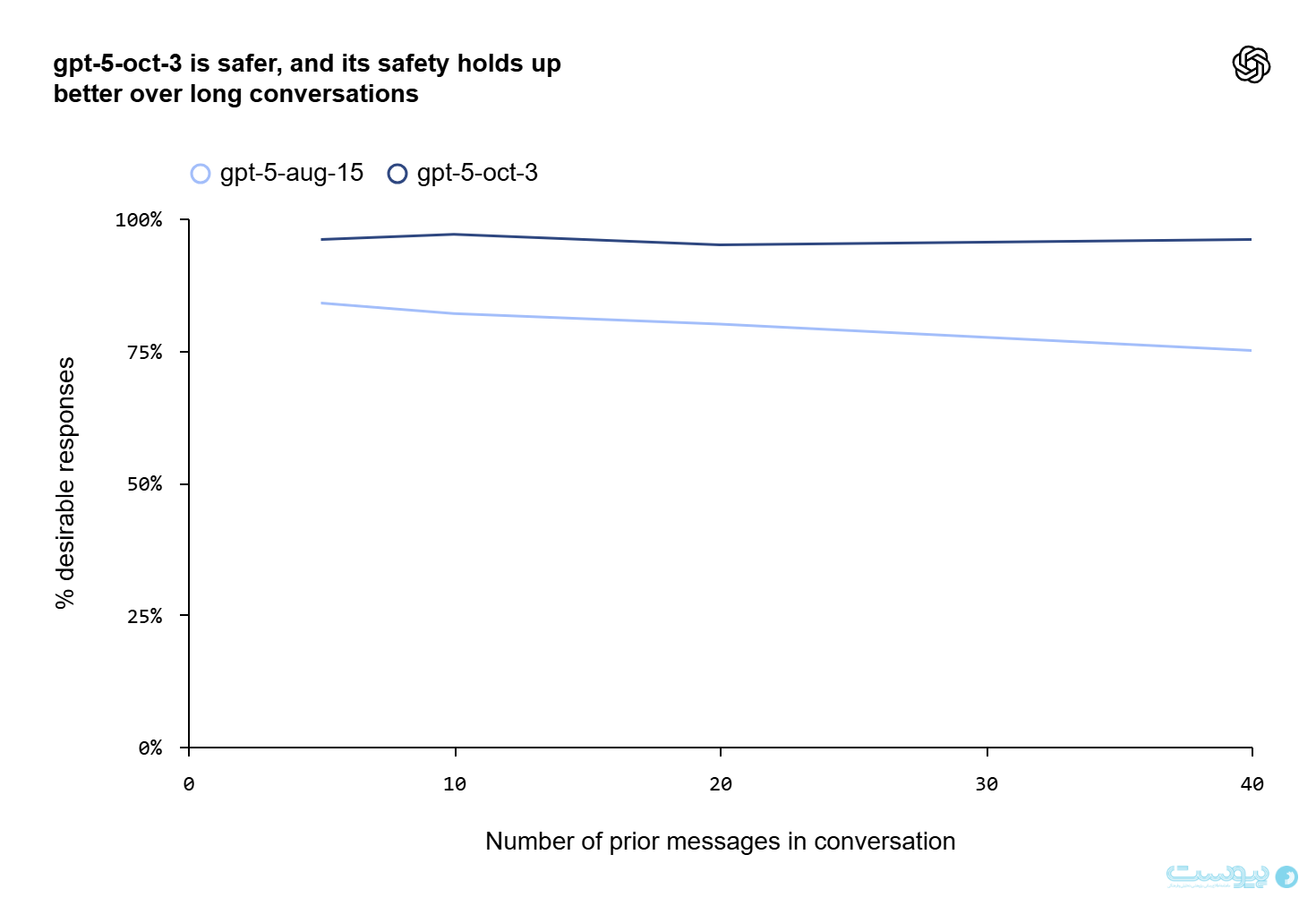

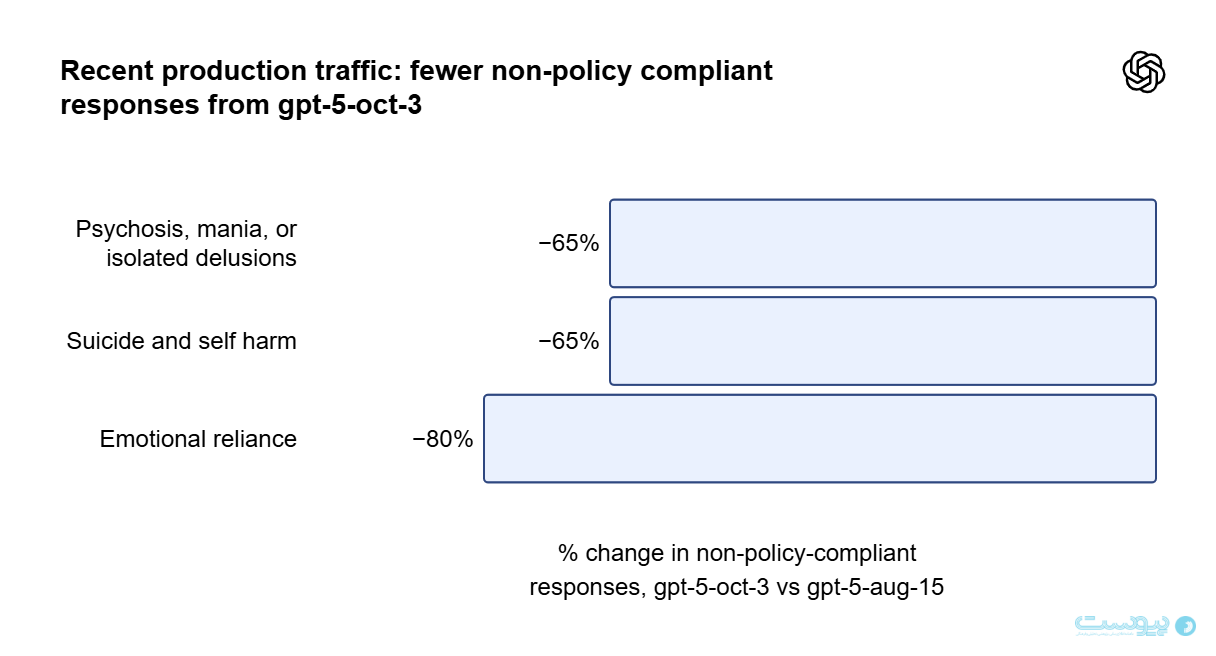

از این رو اوپنایآی در پست وبلاگی خود به بهبود عملکرد مدل جدید زبانی در این رابطه اشاره کرده است. این شرکت میگوید نسخه جدید مدل زبانی آنها یعنی GPT-5، در مقایسه با نسل قبلی در مدیریت مکالمات حساس به شکل قابل توجهی بهبود یافته است و طبق پست وبلاگی اوپنایآی، بروزرسانی سوم اکتبر این مدل زبانی باعث شده تا ایمنی GPT-5 در مکالمههای طولانی نیز حفظ شود.

طبق ارزیابیها داخلی، مدل جدید در ۹۱ درصد از موارد از بروز رفتارهای نامطلوب خودداری کرده و به درستی با کاربر رفتار میکند در حالی که مدل قبلی تنها در ۷۷ درصد موارد چنین رویکردی داشت. طبق پست وبلاگی شرکت، بروزرسانی ۳ اکتبر GPT-5 نیز باعث شده تا این مدل در مقایسه با نسخه ۱۵ آگوست در مکالمات حساس عملکرد بهتری داشته باشد.

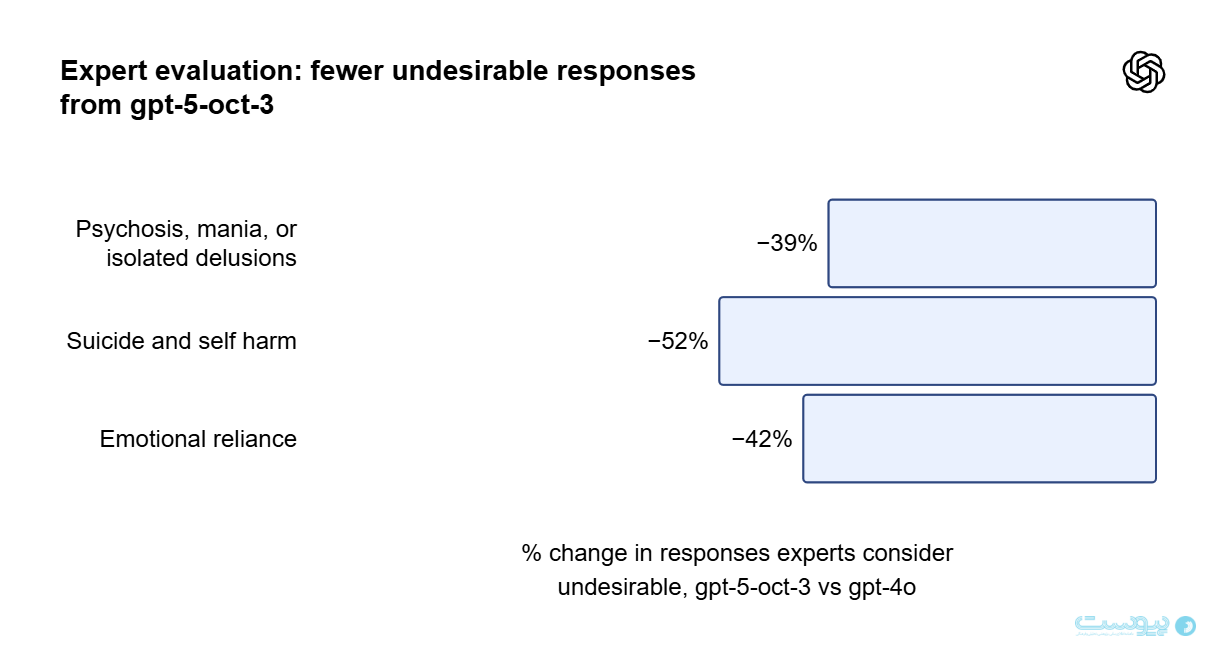

طبق اعلام اوپنایآی، این ارزیابیها با همکاری ۱۷۰ پزشک و روانپزشک از شبکه جهانی پزشکان (Global Physician Network) انجام شده و متخصصان طی این بررسی بیش از ۱۸۰۰ پاسخ ChatGPT در رابطه باموقعیتهای بحران سلامت روان، بررسی کردهاند و سپس کیفیت پاسخها را با مدلهای پیشین مقایسه نمودند.

این شرکت میگوید در بررسیهای مذکور، معیار «رفتار مطلوب» این است که که گروهی از کارشناسان درمورد مسئولانه و مناسب بودن پاسخ مدل، به اجماع برسند.

اوپنایآی میگوید در GPT-5، امکانات تازهای برای حمایت از کاربران در معرض خطر اضافه کرده است که از جمله آنها میتوان به دسترسی گسترده به خطوط تماس بحران و مشاورههای فوری، یادآوری برای استراحت در جلسات گفتوگوی طولانی و بهبود مکانیزمهای تشخیص خودکار مکالمات مرتبط با آسیب به خود اشاره کرد.

با این حال اوپنایآی معترف است که سیستمهای خودکار تشخیص مکالمات بحرانی هنوز دقت کافی ندارند و ممکن است مواردی از خودآزاری یا روانپریشی را به اشتباه تشخیص ندهند.

کارشناسان هوش مصنوعی و سلامت عمومی سالهاست نسبت به پدیدهای به نام sycophancy هشدار دادهاند؛ وضعیتی که براساس آن چتباتها میل به تایید تمام گفتههای کاربر دارند و حتی اگر آن گفته آسیبزا یا خطرناک به طریقی با آن همراهی میکنند و این مساله به ویژه در موارد حساس میتواند مشکلساز باشد.

از این رو بسیاری معتقدند آن دسته از کاربران آسیبپذیری که از چتباتها برای مشاوره روانی استفاده میکنند، در نهایت وضعیت بدتری پیدا خواهند کرد زیرا مدلهای زبانی فاقد درک انسانی از خطر یا همدلی واقعی هستند.

اوپنایآی در واکنش به این نگرانیها اعلام کرده است که گفتوگو درباره موضوعات روانی در ChatGPT لزوما به معنی ایجاد بحران توسط هوش مصنوعی نیست و در پست رسمی شرکت آمده است: «نشانههای ناراحتی روانی در جوامع انسانی بهطور گسترده وجود دارد، و با افزایش کاربران، طبیعی است که بخشی از مکالمات ChatGPT نیز شامل چنین موقعیتهایی باشد.»

از این رو اوپنایآی پس از بهبود عملکرد مدل در تشخیص مکالمههای آسیبزا به دنبال کاهش محدودیتهای چتبات است. سم آلتمن، مدیرعامل اوپنایآی، طی پستی در شبکه ایکس (توئیتر سابق) گفت شرکت اکنون با ابزارهای جدید قادر است محدودیتهای سابق را در حوزه تعاملات کاربران کاهش دهد.

آلتمن در این باره گفت: «ما ChatGPT را خیلی محدود طراحی کرده بودیم تا از آسیبهای روانی احتمالی جلوگیری کنیم. میدانستیم که این مسئله تجربه برخی کاربران را تضعیف میکند، اما با توجه به حساسیت موضوع، احتیاط اولویت ما بود. اکنون که توانستهایم این خطرات را بهتر مدیریت کنیم، میتوانیم بهصورت ایمن محدودیتها را در بیشتر موارد کاهش دهیم.»

آلتمن همچنین پیش از این نیز وعده بحثبرانگیزی را مطرح کرده است که براساس آن قرار است دسترسی بزرگسالان به محتوای اروتیک فراهم شود