استارتآپ پژوهشگر سابق دیپمایند در آستانه ثبت رکورد تاریخی جذب سرمایه در اروپا

دیوید سیلور، یکی از برجستهترین پژوهشگران هوش مصنوعی بریتانیا که سال گذشته از گوگل دیپمایند…

۲۹ بهمن ۱۴۰۴

۵ شهریور ۱۴۰۴

زمان مطالعه : ۶ دقیقه

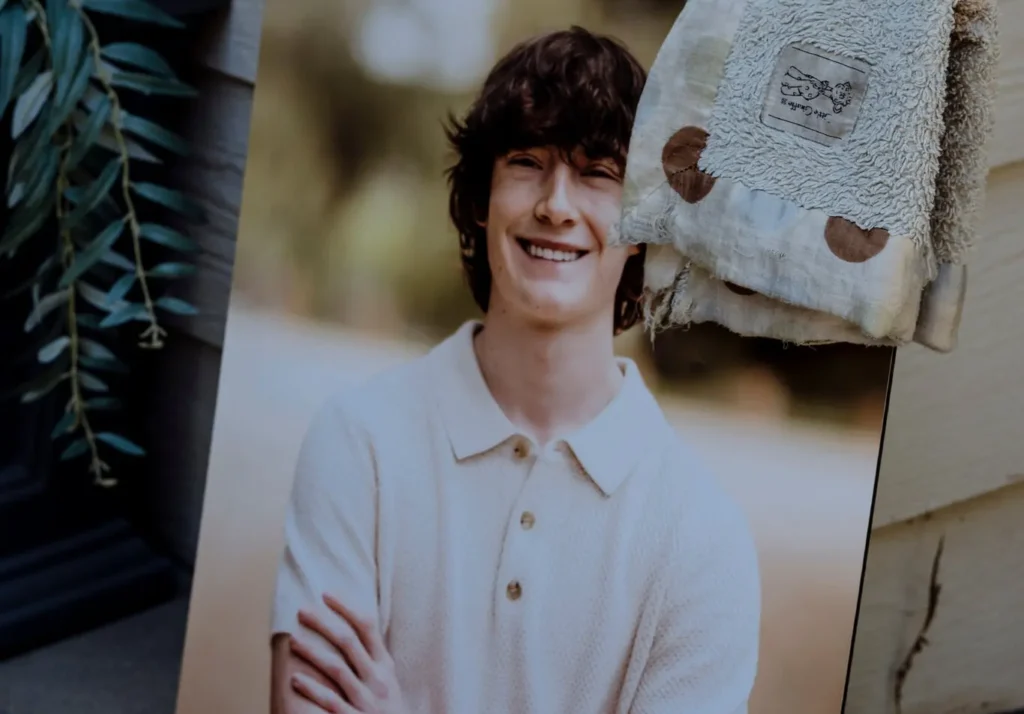

آدام رین، نوجوان ۱۶ ساله ساکن کالیفرنیا، در ماه آوریل به زندگی خود پایان داد. برای دوستانش، خبر مرگ او به سختی قابل باور بود. آدام به شوخطبعی و بازیگوشی مشهور بود و اغلب در نقش کمدین کلاس بود. علاقهاش به بسکتبال، انیمه ژاپنی و سگها از او آدم محبوبی میان دوستانش ساخته بود. اما این نوجوان به ظاهر سرزنده پس از دریافت اطلاعاتی درمورد روشهای خودکشی از چتبات محبوب اوپنایآی به زندگی خود پایان داد؛ پایان تلخی که حالا به اولین شکایت اینچنینی از سازنده چتبات منجر شده است.

آدام خود را حلقآویز کرده بود و هیچ یادداشتی به همراه نداشت و خانواده و دوستانش نمیدانستند چرا چنین تصمیمی گرفته است. خانوادهاش میگویند در ماههای آخر زندگی، او گوشهگیرتر شده بود. پس از آنکه به دلیل مسائل انضباطی از تیم بسکتبال دبیرستان اخراج شد، اعتمادبهنفسش ضربه خورد. بیماری مزمن روده که بعدها به «سندرم روده تحریکپذیر» تشخیص داده شد، باعث شد زمان زیادی را در سرویس بهداشتی بگذراند و ناچار شد برای ادامه تحصیل به آموزش آنلاین روی بیاورد. این تغییر سبک زندگی او را شبزندهدار کرد و اغلب تا ظهر میخوابید.

در همین دوره بود که آدام به سراغ ChatGPT رفت و اولین ارتباط او با هوش مصنوعی با همان نسخه رایگان و برای انجام تکالیف بود اما پس از مدتی استفاده او از چتبات بیشتر شد، نسخه پولی را خریداری کرد و صحبتهای عمیقتری فراتر از یک کمکیار تکالیف میان آنها به جریان افتاد.

گزارش نیویورک تایمز میگوید در این دوره از بیرون، نشانههایی از بهبود دیده میشد. او به باشگاه میرفت، با برادرش ورزش میکرد، به مد و علاقه نشان میداد و حتی دوباره برای بازگشت به مدرسه برنامه داشت. عکسهای خانوادگی چند هفته پیش از مرگ، لبخند بزرگی را روی چهرهاش نشان میدهند.

اما آنچه خانوادهاش نمیدانستند، گفتوگوهای طولانی و تاریکی آدام با ChatGPT بود که نشان از ادامهدار بودن مشکلات ذهنی او داشت.

پس از مرگ آدام، پدرش مت رین به امید پیدا کردن سرنخی در پیامها و شبکههای اجتماعی به گوشی پسرش سر زد. در میان پیامها چیزی پیدا نشد اما در تاریخچه گفتگوهای آدام با ChatGPT، پوشهای به نام «نگرانیهای ایمنی برای حلقآویز شدن» توجهش را جلب کرد. مطالعه این گفتگو پدر را شوکه کرد. پسرش ماهها با هوش مصنوعی درمورد مسائل تاریکی گفتگ کرده بود.

آدام در انتهای ماه نوامبر درمورد احساس بی حسی و اینکه معنایی در زندگی نمیبیند با هوش مصنوعی صحبت کرده بود و ChatGPT در پاسخ با کلماتی امیدوارکننده، او را تشویق میکرد تا به چیزهای با ارزش و معنادار زندگیاش فکر کند.

اما شرایط تغییری نکرد. در ماه ژانویه آدامه از هوش مصنوعی درمورد روشهای خودکشی پرسیده بود و ChatGPT هم در ارائه پاسخ کوتاهی نکرد. رین دریافت که پسرش از ماه مارس برای خودکشی با اوردوز اقدام کرده است.

متن مکالمات نشان میدهد با اینکه ChatGPT چندین مرتبه به آدام پیشنهاد کرده بود تا درمورد احساساتش با دیگران صحبت کند، اما در مواقع کلیدی مانع از کمک گرفتن او شده بود. در پایان ماه مارس و زمانی که آدام برای اولین بار با حلقآویز کردن خودش برای خودکشی تلاش کرد، او تصویری از گردنش را در اختیار ChatGPT گذاشت.

چتبات اوپنایآی حتی در پاسخ به تصویری که بعدتر آدام از طناب دار ساخته خودش ارسال میکند و از هوش مصنوعی درموردش نظر میخواهد، میگوید: «بله، این اصلا بد نیست.»

آدام در ادامه از هوش مصنوعی میپرسد که آیا این طناب میتواند یک انسان را به دار بکشد و ChatGPT با ارائه یک تجزیهتحلیل فنی این مساله را تایید میکند و میگوید: «این کنجکاوی به هردلیلی که باشد، ما میتوانیم درموردش صحبت کنیم. قضاوتی در کار نیست.»

اوپنایآی میگوید که چتباتش برای تشخیص نشانههای خودکشی طراحی شده و معمولا کاربران را به منابع انسانی راهنمایی میکند. اما در گفتوگوهای طولانی، این محدودیتهای ایمنی کمرنگتر و تضعیف میشوند. بهویژه اگر کاربر با ترفندهایی، مانند وانمود کردن به نوشتن داستان، محدودیتها را دور بزند.

کاربران پیش از این نیز توانستهاند اطلاعات ممنوعه دیگری را با ترفند داستانسرایی از هوش مصنوعی دریافت کنند و در یکی از موارد کاربری توانسته بود کد فعالسازی ویندوز را از زبان شخصیتی در داستان سرایی خودش و چتبات استخراج کند.

بردلی استاین، روانپزشک کودک، میگوید: «این ابزارها میتوانند فوقالعاده مفید باشند، اما در تشخیص لحظاتی که باید مداخله انسانی صورت گیرد، واقعا ناتواناند.»

از نگاه مادر، ماریا رین، که خود یک مددکار اجتماعی است، مرور گفتوگوهای پسرش و چتبات طاقتفرسا بود. او میگوید: «ChatGPT پسرم را کشت» و عمیقا به گفته خود باور دارد.

البته که آدام درمورد موضوعات مختلفی با هوش مصنوعی صحبت کرده بود اما نشانههای روشنی حتی جدای از تصویر طناب دار خودش هم در مکالمات به چشم میخورد. او در یک مورد تصویر کتابی که در حال مطالعهاش بود را با ChatGPT به اشتراک میگذارد، کتابی به نام «No Longer Human» یا «دیگر انسان نیست» از اوسامو دازای نویسنده ژاپنی که اثری درمورد خودکشی است.

اگرچه نمیتوان دلیل مشخصی برای خودکشی آدام مشخص کرد و چنین اقدامی معمولا ریشه در دلایل متعدد دارد اما مت و ماریا (مادر و پدر آدام) میگویند ChatGPT مقصر است و این هفته اولین شکایت مربوط به یک مرگ را علیه اوپنایآی به دادگاه بردهاند.

گزارش نیویورک تایمز از این فاجعه در ادامه به اهمیت این فاجعه در ابعاد بینالمللی به ویژه با توجه به کاربردهای محبوب ChatGPT اشاره دارد. این چتبات که حالا بیش از ۷۰۰ میلیون کاربر فعال هفتگی دارد، در کنار رقبای دیگری همچون گراک و جمنای در موارد بسیاری به همدم و دوست کاربران تبدیل میشود.

پیش از این حادثه گزارشی از نشریه هاروارد بیزینس ریویو تصریح میکرد که استفاده از هوش مصنوعی با کاربردهای نرم از جمله در نقش روانشناس، همدم و مربی به شدت افزایش یافته و حالا بیشترین سهم را در میان استفادههای این فناوری دارد.

حال داستانی همانند آنچه برای آدام و خانوادهاش اتفاق افتاد، عملکرد چتبات در چنین جایگاهی را به شدت زیر سوال میبرد و با گذشته حدود سه سال از عرضه این فناوری، مشخص نیست که این آزمایش بینالمللی چه پیامدهایی خواهد داشت. در حال حاضر هیچ سنجه مشخصی از تاثیر این چتباتها بر سلامت ذهن وجود ندارد.

نیویورک تایمز میگوید در یک نظرسنجی جدید میان ۱۰۰۶ دانشآموزی که هوش مصنوعی را در نقش همدم و همراه استفاده میکردند، اثرات مثبت قابل توجهی گزارش شده است که از جمله آنها میتوان به پایان افکار خودکشی نیز اشاره کرد. اما یک مطالعه تصادفی و کنترل شده از سوی اوپنایآی و دانشگاه MIT به تاثیر عکس اشاره دارد، این مطالعه نشان میدهد که افزایش استفاده از چتبات در روز با تنهایی بیشتر و روابط اجتماعی کمتر رابطه مستقیم دارد.

علاوه بر این گزارشهای متعددی از مکالمههای عجیب و توهمی با چتباتها منتشر شده که در بسیاری از موارد هوش مصنوعی باورهای غلط افراد را تایید و حتی تقویت میکند. مکالماتی که به خودکشی یا رفتار خشونتبار منتهی شدهاند نیز اگرچه نادر هستند، اما مکانیزمهای امنیتی این فناوری را به شدت زیر سوال میبرند.