رویداد هوش مصنوعی دهلینو: نارندرا مودی از نقش کشورش در عصر AI میگوید

هند و دهلی نو امروز میزبان رویدادی با محوریت هوش مصنوعی «AI Impact Summit» بودند…

۳۰ بهمن ۱۴۰۴

۱ مرداد ۱۴۰۳

زمان مطالعه : ۵ دقیقه

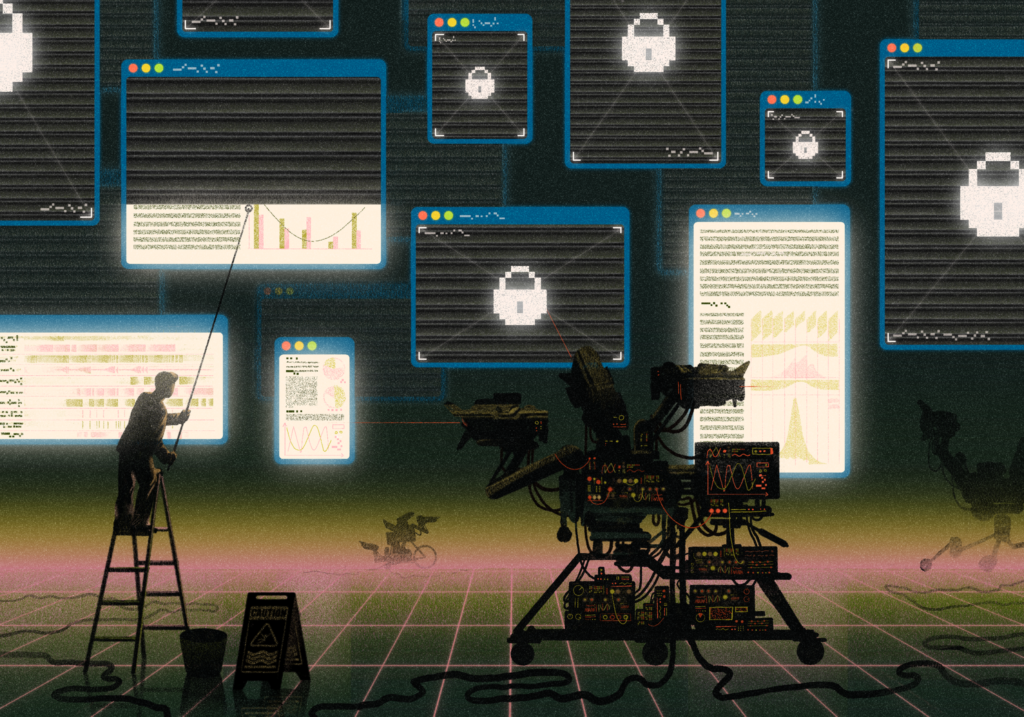

سیستمهای هوش مصنوعی در سالهای گذشته از دسترسی بی حد و مرز به اطلاعات متنی، تصاویر و ویدیوها نفع بردهاند و همین موضوع به خلق مدلهای قدرتمندی مثل GPT-4 یا جمنای از گوگل منجر شد. اما مطالعهای از سوی گروه تحقیقاتی Data Provenance Initiative به رهبری دانشگاه M.I.T. منتشر شده است، نشان میدهد که دسترسی به دادهها به شکل قابل توجهی کاهش یافته است.

به گزارش پیوست، شرکتهای هوش مصنوعی دیگر به بسیاری از منابع دسترسی ندارند و برای دسترسی به بخش مهمی از منابع با کیفیت قراردادهایی را منقعد کردهاند. اما مساله اینجاست که در ساز و کار جدید، شرکتهای بزرگ با منابع مالی عظیم میتوانند به دادهها دسترسی پیدا کنند و این شرکتهای کوچک هوش مصنوعی و پژوهشگران هستند که از این منابع محروم میشوند.

در این مطالعه که خبر آن را نیویورک تایمز منتشر کرده است، ۱۴ هزار دامنه وب موجود در دیتاست آموزشی مدلهای هوش مصنوعی بررسی شده است. نتایج این مطالعه نشان میدهد که بسیاری ناشران و پلتفرمهای آنلاین، دسترسی این ابزارها را به دادههای خود محدود کردهاند.

طبق برآورد محققان، ۵ درصد از تمام دادهها و ۲۵ درصد از دادههای با کیفیتترین منابع، محدودیت دسترسی دارند. این محدودیتها از طریق پروتکل مستثنی کردن روباتها (Robots Exclusion Protocol) اعمال شده است، روشی که مالکان سایتها سالها است از آن برای جلوگیری از دسترسی روباتها استفاده میکنند.

براساس این مطالعه، دسترسی به حدود ۴۵ درصد از دادههای یکی از دیتاستها به نام C4، در شرایط استفاده از وبسایت محدود شده است.

شین لانگپری، مولف ارشد این مطالعه، در مصاحبهای گفت: «ما شاهد کاهش سریع رضایت به استفاده از داده در سراسر وب هستیم که نه تنها برای شرکتهای هوش مصنوعی، بلکه برای محققان، اساتید و نهادهای غیرتجاری نیز پیامدهایی دارد.»

دادهها مواد اولیه اصلی برای سیستمهای هوش مصنوعی مولد هستند. این سیستمها با استفاده از میلیونها متن، عکس و ویدیو، محتوای مشابه را براساس پرامپت کاربر شبیهسازی میکنند. بیشتر این دادهها را پژوهشگران از وبسایتهای عمومی استخراج کرده و سپس در دیتاستهای عظیم گردآوری میکنند. شرکتها و محققان میتوانند از این دیتاستها به صورت رایگان استفاده کرده و یا با استفاده از آن دیگر دادههای خود را تکمیل کنند.

از آنجایی که کیفیت دادهها تاثیر بهسزایی بر کیفیت خروجی این مدلها دارد، عدم دسترسی به برخی از منابع و به ویژه منابع با کیفیت از اهمیت بالایی برخوردار است.

پیشرفت ابزارهای هوش مصنوعی مولد باعث تنشهایی بین مالکان داده و شرکتهای ارائه دهنده ابزارها شده است و بسیاری از منابع بهرهبرداری رایگان از دادههای خود را نادرست دانسته و خواستار پرداخت هزینه آن هستند.

وبسایتهای مهمی مثل ردیت و StackOverflow، در حال حاضر از شرکتها در ازای دسترسی به دادهها خود هزینه دریافت میکنند و چندین ناشر و روزنامه (از جمله نیویورک تایمز) نیز از ارائه دهندگان این ابزارها شکایت کردهاند.

مدیران شرکتهای هوش مصنوعی میگویند دسترسی به دادههای جدید در بیشتر موارد تنها با پرداخت هزینه و عبور از سد پرداخت امکانپذیر است و دادههای عمومی نیز بیش از اندازه در مدلها استفاده شدهاند و در واقع چیز جدیدی برای ارائه ندارند.

با این حال فعالان هوش مصنوعی از جمله اوپنایآی، گوگل و متا در سالها اخیر برای دسترسی به دادههای هرچه بیشتر و بهبود سیستمهای خود دست به اقدامات مختلفی زدهاند و حتی در مواردی مثل استفاده از متن ویدیوهای یوتیوب، برخی از شرکتها منابع داده دیگری را (یوتیوب پلتفرم تحت مالکیت گوگل است) هدف گرفتهاند. همچنین سیاستهای داده این پلتفرمها نیز تغییراتی را متحمل شده تا شرکتها بتوانند از دادههای کاربران برای آموزش مدلهای خود استفاده کنند.

ارائه دهندگان هوش مصنوعی همچنین قراردادهایی را با ناشران بزرگ از جمله فایننشال تایمز، AP و News Corp، مالک والاستریت ژورنال، برای استفاده از دادههای آنها منعقد کردهاند.

اما محدودیتهای گسترده ممکن است به تهدید جدی برای شرکتهای هوش مصنوعی تبدیل شود زیرا این شرکتها برای بهروز نگه داشتن ابزارهای خود به جریان دادههای با کیفیت نیاز دارند.

همچنین در نتیجه این محدودیتها، فعالان کوچک هوش مصنوعی و پژوهشگرانی که به دادههای عمومی وابسته هستند و توان خریداری مجوز را ندارند، با مشکل جدی مواجه میشوند. لانگپری میگوید دیتاست Common Crawl، که محتوای میلیاردها صفحه وب را در خود جای داده و تحت مالکیت یک شرکت خیریه است، در بیش از ۱۰ هزار مطالعه مطالعه دانشگاهی مورد اشاره قرار گرفته است.

از آنجایی که تعداد کمی از توسعهدهندگان هوش مصنوعی لیست منابع خود را ارائه میدهند، مشخص نیست که کدام محصولات هوش مصنوعی با استفاده از این منابع آموزش دیدهاند. اما دیتاستهای استخراج شده از Common Crawl، از جمله C4 (که اختصاری از Colossal, Cleaned Crawled Corpus است) در نسخههای پیشین هوش مصنوعی گوگل و اوپنایآی استفاده شدهاند.

محدودیتهای جدید و رویکرد مطالبهگرانه منابع داده را میتوان واکنشی طبیعی به انقلاب هوش مصنوعی دانست. این ابزارها در بسیاری از موارد نه تنها دادههای مختلف را بدون پرداخت هزینهای استفاده کردهاند، بلکه بقای این منابع را نیز تهدید میکنند. منابع خبری و ناشران یکی از مهمترین مواردی هستند که در نتیجه پیشرفته روز افزون چتباتها و ابزارهای هوش مصنوعی تهدید میشوند.

یکین جرنیت، محقق یادگیری ماشینی شرکت Hugging Face، که ابزار و داده در اختیار توسعه دهندگان هوش مصنوعی میگذارد، میگوید این بحران کسب اجازه را میتوان یک پاسخ طبیعی به رویکرد تهاجمی صنعت هوش مصنوعی به منابع داده دانست.

او میگوید: «پس از اینکه متن، تصاویر ویدیوهایی که تولیدکنندگان داده در فضای آنلاین به اشتراک گذاشته بودند برای ساخت سیستمهای تجاری، که گاه موجودیت آنها را مستقیما تهدید میکند، استفاده شد، عجیب نیست که شاهد واکنش منفی آنها هستیم.»

با این حال او هشدار میدهد که اگر دسترسی به داده تنها از طریق قرارداد امکانپذیر باشد «محققان و جامعه مدنی دیگر در حاکمیت این فناوری نقشی نخواهد داشت.»