قابلیت تماس گروهی در پیامرسان سروشپلاس ایجاد شد

امکان برقراری تماسهای صوتی و تصویری چندنفره در پیامرسان سروشپلاس با هدف ارتقای کیفیت خدمات…

۱۹ آبان ۱۴۰۴

۲۱ اردیبهشت ۱۴۰۳

زمان مطالعه : ۱۱ دقیقه

پس از عرضه جدید Stable Diffusion XL fine-tuning به بازار در Replicate و گذشت چند ماه از سالگرد یک سالگی Stable Diffusion، اکنون فرصتی عالی است که به عقب برگردیم و بررسی کنیم که چگونه هوش مصنوعی در تبدیل متن به تصویر نسبت به گذشته بهبود یافته است.

ما شاهد هستیم که تصاویر تولید شده توسط هوش مصنوعی از مشکلات بصری و نویزهای نامفهوم خلاص میشوند و به تصاویر هنری باکیفیت بالا نزدیک میشوند. به گونهای که گاه از قلم موی یک نقاش یا رندر دارای جزئیات یک تصویرگر قابل تشخیص نیستند.

در این مطلب، درمورد تکامل هوش مصنوعی در تولید متن به تصویر صحبت میکنیم تا درک کنیم که در چند سال گذشته، از تجربیات اولیه GAN تا آخرین مدلهای عرضه شده در بازار، چقدر پیشرفت کردهایم.

برای جشن گرفتن اولین سالگرد Stable Diffusion، ابزار text-to-image AI playground tool با جدیدترین مدل Stable Diffusion XL 1.0 بهروزرسانی شده است.

Zoo یک اپلیکیشن وب منبع باز برای مقایسه مدلهای تبدیل متن به تصویر است. Zoo به شما امکان میدهد مدلهای مختلف تولید تصویر را با یکدیگر مقایسه کنید. بنابراین، برای مثال، میتوانید نحوه بهبود Stable Diffusion و سایر مدلهای هوش مصنوعی متن به تصویر را در طول زمان، به طور همزمان مقایسه کنید. Zoo شامل Stable Diffusion 1.5، Stable Diffusion 2.1، Stable Diffusion XL 1.0، Kandinski 2.2، DALL·E 2، Deepfloyd IF و Material Diffusion است.

همانطور که میدانیم اجرای هوش مصنوعی مولد در تبدیل متن به تصویر در ژانویه ۲۰۲۱ و پس از عرضه مدل CLIP توسط OpenAI آغاز شد.

CLIP یک مدل منبع باز از OpenAI است که توسط تصاویر دارای زیرنویس جمعآوریشده از وب آموزش دیده است و میتواند تصاویر و متن را در هر فضای تعبیه شده طبقهبندی و پخش کند. این بدان معنی است که درک معنایی از آنچه در تصویر مورد نظر اتفاق میافتد را دارد. به عنوان مثال، اگر به CLIP عکسی از یک موز بدهید، این عکس ارتباط نزدیکی با متن «موز زرد» در فضای تعبیه شده خواهد داشت.

این نوع درک چند وجهی از تصاویر و متن، یک عنصر اساسی مهم در هوش مصنوعی متن به تصویر است، زیرا میتوانیم از آن کمک بگیریم تا نسلهای هوش مصنوعی متن به تصویر، تصویر نتیجه را مانند دستور متن داده شده ارائه دهند.

اولین تجربه منبع باز برای تبدیل متن به تصویر AI توسط advadnoun در ژانویه ۲۰۲۱ منتشر شد.

Deep Daze در واقع یک colab notebook است که advadnoun آن را به اشتراک گذاشته است. و برای تولید آن مدل CLIP OpenAI و مدل SIREN را به منظور ایجاد تصاویر تقریباً خوانا ترکیب کرده است. شما میتوانید در تصاویر زیر، ابتدایی بودن و شباهت به تصاویر فوری را مشاهده کنید، اما تصاویر همه بسیار انتزاعی هستند و با رئالیسم یا موضوعات واضح تناسب ندارند.

در ادامه تعدادی از اولین تصاویر تولید شده با DeepDaze را میبینیم. جالبترین تصویر درختان صنوبر در غروب آفتاب است که به نظر میرسد تقریباً میتواند یک نقاشی امپرسیونیستی انتزاعی باشد.

پس از عرضه قبلی و در حدود یک هفته بعد advadnoun یک colab notebook دیگر به نام The BigSleep را به اشتراک گذاشت. این نوت بوک جدید ترکیبی از مدل CLIP و مدل BigGAN را نشان میدهد.

BigSleep پیشرفت واضحی در ایجاد صحنههای خوانا نشان داد. اما هنوز درک تصاویر دشوار بود. چون تصاویر تولیدی پر از مصنوعات و خطاهای عجیب بود.

تصویر جالب در میان این تصاویر صحنهای با رنگهای زنده است. ابرها واقع گرایانه هستند و رنگهای پر جنب و جوش شبیه شاخ و برگهای پاییزی به نظر میرسند.

در آوریل ۲۰۲۱، RiversHaveWings مجموعهای از colab notebookها را به اشتراک گذاشت که ترکیبی از VQGAN و CLIP بودند.

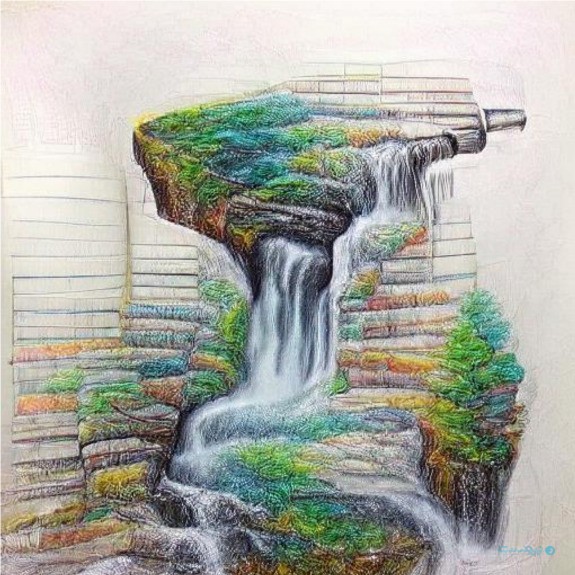

VQGAN+CLIP از نظر بازآفرینی ظاهر و احساس هنری یک گام بزرگ به جلو بود. متوجه خواهید شد که تصاویر زیر در حال شبیه شدن به درخواستها هستند و بافتهای هنری مانند ضربههای قلم مو و نشانههای مداد ظاهر میشوند.

در ادامه تعدادی از تصاویر جالب VQGAN+CLIP وجود دارد:

Pixray یک مدل تولید تصویر مهم در تاریخ Replicate بود. این مدل که ابتدا در ژوئن 2021 منتشر شد، اولین مدل تبدیل متن به تصویر در Replicate بود که تا اوایل سال 2022 به دهها هزار اجرا رسید. و تا به امروز در مجموع 1.3 میلیون بار اجرا شده است.

در آوریل 2022، کل زمینه تبدیل متن به تصویر شروع به انتشار مدلهای diffusion کرد.

در این زمان OpenAI هم DALL·E 2 را معرفی کرد و مقاله جدیدی را منتشر کرد که جزئیات بهبودهای آنها را توضیح میداد و نشان میداد که چگونه استفاده از مدلهایdiffusion کیفیت و ثبات کلی تصویر را بهبود میبخشد. DALL·E 2 به عنوان یک محصول منبع بسته منتشر شد که در ابتدا فقط برای مجموعه کوچکی از کاربران بتا در دسترس بود.

مدل محبوب بعدی تبدیل متن به تصویر هوش مصنوعی DALL·E Mini است. این مدل در جولای 2021، به عنوان یک مدل متن به تصویر متن باز توسط Boris Dayma و همکاران منتشر شد.

بوریس یک بررسی عمیق در مورد چگونگی ترکیب مدلهای مختلف از جمله VQGAN، CLIP و Bert برای ایجاد تصاویر خوانا از پیامهای متنی را منتشر کرده است.

در 22 آگوست 2022، Stable Diffusion 1.4 اولین ارائه خود را انجام داد. وزن مدل و تمام کدها به صورت متن باز منتشر شد. بسیاری از نمونهها در هکرنیوز اسکرول شدهاند و نتایجی که مردم در نظرات به اشتراک گذاشتهاند، تأثیر برانگیز است. مزیت مهم آن این است که وزن مدل فقط به میزان 4 گیگابایت روی دیسک است. به علاوه فقط حدود 50 ثانیه طول میکشد تا یک تصویر ایجاد شود.

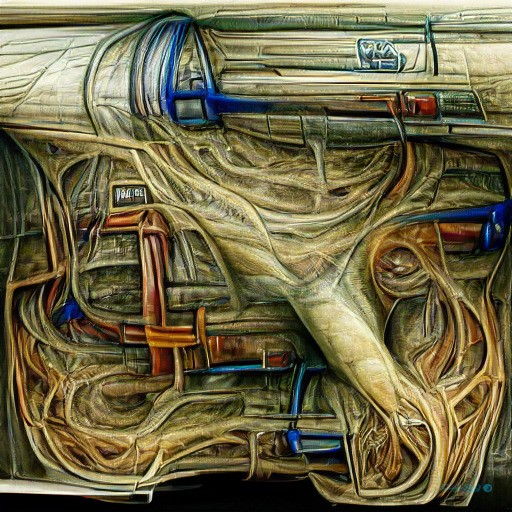

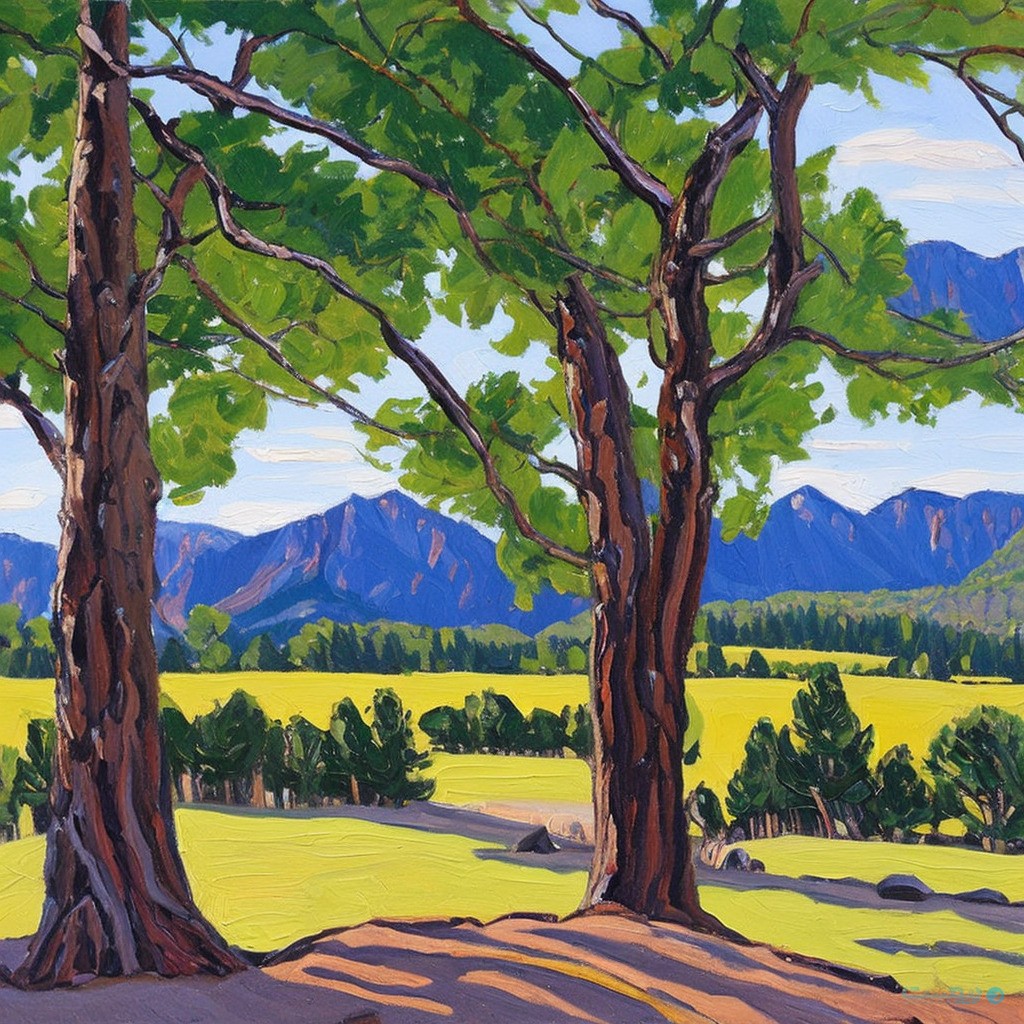

در ادامه برخی از تصاویر تولیدی Stable Diffusion 1.4 و 1.5 را میبینیم. با نگاهی به این موارد، میتوانید جهش کیفیت VQGAN و DALL·E Mini را ببینید.

Stable Diffusion 2 هم برای اولین بار در اکتبر 2022 منتشر شد.

نسخه 2 آن چندین تغییر و بهبود داشت، مانند قابلیت حذف بخشهای مورد نظر، OpenCLIP برای رمزگذار متن، خروجیهای بزرگتر تصویر و موارد دیگر.

انتقال به OpenClip در مقایسه با نسخههای قبلی Stable Diffusion، تغییرات قابل توجهی در خروجی و ترکیب تصویر ایجاد کرد. مهمتر از همه، این که نام بسیاری از هنرمندان از رمزگذار متن حذف شد، که تا به امروز بسیاری از کاربران را به استفاده از 1.5 به جای 2.1 سوق داده است.

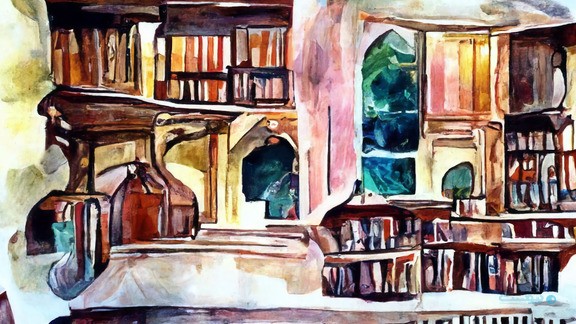

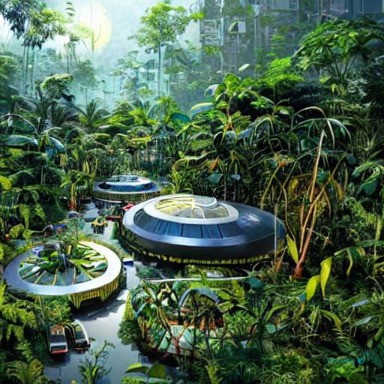

در ادامه چند تصویر تولیدی Stable Diffusion 2.1 را میبینید.

این ما را به جدیدترین و بهترین مدل هوش مصنوعی متن به تصویر، Stable Diffusion XL میرساند که در ۲۶ ژوئیه ۲۰۲۳ منتشر شد.

SDXL تصاویری با کیفیت بالاتر، با مصنوعات کمتر و نتایج سازگارتر ارائه میدهد. SDXL از نقاشی درون نقاشی، تبدیل تصویر به تصویر، اصلاح، Fine-tuning و غیره پشتیبانی میکند.

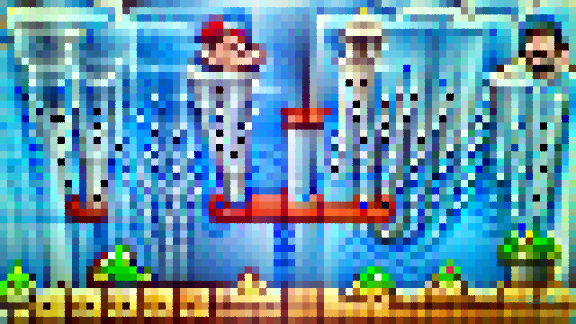

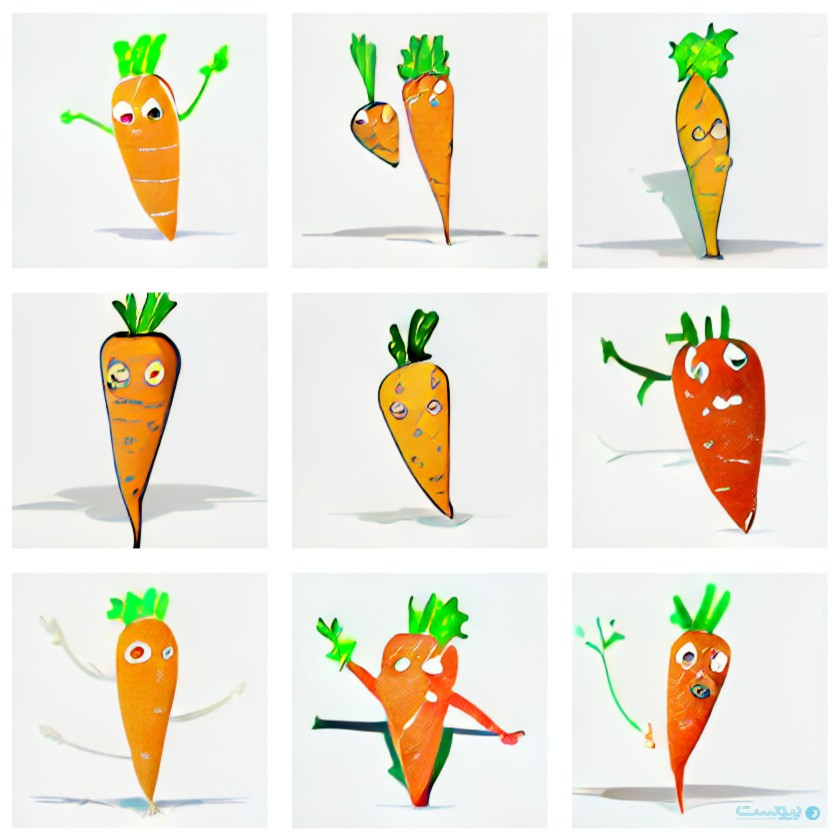

در ادامه چند نمونه از تصاویر تولیدی SDXL را میبینیم.

این تصاویر شگفتانگیز هستند، اما هنوز به نظر میرسد که تازه شروع کردهایم. با سرعت فعلی توسعه، جامعه منبع باز موظف است مدلها، ابزارها و گردش کار بهتری را در ماهها و سالهای آینده ارائه دهد. الان یک زمان هیجانانگیز برای شروع در این فضا است. زیرا ما مجموعهای اساسی از ابزارها و مبنایی محکم برای ساختن آینده داریم.

Fine-tuning فرآیند گرفتن یک مدل پایه از پیش آموزش دیده، مانند Stable Diffusion، و آموزش بیشتر آن بر روی یک مجموعه داده خاص است. در مورد یک مدل هوش مصنوعی متن به تصویر، این بدان معنی است که می توانید Stable Diffusion را برای ایجاد تصاویری از سگ خود، شخصیت انیمیشن مورد علاقه خود یا سبک هنرمند مورد علاقه خود آموزش دهید. برخی از روشهای رایج تنظیم دقیق امروزی DreamBooth، LoRA و Textual Inversion هستند.

اینجاست که برتری مدلهای منبع باز بر مدلهای خصوصی مانند Midjourney یا DALL·E 2 مشخص میشود. چون امکان ارائه آموزش و تولید موضوعات/ اشیاء از زندگی روزمره خود را برای شما فراهم میکند. Replicate به تازگی Fine-tuning برای SDXL را هم منتشر کرده است.

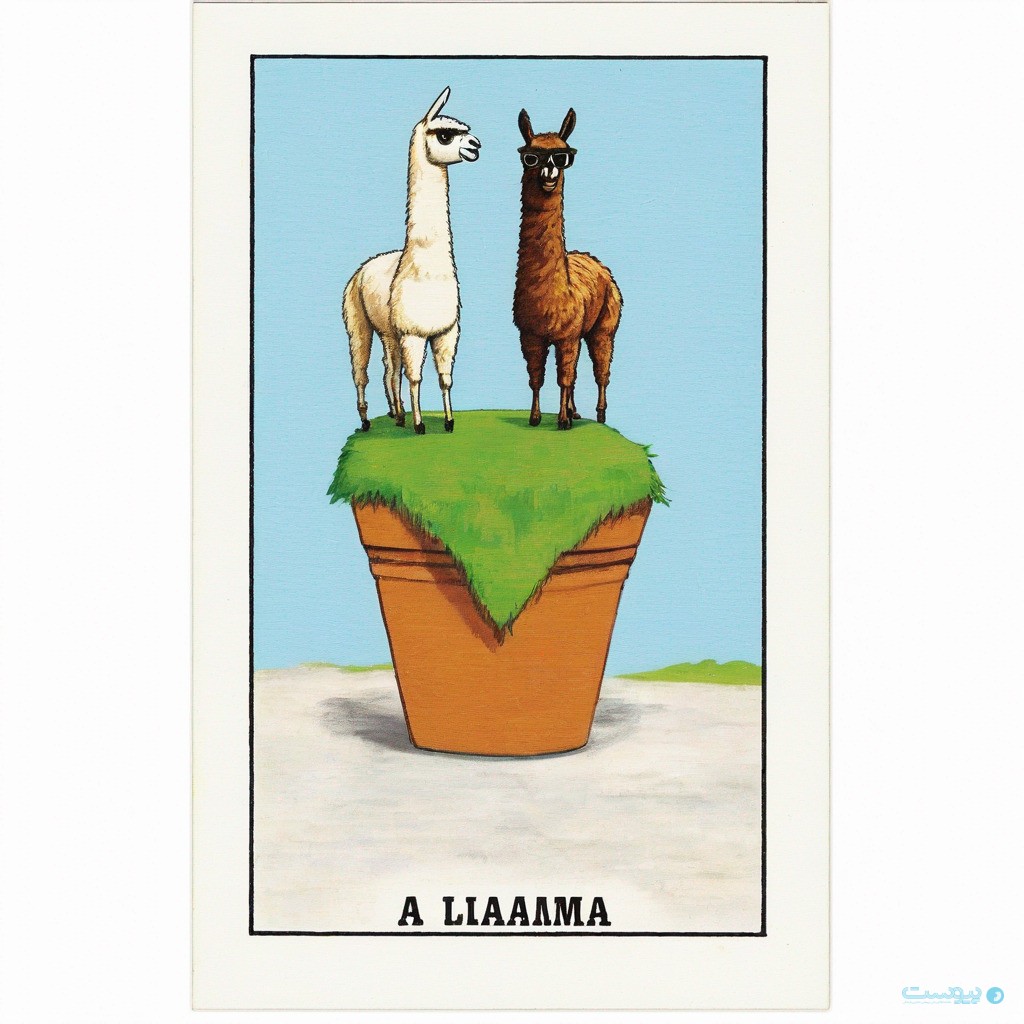

در ادامه تعدادی از مثالهای جالب را ارائه میدهیم:

با انتشار SDXL، و توسعه مداوم مدلهای Fine-tuning و کنترل ترکیبی منبع باز (ControlNet)، ما به خلاقیت و نوآوری نزدیک میشویم، بنابراین خواهید توانست هر چیزی را که میتوانید تصور کنید، تولید کنید. البته با وجودی که هوش مصنوعی تبدیل متن به تصویر راه درازی را طی کرده است، اما هنوز با کامل بودن فاصله زیادی دارد.

منبع: Replicate