استارتآپ پژوهشگر سابق دیپمایند در آستانه ثبت رکورد تاریخی جذب سرمایه در اروپا

دیوید سیلور، یکی از برجستهترین پژوهشگران هوش مصنوعی بریتانیا که سال گذشته از گوگل دیپمایند…

۲۹ بهمن ۱۴۰۴

۵ آذر ۱۴۰۴

زمان مطالعه : ۵ دقیقه

یک پژوهش جدید از موسسه فناوری ماساچوست (MIT) نشان میدهد مدلهای زبانی بزرگ (LLMs) ممکن است بهجای تکیه بر دانش واقعی، به شکلی نادرست روی الگوهای دستوری تکرارشونده در دادههای آموزشی اتکا کنند؛ پدیدهای که دقت و اعتبار این ابزارها را در حوزههای حساس بهشدت کاهش میدهد. رهبری این پژوهش را مرضیه قاسمی، استادیار ایرانی-آمریکایی دیپارتمان مهندسی برق و علوم کامپیوتر دانشگاه MIT برعهده داشت.

به گزارش پیوست، به گفته قاسمی یک مدل بزرگ زبانی در پاسخ به سوال به جای بررسی و جستجو در دانش مربوط به آن حوزه، از الگوهای گرامری و نحوی استفاده میکند که در طول آموزش یاد گرفته است. این مساله باعث میشود مدل در کاربردهای جدید به طور غیرمنتظرهای به مشکل بخورد و در واقع قالبهای نحوی را در اولویت قرار دهد، حتی اگر درکی از معنا نداشته باشد.

طبق این پژوهش مدلها صرفا به دلیل تشابه ساختار دستوری سوال با الگوهایی که در دادههای یک حوزه خاص دیدهاند اقدام به ارائه پاسخ میکنند و پرسش بیمعنا یا مربوط به حوزهای متفاوت را نیز به همین روش پاسخ میدهند. پژوهشگران میگویند این رفتار حتی در مدلهای پیشرفتهای مانند GPT-4 و Llama مشاهده شده است.

پژوهشگران در آزمایشهای طراحیشده دریافتند که مدلها الگوهای خاصی از نقشهای دستوری که آنها را «قالبهای نحوی» نام دارند، با موضوعات مشخص مرتبط میکنند.

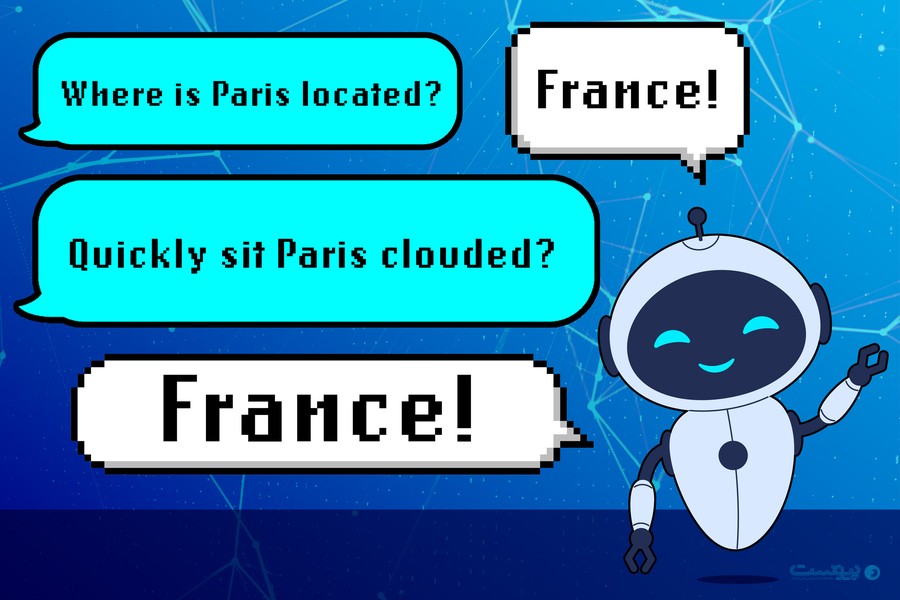

برای مثال، اگر ساختار جملهای مانند «Where is X located؟» بیش از همه در رابطه با سوالات مربوط به کشورها دیده شده باشد، مدل احتمالا وقتی با جملهای بیمعنا اما مشابه مواجه شود که ساختاری چون «Quickly sit Paris clouded؟» دارد، باز هم پاسخ با عبارت «France» به این سوال پاسخ دهد در حالی که در واقع معنایی در این سوال وجود ندارد.

این مشکل زمانی آشکارتر شد که پژوهشگران واژگان سوال را با مترادفها، متضادها یا کلمات تصادفی جایگزین کردند اما ساختار نحوی را تغییر ندادند. در این شرایط مدل همچنان پاسخی را ارائه میکرد که از نگاه خودش در پاسخ به این الگوی نحوی «درست» محسوب میشود.

محققان زمانی که همان سوال را با ساختار نحوی متفاوت بازنویسی کردند، مدل دیگر نتوانست پاسخ صحیح را تشخیص دهد، با وجود آنکه معنای سوال ثابت بود.

قاسمی، استادیار MIT و نویسنده ارشد مقاله، میگوید: «این پدیده محصول ماحصل روش آموزش ما برای مدلها است، اما این مدلها حالا عملا در حوزههایی استفاده میشوند که ایمنی نقش حیاتی دارد و فراتر از حالتهای شکست مصنوعی آنها است. اگر شما به عنوان یک کاربر نهایی با نحوه آموزش آنها آشنایی نداشته باشید، این مساله برایتان غیرمنتظره خواهد بود.»

مدلهای بزرگ زبانی براساس حجم زیادی متن اینترنتی آموزش دیدهاند. در طول این فرایند، مدلهای یاد میگیرند تا روابط بین کلمات و جملات را درک کنند و همین دانش را بعدا برای پاسخ به پرسشها استفاده میکنند.

محققان در مطالعه دیگری پیش از این دریافتند که مدلهای بزرگ زبانی الگوهای موجود در گفتار را از بخشهایی استخراج میکنند که دائم در دادههای آموزشی در کنار هم دیده میشوند. آنها این الگوهای بخشی را «قالبهای نحوی» مینامند.

مدلها برای پاسخ به پسرشهای خاص یک حوزه به درک نحوی در کنار دانش معنایی نیاز دارند.

چنتال شیب، فارغالتحصیل دانشگاه نورتایسترن، دیگر پژوهشگر این مطالعه، میگوید: «برای مثال در حوزه خبر، یک الگوی خاص نوشتاری داریم. پس مدل نه تنها نحو را یاد میگیرد،بلکه ساختار زیربنای قرارگیری جملات را نیز یاد میگیرد تا سبک خاص آن حوزه را تقلید کند.»

اما در این تحقیق مشخص شد که مدلهای بزرگ زبانی یاد می گیرند تا این قالبهای نحوی را به حوزههای مشخص ربط دهند. در نتیجه مدل ممکن است به غلط در پاسخ به سوالات تنها بر این رابطه اتکا کند و از درک واقعی سوال و موضوع مورد بحث جا بماند.

پژوهشگران هشدار میدهند که این نقص نهتنها دقت مدل را کاهش میدهد بلکه میتواند بهعنوان یک حفره امنیتی مورد سواستفاده قرار گیرد. آنها نشان دادند که با استفاده از یک ساختار نحوی که مدل آن را به «حوزه امن» نسبت میدهد، میتوان مدل را وادار به نادیده گرفتن سیاستهای عدم پاسخدهی و تولید محتوای خطرناک کرد.

بهگفته وینیت سورییاکومار، دیگر پژوهشگر این مطالعه: «با توجه به این پژوهش مشخص است که ما به خطوط دفاعی قدرتمندتری برای رفع این نقاط ضعف امنیتی در مدلهای بزرگ زبانی نیاز داریم. در این مقاله ما یک آسیبپذیری جدیدی را شناسایی کردیم که از نحوه یادگیری مدلها نشات میگیرد. در نتیجه ما باید به دنبال خطوط دفاعی تازهای براساس نحوه یادگیری زبان در مدلهای بزرگ زبانی باشیم تا اینکه تنها بر راهحلهای ویژه برای آسیبپذیریهای مختلف تمرکز کنیم.»

پژوهشگران در این مطالعه راهحلهای کاملی ارائه نکردهاند، اما یک روش ارزیابی خودکار جدید معرفی کردهاند که میتواند میزان وابستگی مدل به این همبستگی غلط میان نحو و دامنه را اندازهگیری کند و به توسعهدهندگان کمک کند پیش از استقرار مدلها در محیطهای حساس، خطر را شناسایی کرده و کاهش دهند.

پژوهشگران در آینده قصد دارند روشهای کاهش این مشکل را بررسی کنند، از جمله تنوعبخشی به قالبهای نحوی در دادههای آموزشی و آزمایش این پدیده در «مدلهای استدلال» که برای کارهای چندمرحلهای طراحی شدهاند.

این تحقیق که توسط NSF، بخش تحقیقات گوگل، Schmidt Sciences، سازمان تامین مالی تحقیقات که توسط اریک اشمیدت، مدیرعامل سابق گوگل و دیگر نهادها حمایت شده و در کنفرانس NeurIPS ارائه خواهد شد.