قرارداد چند ساله اوپنایآی با چهار غول مشاوره جهان برای افزایش نفوذ سازمانی

شرکت اوپنایآی روز دوشنبه از آغاز همکاریهای چندساله با چهار شرکت بزرگ مشاوره مدیریتی و…

۴ اسفند ۱۴۰۴

۲۴ شهریور ۱۴۰۳

زمان مطالعه : ۸ دقیقه

پس از اینکه اوپنایآی روز پنجشنبه مدلهای جدید o1 را منتشر کرد، کاربران ChatGPT در این فرصت دو روزه کمی با ابزارهای جدیدی که پیش از پاسخ دادن «فکر میکنند»، آشنا شدهاند. این همان پروژهای است که در داخل اوپنایآی با اسم رمز «Strawberry» شناخته میشد و از آن به عنوان گام بعدی هوش مصنوعی یاد میشود اما تا با اینجای کار بازخوردها متناقض است و شاید یکی از دلایل آن را بتوان انتظارات بیش از حد کاربران به دلیل بیشمار شایعه پیش از انتشار این محصول دانست.

به گزارش پیوست به نقل از تککرانچ، مدلهای o1 در مقایسه با GPT-4o یک گام رو به جلو و دو گام به عقب محسوب میشوند. مدلهای o1 در استدلال و پاسخ به سوالات پیچیده عملکرد بهتری دارند، اما تقریبا چهاربرابر گرانتر از GPT-4o هستند. همچنین این مدلها از یک سری ابزارها مثل توانمندیهای چندوجهی برخوردار نیستند و سرعت آنها نیز با مدلهای پیشین قابل مقایسه نیست. حتی اوپنایآی هم در صفحه کمکهای خود اعتراف میکند که «GPT-4o همچنان بهترین گزینه برای بیشتر پرامپتها است» و تصریح میکند که o1 در وظایف ساده به مشکل میخورد.

راوید شوارتز زیو، استاد دانشگاه NYU که مدلهای هوش مصنوعی را مطالعه میکند، میگوید: «تحسینبرانگیز است اما فکر میکنم پیشرفت چندان بزرگی نیست. برای یک سری مسائل بهتر است اما بهبود همه جانبه ندارد.»

درنتیجه به همین دلایل بهتر است که از o1 تنها برای سوالات خاص خود استفاده شود: سوالات بزرگ. البته که بیشتر مردم در حال حاضر از هوش مصنوعی برای چنین سوالاتی استفاده نمیکنند زیرا مدلهای هوش مصنوعی عملکرد چندان خوبی در این حوزه ندارند. اما o1 را میتوان گام مثبتی در این مسیر دانست.

مدل o1 به دلیل «فکر کردن» پیش از پاسخ به سوال، تجزیه مسائل به گامهای کوچک و تلاش برای شناسایی گامهای درست و غلط، منحصربهفرد محسوب میشود. این «استدلال چند مرحلهای» چیز چندان تازهای نیست (محققان سالها است چنین رویکردی را پیشنهاد دادهاند و You.com از آن برای پرسشهای پیچیده استفاده میکند)، اما تا همین چندی پیش اجرای آن عملی نبود.

کیان کتان فروش، مدیرعامل Workera و سخنران استنفورد، که کلاسهایی را در مورد یادگیری ماشینی آموزش میدهد، میگوید: «در جامعه هوش مصنوعی هیجان زیادی وجود دارد. اگر شما بتوانید یک الگوریتم یادگیری تقویت را به همراه برخی از ترفندهای مدل زبانی اوپنایآی آموزش دهید،در واقع میتوانید یک تفکر گام به گام خلق کنید و به مدل هوش مصنوعی اجازه دهید تا ایدههای بزرگی که میخواهید بررسی کنید را از انتها به ابتدا برود.»

مدلهای o1 اما هزینه بالایی دارند. در بیشتر مدلها، شما هزینه توکنهای ورودی و توکنهای خروجی را پرداخت میکنید. اما o1 یک هزینه پنهان را نیز اضافه میکند (همان گامهای کوچکی که مدل مسائل را به آن تجزیه میکند)، درنتیجه به رایانش عظیمی نیاز است که حتی چیزی از آن نمیبینید. اوپنایآی برای حفظ قدرت رقابتی خود این فرایند را پنهان کرده است. با این حال شما هزینه این «توکنهای استدلال» را پرداخت میکنید. همین مساله نشان میدهد که چرا باید درمورد o1 احتیاط کرد تا هزینه بیش از حدی برای توکنها پرداخت نکنید.

هدف این است که مدل هوش مصنوعی بتواند شما را از ایدههای بزرگ شما را گرفته و شما را تا ابتدای آن پش ببرد. هدف بسیار مهمی است و این مدل عملکرد خوبی دارد.

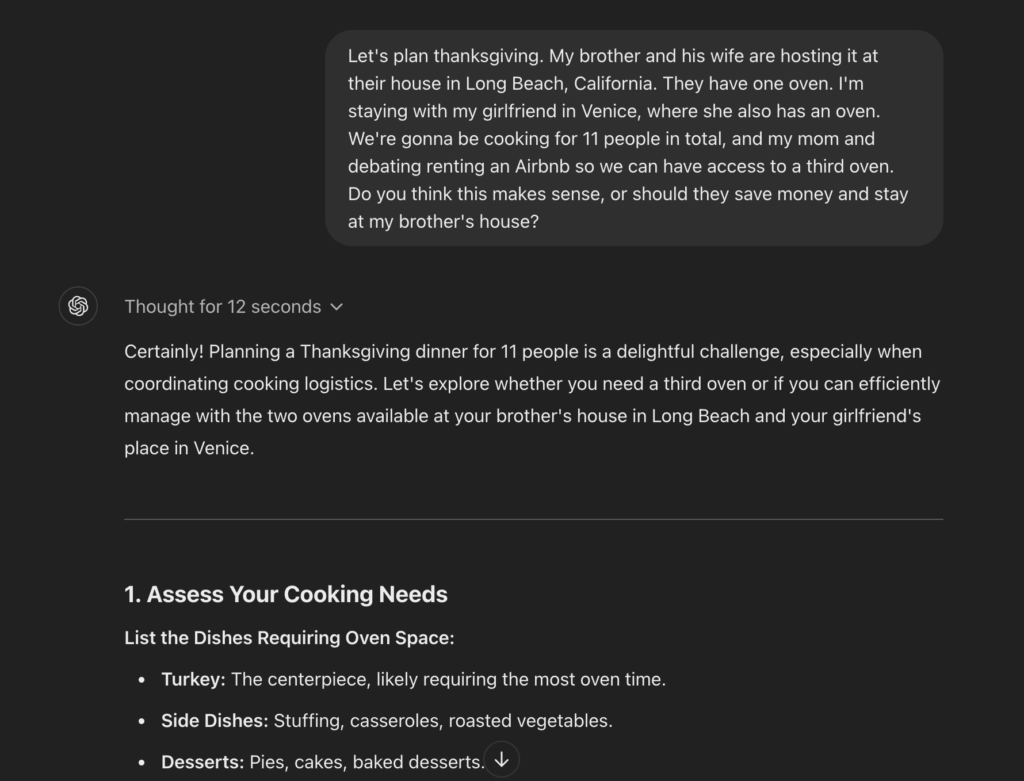

من در یکی از نمونهها از ChatGPT o1 خواستم تا درمورد برنامه روز شکرگذاری خانواده به من کمک کند، کاری که میتوان با استدلال و منطق بیطرف به آن کمک کرد. من به ویژه از این مدل خواستم تا ببیند آیا دو اجاق برای پختن غذای ۱۱ نفر در روز شکرگذاری کافی است و اینکه آیا نیاز است برای اجاق اضافی جایی را اجاره کنیم.

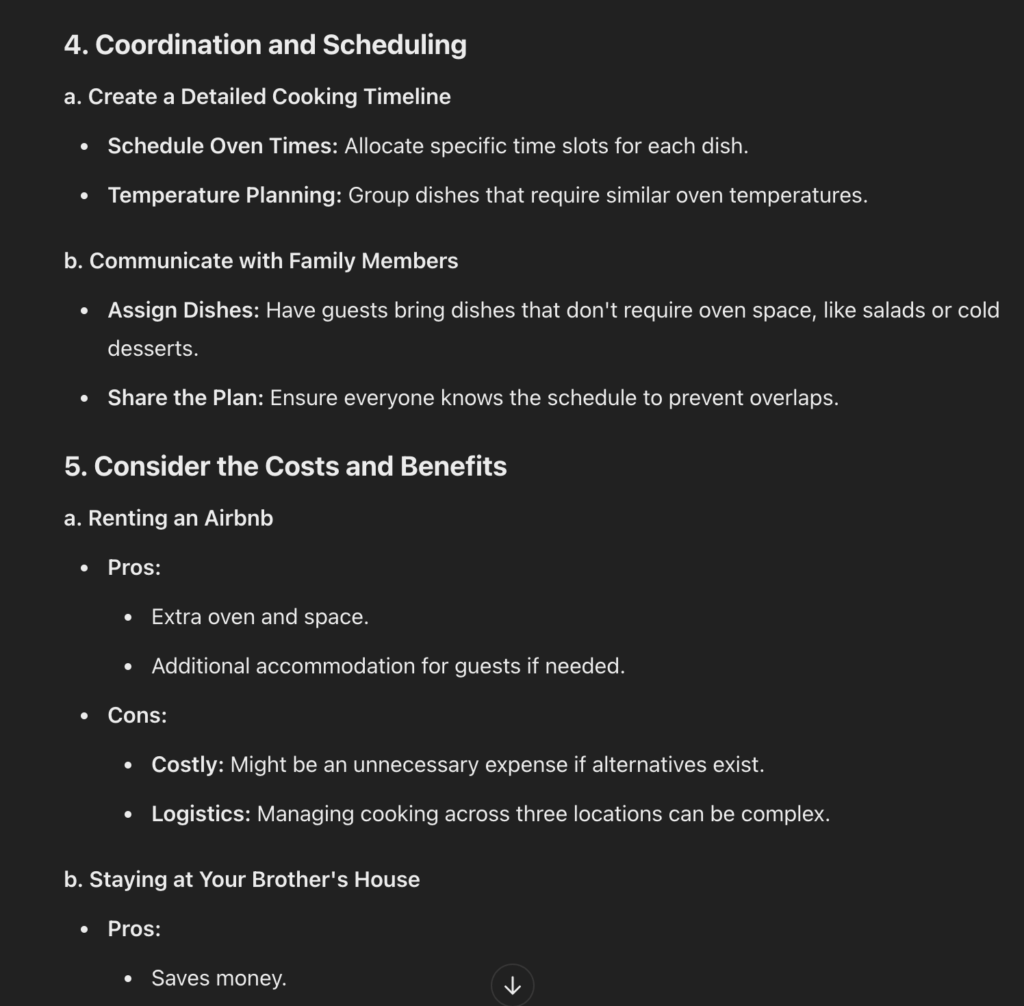

پس از ۱۲ ثانیه «تفکر»، چتجیپیتی یک پاسخ بیشتر از ۷۵۰ کلمهای برای من نوشت و در نهایت گفت که دو اجاق با استراتژی درست کافی است میتواند هزینههای خانواده را کاهش دهد و زمان بیشتری هم با هم بگذارید. اما این مدل نحوه تفکر خود را در هرگام تجزیه کرد و توضیح داد که چطور تمام فاکتورهای خارجی، از جمله هزینهها، زمان خانواده و مدیریت اجاق را بررسی کرده است.

نمونه اولیه o1 به من گفت که چطور فضای اجاق را در خانه اولویت بندی کنم و این اقدام هوشمندانهای بود. همچنین در یک پیشنهاد عجیب گفت که اجاره یک اجاق قابل حمل را نیز در گزینهها داشته باشم. اما روی هم رفته این مدل عملکرد بهتری نسبت به GPT-4o داشت که به سوالات بیشتری نیاز دارد و باید بداند دقیقا چه ظرفهایی میآورید و توصیه نهایی آن هم چندان کاربردی نبود.

شاید سوال درمورد غذای روز شکرگذاری احمقانه به نظر برسد اما باید دید که چطور این ابزار میتواند وظایف پیچیده را تجزیه کند.

من همچنین از o1 خواستم تا یک روز شلوغ کاری را که در آن باید به فرودگاه، چند جلسه حضوری در مکانهای مختلف و اداره جابجا میشدم، برنامهریزی کند. هوش مصنوعی یک برنامه دقیق در اختیار من گذاشت اما دقت آن کمی بیش از حد بود. در برخی از بخشهای این برنامه گامها اضافی مشاهده میشد.

این هوش مصنوعی برای سوالات ساده زیاد است و از بیش اندیشی دست بر نمیدارد. از مدل پرسیدم که در کجای آمریکا می توان درختهای سرو پیدا کرد و یک پاسخ بیش از ۸۰۰ کلمه در اختیار من گذاشت که تمام گونههای مختلف درخت سرو در هر منطقه را به همراه نام علمی توضیح میداد. حتی نیاز بود که به دلایلی نامعلوم به بررسی سیاستهای اوپنایآی بپردازد. در این گزینه GPT-4o عملکرد بسیار بهتری داشت و در یک پاسخ سه جملهای توضیح داد که کجا میتوان درختهای سرو را در آمریکا پیدا کرد.

میتوان گفت انتظارات به حدی از پروژه Stawberry بالا بود که توان برآورده کردن آنها وجود نداشت. گزارشهای مربوط به مدل استدلالگر اوپنایآی به نوامبر ۲۰۲۳ باز میگردد، یعنی درست زمانی که همه به دنبال پاسخ برای دلیل اخراج ناگهانی سم آلتمن بودند. شایعات جهان هوش مصنوعی را فرا گرفت و بسیاری گمان میبردند Strawberry نوعی هوش مصنوعی عمومی یا AGI است که اوپنایآی به عنوان هدف نهایی خود مشخص کرده است.

آلتمن تایید کرد که o1 بدون شک AGI نیست و نباید با آن اشتباه گرفته شود. مدیرعامل اوپنایآی در زمان عرضه برای کاهش انتظارات تلاش کرد و گفت «o1 هنوز نقص دارد، محدود است و در اولین استفاده تحسینبرانگیزتر از آن چیزی به نظر میرسد که مدتی بعد تصور میکنید.»

روهان پاندی، پژوهشگر استارتآپ هوش مصنوعی ReWorkd، که نسخههای وبی براساس مدلهای اوپنایآی میسازد، میگوید: «جو موجود از کنترل اوپنایآی خارج شد.»

او امیدوار است که قدرت استدلال o1 به اندازهای خوب باشد که بتواند برخی از کاستیهای GPT-4 در مسائل پیچیده را برطرف کند. از نگاه بیشتر فعالان صنعتی o1 چنین نقشی دارد و یک گام انقلابی پس از GPT-4 نیست.

مایک کانوور، مدیرعامل شرکت هوش مصنوعی Brightwave، در مصاحبهای گفت: «همه منتظر یک جهش در توانمندیها هستند و روشن نیست که این [مدل] بتواند انتظارات را برآورده کند. به نظرم قضیه به همین سادگی است.»

اصول پایهای که به ساخت o1 منتهی شدند سابقه چند سال دارند. اندی هریسون،کارمند سابق گوگل و مدیرعامل شرکت سرمایهگذاری جسورانه S32، میگوید گوگل در سال ۲۰۱۶ از ترفند مشابهی برای ساخت AlphaGo استفاده کرد، مدل هوش مصنوعی که برای اولین بار توانست قهرمان جهان بازی گو را شکست دهد. آلفاگو با بیشمار بازی در مقابل خودش آموزش دید و در واقع با آموزش به خودش توانست به توانایی فراانسانی برسد.

به گفته او همین مساله دوباره یک بحث دیرینه در جهان هوش مصنوعی را زنده میکند.

هریسون در مصاحبهای گفت: «یک طرف فکر میکند که میتوان روندهای کاری را با استفاده از این فرایند عاملیت خودکارسازی کرد. طرف دیگری فکر میکند که اگر هوش مصنوعی عمومی و استدلال داشته باشید، دیگر مثل انسان نیازی به روند کاری نیست، هوش مصنوعی قضاوتش را میکند.»

به گفته هریسون، طرف اول و دوم باید برای تصمیمگیری درست به هوش مصنوعی اعتماد کند. به گفته او ما هنوز به این مرحله نرسیدهایم.

با این حال برخی دیگر بر این باورند که o1 بیشتر از اینکه یک تصمیمگیرنده باشد، یک ابزار برای به چالش کشیدن نحوه تفکر در مورد تصمیمات بزرگ است.

کتانفروش به نمونهای اشاره میکند که او باید با یک پژوهشگر داده را برای کار در شرکتش مصاحبه کند. او به مدل o1 میگوید که تنها ۳۰ دقیقه زمان دارد و میخواهد یک سری مهارتها را ارزیابی کند. هوش مصنوعی میتواند رو به عقب فکر کند تا او متوجه شود آیا تصور درستی از مساله دارد و o1 در این مورد محدودیت زمانی و چیزهایی اضافی را متوجه میشود.

سوال اینجاست که آیا این ابزار به اندازه کافی با توجه به قیمتش ارزش دارد. در حالی که هوش مصنوعی با گذشت زمان ارزانتر میشود، o1 یکی از اولین نمونههایی است که قرار است هزینه این ابزارها را افزایش دهد.