علم پشت پرده ویرال شدن محتوا چیست

ویرال شدن یک محتوا فقط شانس یا اتفاق نیست و قطعاً تصادفی رخ نمیدهد. دلیلی…

۱۵ فروردین ۱۴۰۴

۶ بهمن ۱۴۰۲

زمان مطالعه : ۶ دقیقه

هنرمندان با ابزاری جدید میتوانند قبل از بارگذاری بهصورت آنلاین، تغییرات نادیدنی در پیکسلهای اثر هنری خود اعمال میکنند. بنابراین، اگر اثر هنری به مجموعه دادههای آموزشی هوش مصنوعی وارد شود، میتواند مدل نهایی را به روشهای پیشبینیناپذیر و آشفتهای خراب کند.

ابزار نایت شید (Nightshade)، با هدف مبارزه در برابر شرکتهای هوش مصنوعی طراحی شده که بدون اجازه از آثار هنری دیگران برای آموزش مدلهای خود استفاده میکنند. استفاده از نایتشید برای مسمومکردن دادههای آموزشی باعث آسیبرسیدن به نسخههای آینده مدلهای هوش مصنوعی تولید تصویر میشود. مدلهای دالای، میدجرنی و استیبل دیفیوژن دیگر خروجیهای بهدردبخوری تولید نمیکنند؛ برای مثال، سگها تبدیل به گربه میشوند، ماشینها تبدیل به گاو میشوند و همینطور تا آخر.

شرکتهای هوش مصنوعی از جمله OpenAI، متا، گوگل و Stability AI با انبوهی از شکایات حقوقی از سوی هنرمندان روبرو هستند. آنها ادعا میکنند آثار دارای کپیرایت و اطلاعات شخصیشان بدون کسب رضایت یا جبران خسارت برای آموزش هوش مصنوعی مولد استفاده شدهاست. بن ژائو، پروفسوری در دانشگاه شیکاگو است که تیم سازنده نایتشید را رهبری میکند. او میگوید که امید دارد تا به برگرداندن تعادل قدرت از شرکتهای هوش مصنوعی به هنرمندان کمک کند. آنها این کار را از طریق ایجاد بازدارنده قدرتمندی در برابر بیاحترامی به حق کپیرایت و مالکیت معنوی هنرمندان انجام میدهند. متا، گوگل، Stability AI و Open AI به درخواست MIT Technology Review برای انتشار نظرشان درباره این ابزار پاسخ ندادند.

تیم ژائو، Glaze را نیز توسعه داده که هنرمندان را قادر میسازد تا سبک شخصی خود را پنهان کرده و از استخراجشدن آن توسط شرکتهای هوش مصنوعی جلوگیری میکند. شیوه کار گلیز مشابه با نایتشید است. این ابزار، پیکسلهای تصاویر را به روشهای نامحسوسی تغییر میدهد که برای چشم انسان نادیدنی است، اما مدلهای یادگیری ماشین طوری فریب میخورند که تصاویر را به چیزی غیر از محتوای واقعیاش تفسیر میکنند.

هدف تیم، ادغامکردن نایتشید با گلیز است، تا خود کاربران تصمیم بگیرند آیا میخواهند از ابزار مسمومسازی دادهها استفاده کنند یا خیر. تیم سازنده ابزار، نایتشید را بهصورت متنباز منتشر کرده تا دیگران هم بتوانند آن را دستکاری کنند و نسخههای خودشان را بسازند. ژائو میگوید هرچه افراد بیشتری استفاده کنند و نسخههای مخصوص به خودشان را بسازند، ابزار نایتشید قدرتمندتر میشود. مجموعه دادههای مدلهای هوش مصنوعی بزرگ دارای میلیاردها تصویر هستند؛ بنابراین هرچه تصاویر سمی بیشتری به مدل وارد شود، این تکنیک آسیب بیشتری میرساند.

نایتشید از آسیبپذیری امنیتی مدلهای هوش مصنوعی مولد بهرهبرداری میکند. نوعی آسیبپذیری که از آموزشدیدن مدلها با حجم عظیمی از دادههای اینترنتی نشأت میگیرد. نایتشید، آن حجم از دادهها (تصاویر) را بههم میریزد.

هنرمندانی که میخواهند اثر خود را در فضای آنلاین بارگذاری کنند، اما نمیخواهند شرکتهای هوش مصنوعی از آن بهرهای ببرند، میتوانند اثر هنری را در گلیز آپلود کرده و گزینه پنهانکردن با سبک هنری متفاوت از خودشان را بزنند. آنها از نایتشید نیز میتوانند استفاده کنند. زمانی که توسعهدهندگان هوش مصنوعی، اینترنت را برای استخراج دادههای بیشتر شخم بزنند تا مدل کنونی هوش مصنوعی را بهبود داده یا مدل جدیدی را بسازند، نمونه تصاویر سمی به مجموعه دادهها راه مییابند و اثر مخربی از خود برجای میگذارند.

نمونه دادههای سمی میتوانند آموزشدیدن مدلهای هوش مصنوعی را مختل کنند؛ برای مثال، تصاویر کلاه به کیک و کیفهای دستی به تستر تبدیل میشوند. حذفکردن دادههای مخرب بسیار دشوار است؛ زیرا شرکتهای فناوری باید تک تک تصاویر خراب را پیدا کرده و از بین ببرند.

محققان، حمله خود را روی مدلهای اخیر Stable Diffusion و مدلی آزمایش کردند که خودشان از ابتدا آموزش دادهبودند. وقتی 50 تصویر سمی از سگ را به استیبل دیفیوژن خوراندند و خواستند که تصاویر سگ را برایشان تولید کند، خروجیها عجیب شدند. خروجی هوش مصنوعی شامل موجوداتی با اندامها و صورتهای کارتونی بودند. حملهکننده با 300 نمونه تصویر سمی توانست کاری کند که Stable Diffusion، تصاویر گربه را بهجای سگ خروجی بدهد.

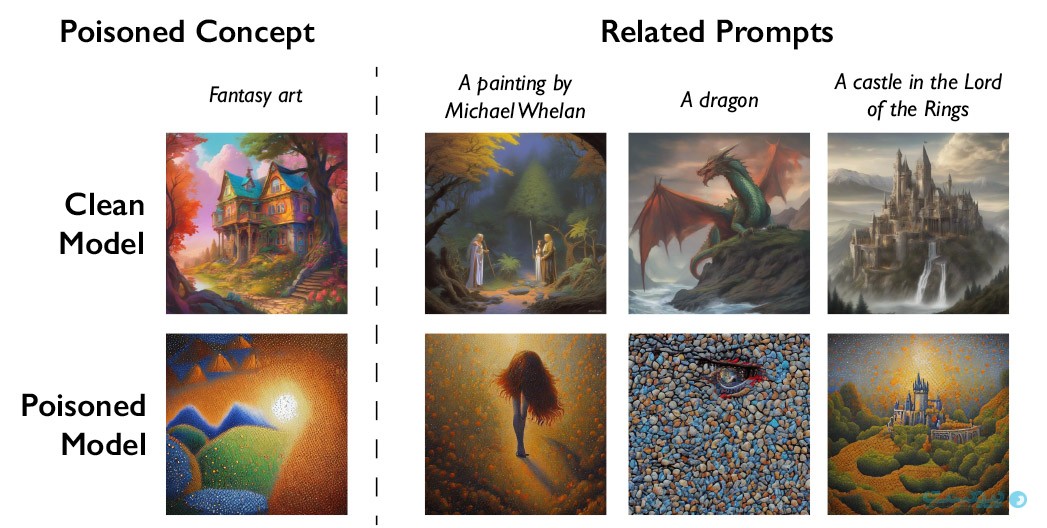

مدلهای هوش مصنوعی در ایجاد ارتباط بین کلمات فوقالعاده هستند. این ویژگی باعث گسترش بیشتر مسمومیت میشود. نایتشید نهتنها کلمه dog را آلوده میکند، بلکه روی مفاهیم مشابه مانند puppy، husky و wolf هم اثر میگذارد. سم به تصاویر مرتبط و مماس با دستور کاربر نیز حمله میکند. برای مثال، اگر هوش مصنوعی، تصویری سمی را برای دستور «اثر فانتزی» استخراج کرده باشد، دستورات مشابهی مانند «اژدها» و «قلعهای در ارباب حلقهها» نیز تبدیل به چیز دیگری میشوند.

ژائو اعتراف میکند که خطر سوءاستفاده مردم از روش مسمومکردن دادهها برای استفادههای خرابکارانه وجود دارد. با اینحال، او میگوید که مهاجمان برای واردکردن آسیبی جدی به مدلهای قدرتمند و بزرگ نیاز به هزاران نمونه سمی دارند؛ زیرا این مدلها با میلیاردها نمونه داده آموزش دیدهاند.

ویتالی شماتیکف، پروفسور دانشگاه کرنل که درباره امنیت مدل هوش مصنوعی مطالعه میکند و عضو تیم تحقیقاتی نیست، میگوید: «ما هنوز دفاع جامعی در برابر چنین حملههایی نمیشناسیم. ما هنوز حملههای سمی به مدلهای {یادگیری ماشین} مدرن در دنیای واقعی ندیدهایم؛ اما ممکن است فقط مسئله زمان مطرح باشد. همین الآن زمان کار روی دفاع است.»

گائوتام کاماث، دستیار پروفسور در دانشگاه واترلو که روی حریم خصوصی و جامعیت دادهها در مدلهای هوش مصنوعی تحقیق میکند و عضو تیم تحقیقاتی نیست، میگوید که این کار بسیاری معرکهای بودهاست.

کاماث میگوید: «تحقیق مزبور نشان میدهد که آسیبپذیریها در مدلهای جدید بهراحتی رفع نشده و فقط جدیتر میشوند. بهخصوص هرچه این مدلها قدرتمندتر شوند و افراد بیشتری به آن اعتماد کنند، این گفته رنگ واقعیت بیشتری میگیرد و مخاطرات آن در طول زمان بالاتر میرود.»

جانفنگ یانگ، پروفسور علوم کامپیوتر در دانشگاه کلمبیا که روی امنیت سیستمهای یادگیری عمیق مطالعه میکند و در این کار مشارکت نداشته، میگوید که نایتشید میتواند تاثیر زیادی داشته باشد اگر شرکتهای هوش مصنوعی را ملزم به رعایت حقوق هنرمندان کند؛ مثلا با پرداخت حق استفاده از آثار آنان.

شرکتهای هوش مصنوعی که مدلهای متن به تصویر مولد را توسعه دادهاند، مانند Stability AI و اپن AI، به هنرمندان اجازه دادهاند که از حضور آثارشان در آموزش نسخههای آینده این مدلها انصراف دهند. هنرمندان این پیشنهاد را کافی نمیدانند. ایوا تورننت، تصویرگر و هنرمندی که از گلیز استفاده میکند، میگوید که سیاست انصراف باعث میشود هنرمندان درگیر فرآیند دشوار این کار شوند و شرکتهای هوش مصنوعی را با همه قدرتشان تنها بگذارند.

تورننت امید دارد که نایتشید اوضاع کنونی را تغییر خواهد داد.

او میگوید: «قرار است {شرکتهای هوش مصنوعی} را مجبور به تامل جدی کنیم، زیرا این امکان وجود دارد که با استفاده بدون اجازه از آثار ما، همه مدلهای هوش مصنوعی خود را از بین ببرند.»

آتمن بیورلی، هنرمند دیگری است که میگوید ابزارهایی مانند نایتشید و گلیز به او اعتماد بهنفس دوبارهای برای انتشار آنلاین کارهایش دادهاند. او قبلا آثارش را از اینترنت حذف کرده بود، زیرا متوجه شده بود که آنها را بدون اجازه در دیتابیس مشهور تصاویر LAION استفاده کردهاند.

او میگوید: «من خیلی سپاسگزارم که ابزاری برای برگرداندن قدرت به هنرمندان برای مالکیت بر آثارشان داریم.»