تبعیض آشکار و نهان در دنیای داده؛ انعکاس جهان واقعی

۱۰ اردیبهشت ۱۴۰۱

زمان مطالعه : ۶ دقیقه

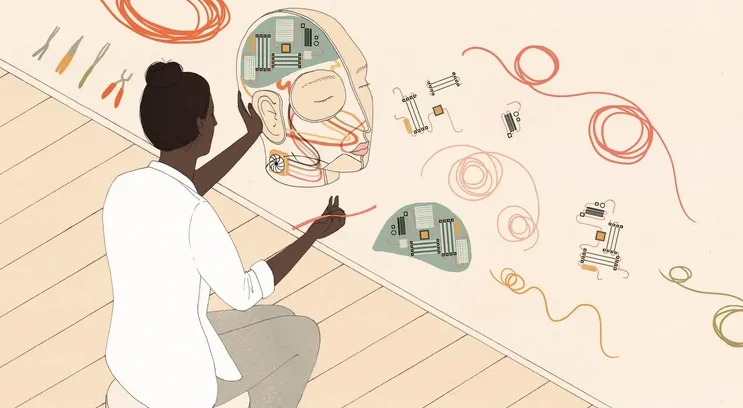

شماره ۱۰۰

بسیاری تصور میکنند که تبعیض جنسیتی و نژادی فقط در زندگی واقعی خود را نشان میدهد اما بررسیهای صورت گرفته مشخص کرده که این تبعیض حتی در دادهها و هوش مصنوعی نیز پابرجا هستند. تبعیضهای ناخودآگاهی که ریشه در گذشته و تجربیات افراد داشته به تکنولوژیهای حاضر نفوذ کرده و همین امر موجب باز منفی آن برای اقلیتهای جوامع مختلف شده است. مساله اخلاق در بحث داده فقط مربوط به نحوه استفاده نیست، بلکه همانقدر اهمیت دارد که چه کسی از آن استفاده میکند. رسوایی کمبریج آنالیتیکا به همه آموخت که باید اصول اخلاقی بزرگترین شرکتهای تکنولوژی را با دقت بیشتری بازبینی کنیم. اما تنها اینکه چه دادهای را میتوان جمعآوری کرد و چطور باید آن را به کار گرفت تازه آغاز ماجراست. سوال مهمتر این است که این تصمیمات بر عهده چه کسی است. طبق روال فعلی، قدرت تصمیمگیری و اصول اخلاقی بهکارگیری دادهها عمدتاً بر عهده مردان سفیدپوست است. طبق تحقیقات، تبعیضهای ناخودآگاهی که ریشه در گذشته و تجربیات فرد دارد، به تکنولوژی حاصل هم نفوذ کرده و برای اقلیتها پیامدهای منفی خواهد داشت. تشخیص چنین تبعیضهایی ساده نیست و به همین منظور یکی از ابزارهای مهم و ضروری برای مبارزه جلوگیری از تبعیض، آن هم پیش از آسیب، افزایش تنوع در نیروی کار است. از آنجا که اهمیت تصمیمات و الگوریتمهای دادهمحور بیشتر شده است، سوال اینجاست که شرایط چقدر در آینده تغییر میکند؟ متاسفانه شاخصها نشان میدهند که تغییر چندانی در پیش نیست. درباره چه پیامدهایی صحبت میکنیم؟ تبعیض الگوریتمی یک از موضوعات داغ مطالعاتی است و اشاره به حالتی دارد که تبعیض و جهتگیریهای انسان پای خود را به تصمیمات کامپیوتری باز میکنند. این موضوع به نگاه جنسیتی در ترجمهها، پیشنهادهای تبعیضآمیز برای مجازات مجرمان و تبعیض نژادی در سیستمهای تشخیص چهره منتهی شده است. برای مثال اگر از ابزار ترجمهای مثل گوگل ترنسلیت بخواهیم...

شما وارد سایت نشدهاید. برای خواندن ادامه مطلب و ۵ مطلب دیگر از ماهنامه پیوست به صورت رایگان باید عضو سایت شوید.

وارد شویدعضو نیستید؟ عضو شوید