گزارش گوگل: تنها ۵ درصد کارکنان «سواد واقعی هوش مصنوعی» دارند

یک گزارش جدید از شرکت گوگل نشان میدهد با وجود سلطه هوش مصنوعی بر فضای…

۳ اسفند ۱۴۰۴

۲۲ اردیبهشت ۱۴۰۴

زمان مطالعه : ۴ دقیقه

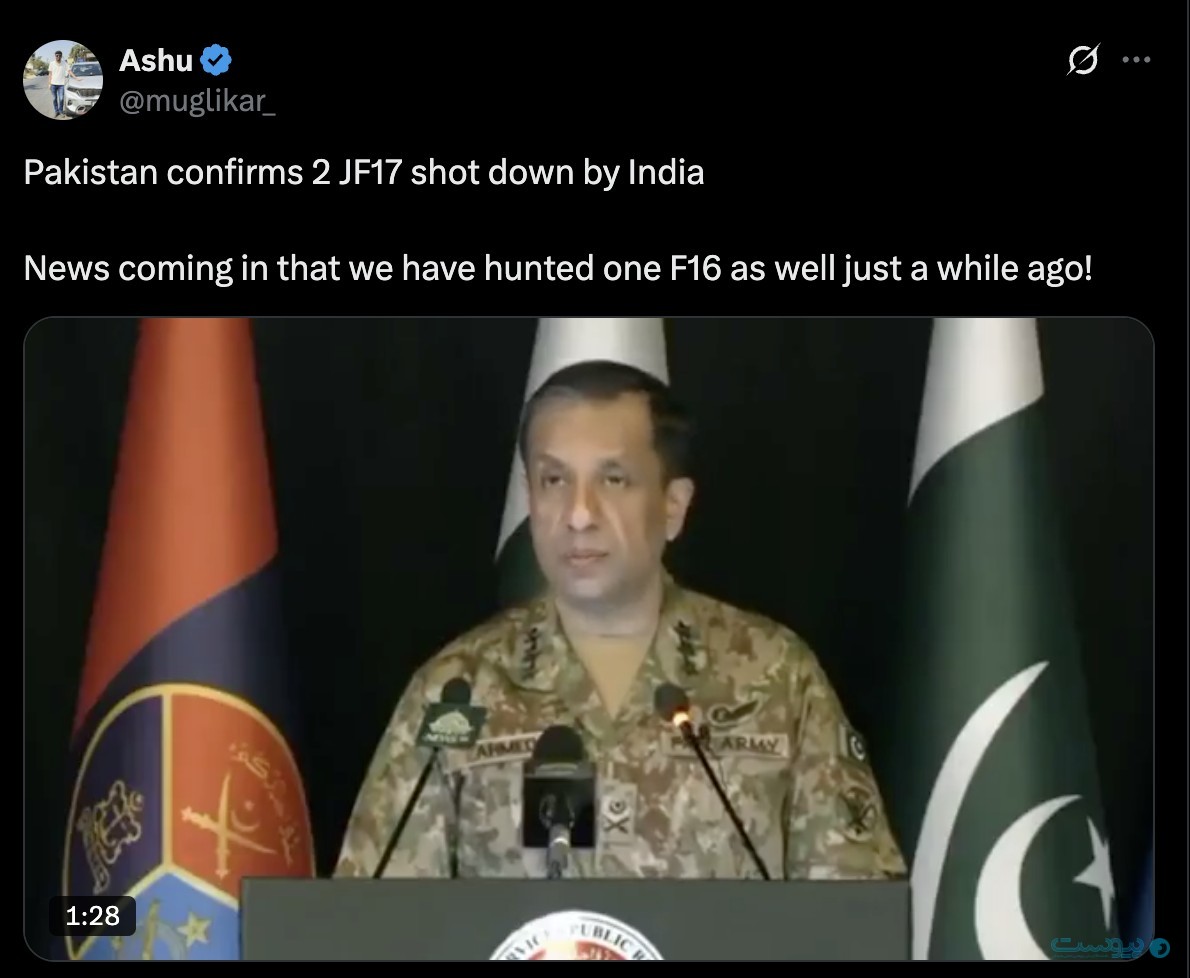

در پی حمله مرگبار به گردشگران در منطقه تحت کنترل هند در کشمیر در ماه گذشته، تنشها میان هند و پاکستان بهشدت افزایش یافت. این درگیری که حالا با تعهد به آتشبس متوقف شده است، با حملاتی از هر دو سو همراه بود اما شبکههای اجتماعی در این میان شاهد تاثیر مخرب دیپفیکها در شایعه پراکنی و انتشار اطلاعات نادرست بودند. گزارشی از bellingcat نشان میدهد که چطور ویدیو دیپفیکی از یک ژنرال ارتش پاکستان به سرعت در شبکه اجتماعی ایکس وایرال شد و حتی رسانههای معتبر هندی خبری را براساس آن منتشر کردند.

به گزارش پیوست، در تاریخ ۸ مه، یک ویدئوی دیپفیک از دونالد ترامپ، رئیسجمهور آمریکا، که ظاهرا تهدید به «نابودی پاکستان» میکرد، در فضای مجازی منتشر شد. این ویدیو با سرعت توسط راستآزماهای هندی تکذیب شد و تاثیر محدودی داشت. اما یک ویدئوی دیگر، این بار منتسب به احمد شریف چودری، ژنرال ارتش پاکستان، با موفقیت بیشتری توانست فضای رسانهای را تحت تاثیر قرار دهد.

این ویدیو که در شبکه اجتماعی ایکس (توئیتر سابق) منتشر شده بود، بیش از ۷۰۰ هزار بار بازنشر شد. چودری در دیپفیکی که براساس یک ویدیو قدیمیتر و مربوط به سال ۲۰۲۴ ساخته شده بود، در حال اعتراف به سقوط دو هواپیمای پاکستانی دیده میشد.

با وجود اینکه به این ویدیو بعدا برچسب «ساختهشده توسط هوش مصنوعی» را در شبکه اجتماعی ایکس دریافت کرد و توضیح Community Notes به آن اضافه شد، اما رسانههای معتبر هندی نیز پیش از راستآزمایی خبری را براساس آن منتشر کردند. رسانههای معتبر هند از جمله NDTV، Firstpost، The Statesman و The Free Press Journal پیش از راستیآزمایی، بخشهایی از ویدیو را در گزارشهای خبری خود منتشر کردند. برخی از این رسانهها پس از مشخص شدن جعلی بودن ویدیو، گزارشهای خود را بدون هیچ توضیحی حذف کردند.

گروه تحقیقاتی Bellingcat با مقایسه این ویدیو با نسخهای از همان کنفرانس خبری در سال گذشته، توانست جعلی بودن آن را اثبات کند. فرایند راستآزمایی نشان میدهد که چطور تنها با تغییر صدا، تولیدکنندگان دیپفیک توانستند در بحبوحه یک درگیری خطرناک، خبری جعلی منتشر کنند که ممکن بود بر اذهان عمومی و حتی تشدید درگیری تاثیرگذار باشد.

همانطور که در ویدیو بالا مشاهده میکند، دیپفیک تولید شده (سمت چپ) از لحاظ همه عناصر بصری، از موقعیت میکروفنها و پرچمها تا حرکات چودری، با نسخه اصلی یکسان است، اما صدا به گونهای تغییر پیدا کرده تا پیام ساختگی منتقل شود.

محمد زبیر، یکی از بنیانگذاران سازمان حقیقتسنج Alt News در هند، در گفتوگو با Bellingcat هشدار داد که چنین ویدیوهایی با وجود آنکه برای کارشناسان قابل شناسایی هستند، اما برای عموم مردم بسیار واقعی و قانعکننده به نظر میرسند. او میگوید عموم مردم از آنجایی به دلیل اینکه جنبه احساسی ویدیو را مورد توجه قرار میدهند، بدون فکر کردن دکمه اشتراکگذاری را فشار میدهند و این مساله «بسیاری نگرانکننده است زیرا [ویدیو دیپفیک] بسیار متقاعدکننده به نظر میرسد.»

راشل موران، پژوهشگر ارشد مرکز اطلاعرسانی عمومی در دانشگاه واشینگتن، نیز هشدار میدهد که فراهم شدن امکان ساخت و انتشار سریع چنین محتواهایی در دوران بحران، شفافسازی و تمایز میان شایعه و واقعیت را دشوارتر میکند و پدیدهای بسیار خطرناک و نگرانکننده است.

او میگوید: «در دورههای بحران، محیط اطلاعات در حالت عادی هم مبهم است ما به سرعت تلاش میکنیم که شایعه و واقعیت را از یکدیگر تشخیص دهیم. اما اینکه حالا ویدیوهای با کیفیت جعلی هم در این میان هستند باعث شده این فرایند سختتر و با اطمینان کمتر انجام گیرد و بدون شک ما را از اطلاعات واقعی و مهم دور کند.»

البته که این اولین مورد از انتشار ویدیوهای دیپفیک در میانه درگیریهای نظامی نیست. پیش از این نیز گزارشهایی از انتشار دیپفیک در درگیری اوکراین و همچنین غزه منتشر شده است که نشان دهنده اهمیت روزافزون تشخیص سریع اطلاعات نادرست در فضای خبری و به ویژه شبکههای اجتماعی است.