استارتآپ پژوهشگر سابق دیپمایند در آستانه ثبت رکورد تاریخی جذب سرمایه در اروپا

دیوید سیلور، یکی از برجستهترین پژوهشگران هوش مصنوعی بریتانیا که سال گذشته از گوگل دیپمایند…

۲۹ بهمن ۱۴۰۴

۲۱ مهر ۱۴۰۳

زمان مطالعه : ۲ دقیقه

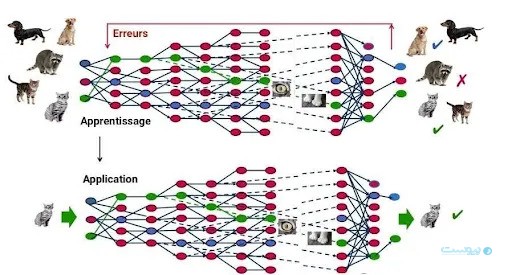

حملات مسموم سازی داده، به عنوان یکی از تهدیدات بزرگ امنیتی، امنیت سیستمهای هوش مصنوعی را بهشدت تحت تاثیر قرار داده است. دادههای مسمومشده شامل اطلاعاتی هستند که بهطور عمدی دستکاری یا تخریب شدهاند تا مدلهای هوش مصنوعی را به سمت تولید نتایج نادرست و خطرناک هدایت کنند.

به گزارش پیوست به نقل از نیسوس، حملات تخریب داده بهعنوان یکی از خطرناکترین تهدیدات امنیتی برای سیستمهای هوش مصنوعی شناخته شده است. این حملات به مهاجمان اجازه میدهد تا دادههای مخرب یا گمراهکننده را وارد مجموعه دادههای آموزشی کنند، که منجر به تولید نتایج اشتباه و آسیبپذیری در تصمیمگیریهای کلیدی میشود.

طبق گزارش جدید شرکت نیسوس، حتی درصد کمی از دادههای آلوده (مانند ۰.۰۰۱ درصد از دادههای آموزشی) میتواند عملکرد هوش مصنوعی را مختل کند. این حملات میتوانند تصمیمگیریهای کلیدی را در بخشهایی مانند سلامت و امنیت ملی تحت تاثیر قرار دهند.

برای مثال، در سال ۲۰۱۶، فیلتر هرزنامه جیمیل گوگل مورد حمله قرار گرفت. مهاجمان توانستند ایمیلهای مخرب را با دور زدن فیلتر ارسال کنند. همچنین، چتبات Microsoft Tay پس از آلوده شدن با دادههای مخرب، پاسخهای نامناسب و اشتباهی تولید کرد.

برای مقابله با این تهدیدات، نیسوس پیشنهاد میکند از تکنیکهای پیشرفتهتری مانند آموزش با نمونههای متخاصم، اعتبارسنجی دادهها و سیستمهای شناسایی تهدید مبتنی بر هوش مصنوعی استفاده شود. همچنین، چارچوبهای مقرراتی برای افزایش امنیت هوش مصنوعی ضروری است.

منبع: WORLD TECH NEWS