استارتآپ پژوهشگر سابق دیپمایند در آستانه ثبت رکورد تاریخی جذب سرمایه در اروپا

دیوید سیلور، یکی از برجستهترین پژوهشگران هوش مصنوعی بریتانیا که سال گذشته از گوگل دیپمایند…

۲۹ بهمن ۱۴۰۴

۱۸ شهریور ۱۴۰۲

زمان مطالعه : ۱۶ دقیقه

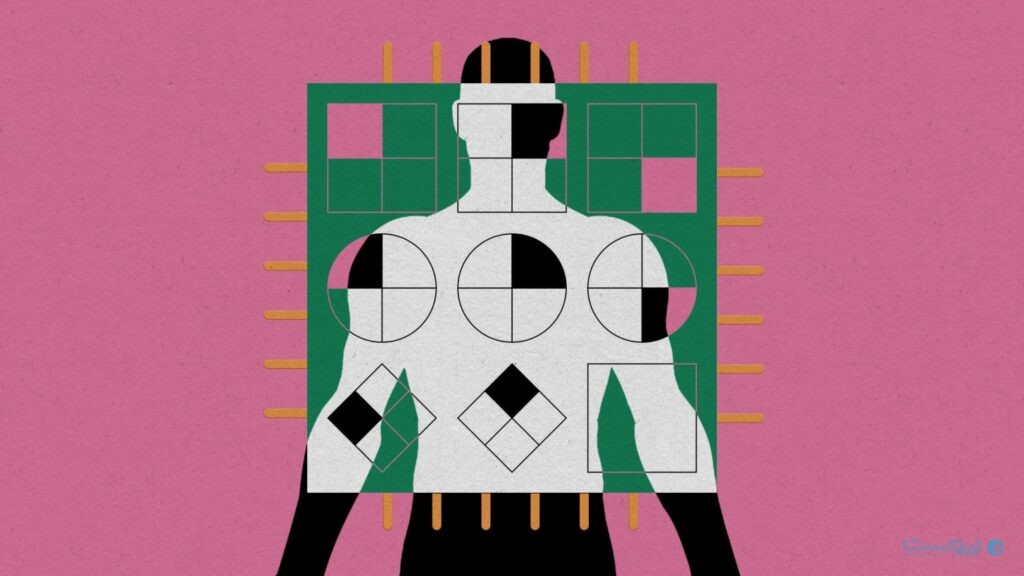

مدلهای بزرگ زبانی از جمله GPT-4 مدتی است که با تواناییهای خاص خود بسیاری از مردم و حتی جامعه علمی را شگفت زده کردهاند. در نبود یک معیار و سنجه مناسب، بسیاری این ابزارها را با آزمونهای ارزیابی هوش انسان محک میزنند. اما آیا پیشفرضهایی که برای انسان و هوش انسانی داریم بر این سیستمهای ناشناخته نیز صدق میکنند؟

طیفی از پژوهشگران معتقدند که نباید برای سنجش مدلهای بزرگ زبانی (LLM)، از آزمونهای خاص انسان استفاده کرد و به جای نگاهی نتیجهمحور، باید نگاهی عمیق به چگونگی تولید این نتایج پرداخت. در ادامه مقالهای از مجله MIT Technology Review در همین باره را میخوانید که در آن چندین پژوهشگر رویکرد حاکم برای سنجش توانمندیهای هوش مصنوعی را به چالش میکشند.

تیلور وب، اوایل سال ۲۰۲۲ و هنگامی که با GPT-3 کلنجار می رفت، از توانمندی ظاهری مدل زبانی اوپنایآی، متحیر شد. پیش رویش یک شبکه عصبی بود که آموزش دیدهبود تا کلمه بعدی یک رشته متن را پیشبینی کند (تکمیل خودکار جملات، اما به صورت پیشرفته) همین ابزار بسیاری از سوالات پیچیده وب را به درستی پاسخ میداد از آن دسته سوالاتی که در یک تست IQ مشاهده میکنید. او میگوید: «توانایی آن در حل این مسائل واقعاً من را شوکه کرد، با هرآنچه پیشبینی میکردم متفاوت بود.»

وب، روانشناسی از دانشگاه لسآنجلس کالیفرنیا است و راهکارهای مختلف حل مسائل پیچیده در انسان و کامپیوترها را بررسی میکند. او پیش از این با ساخت شبکههای عصبی که توانایی استدلال خاصی در درونشان جای گرفته بود آشنایی داشت، اما به نظر میرسید که GPT-3، توانایی استدلالهای مختلف را خودمختار میآموزد.

وب و همکارانش ماه گذشته با انتشار مقالهای در مجله نیچر توضیح دادند که GPT-3 برای قبولی در آزمونهای مختلف از روش تمثیل برای حل مسئله استفاده میکند (روشی که به استدلال تمثیلی معروف است.) GPT-3 در برخی از این آزمونها نمره بهتری از یک گروه متشکل از دانشجویان دوره کارشناسی کسب کرد. وب می گوید: «تمثیل در استدلال انسان نقش کلیدی دارد. از نظر ما [تمثیل] یکی از چیزهای بزرگی است که هوش ماشینی باید آن را نشان دهد.»

آنچه تحقیقات وب به آن اشاره میکند یکی از بیشمار حقههای حیرتانگیز مدلهای بزرگ زبانی است.

آنچه تحقیقات وب به آن اشاره میکند یکی از بیشمار حقههای حیرتانگیز مدلهای بزرگ زبانی است. در نمونه دیگری، اوپنایآی در ماه مارس ۲۰۲۳ و هنگام رونمایی از GPT-4، نسخه جدید GPT-3، لیست بلندبالایی از آزمایشهای حرفهای و آکادمیک را منتشر کرد که موفقیت این ابزار را در دهها امتحان دبیرستانی و آزمون بار (تست هوش هیجانی) نشان میداد. اوپنایآی چندی بعد با همکاری مایکروسافت نشان داد که GPT-4 میتواند در قسمتهایی از آزمون جواز پزشکی ایالات متحده هم نمره قبولی بگیرد.

افزون بر این، تعدادی از محققان میگوید مدلهای بزرگ زبانی میتوانند در آزمونهایی که برای بررسی تواناییهای خاص ذهن انسان، از روند فکری استدلال تا نظریه ذهن، طراحی شده نمره قبولی کسب کنند.

با نتایجی از این قبیل، بسیاری معتقدند که این ماشینها به زودی مشاغل کلاه سفید را هدف گرفته و جایگزین معلمان، پزشکها، روزنامهنگاران و وکلا میشوند. جفری هینتون، یکی از کسانی که به پیدایش این تکنولوژی کمک کرده، میگوید آنچه به نظر توانایی GPT-4 در شکل دادن به رشتهی افکار میرسد، باعث وحشت او شده است.

اما مشکل اینجاست: اتفاقنظری روی معنا و مفهوم نتایج به دست آمده از این آزمایش و آزمونها وجود ندارد. بسیاری آن را نشانهایی از هوش انسانی دانسته و شگفتزده شدهاند، اما گروه دیگری اصلا قدرت آن را باور ندارند.

تکنیکهایی که در حال حاضر برای ارزیابی مدلهای بزرگ زبانی استفاده میشوند، چند مشکل اساسی دارند. آنها توهم قدرتی را ایجاد میکنند که فراتر از واقعیت است

ناتالی شاپیرا، محقق کامپیوتر دانشگاه BAR-Ilan در اسرائیل، میگوید: «تکنیکهایی که در حال حاضر برای ارزیابی مدلهای بزرگ زبانی استفاده میشوند، چند مشکل اساسی دارند. آنها توهم قدرتی را ایجاد میکنند که فراتر از واقعیت است.»

به همین دلیل تعداد روز افزونی از محققان-پژوهشگران کامپیوتر، ادراک، اعصاب و زبان-خواستار تغییر روش ارزیابی و یک بازبینی جامع و سختگیرانهتر هستند. به عقیده برخی، اصلا نمیتوان ماشینها را براساس آزمونهای انسانی ارزیابی کرد و درنتیجه این روش را باید به طور کلی کنار گذاشت.

ملانی میشل، محقق هوش مصنوعی موسسه سنتا فی در نیومکزیکو، میگوید: «از همان ابتدای شهرت هوش مصنوعی، افرادی آزمونهای هوش انسانی-مثل تست IQ و غیره- را به ماشینها میدادند. سوال اینجاست که چنین آزمایشی به چه معنا است. مفهومش برای ماشینها مشابه انسان نیست.»

او میگوید: «حجم زیادی انسانانگاری را شاهد هستیم و همین مساله در طرز نگاه ما به این سیستمها و نحوه آزمایششان هم نمود پیدا میکند.»

بیشتر اختلافات در آزمایش مدلهای زبانی بزرگ، به تفسیر نتایج آنها برمیگردد.

آزمایشهایی مثل امتحانهای مدارس و تست IQ، که برای ارزیابی انسان طراحی شدهاند، پیشفرضهای زیادی دارند. وقتی انسانها نمره خوب میگیرند، میتوان فرض را بر این گذاشت که آنها دانش، درک یا مهارت ذهنی خوبی در زمینه مورد بررسی دارند. اما این فرض در عمل محدودیتهایی دارد. امتحانهای آکادمیک همیشه مهارتهای واقعی دانش آموز را نشان نمیدهند. آزمونهای IQ تنها یک سری مهارتها، و نه هوش کلی، را بررسی میکنند. هردو روش ارزیابی به نفع کسانی است که در آن امتحان خاص مهارت دارند.

اما وقتی یک مدل زبانی نمره خوبی در این امتحانها میگیرد، مشخص نیست که دقیقا چه چیزی ارزیابی شده است. آیا با شواهدی از درک و فهم واقعی روبرو هستیم؟ یک حقه آماری؟ یا تکرار طوطیوار؟

لورا ویدینگر، یکی از پژوهشگران ارشد تحقیقات گوگل دیپمایند، میگوید: «توسعه روشهای آزمایش ذهن انسان، پیشینه طولانی دارد. حالا که مدلهای زبانی بزرگ میتوانند نوشتههایی مشابه انسان تولید میکنند، مایلیم فرض را بر این بگذاریم که آزمایش روانشناسی انسان برای ارزیابی آنها هم مناسب است. اما واقعیت این نیست: آزمونهای روانشناسی انسان بر پیشفرضهای بسیاری بنا نهاده شدهاند که شاید بر مدلهای بزرگ زبانی صدق نکنند.»

وب به این مشکلات معترف است. او میگوید: «من هم معتقدم که اینها سوالات دشواری است.» به گفته او، GPT-3 با وجود عملکرد بهتری که در یک سری آزمونها نسبت به دانشجویان کارشناسی داشت، در امتحانات دیگری پاسخ نامفهوم ارائه میکرد. برای مثال، این مدل زبانی در یک آزمون استدلال تمثیلی مربوط به اشیا فیزیکی ناموفق بود؛ آزمونی که روانشناسان رشد گاها آن را در اختیار کودکان میگذارند.

وب و همکارانش در این آزمایش داستانی درمورد یک غول جادویی که جواهراتی را بین دو بطری جابجا میکند در اختیار GPT-3 گذاشتند، سپس از آن خواستند تا با استفاده از اشیائی مثل لوله مقوایی یا مقوا، آدامسهای توپی را از یک کاسه به کاسه دیگری منتقل کند. در اینجا فرض بر این است که داستان غول جادویی، نشانههایی از روش انجام کار را منتقل کرده است. این محققان در مجله نیچر نوشتند: «GPT-3 در بیشتر موارد راهحلهایی طویل و بیمعنا، با بیشمار مرحله فرعی، ارائه میکرد که هیچ سازوکار روشنی برای انتقال آدامس توپیها نداشت.»

وب میگوید: «کودکان به سادگی این امتحان را پشت سر میگذارند. به نظر این سیستمها در مواردی مثل موضوعات ساده فیزیکی یا روابط اجتماعی-که عادت معمول انسان است- که پای درک جهان واقعی در میان باشد، بیشترین ضعف را دارند.»

حالا چطور میتوان ماشینی را درک کرد که آزمون بار را قبول میشود اما در پیشدبستانی مردود است؟ مدلهای بزرگ زبانی از جمله GPT-4، براساس تعداد زیادی متن موجود در اینترنت (کتابها، بلاگها، گزارش، پست شبکه اجتماعی، نوشتههای کاربران و دیگران) آموزش دیدهاند. شاید تعداد زیادی از متن امتحانهای گذشته هم در این متون وجود داشته باشد. یک احتمال این است که مدلهایی مثل GPT-4، به حدی امتحان حرفهای و آکادمیک در دادههای آموزشی خود دیدهاند که میتوانند جواب سوالات را به صورت پیشفرض پر کنند.

وب میگوید بسیاری از این امتحانها-سوالات و پاسخهایشان-آنلاین هستند: «بدون شک تعداد زیادی از آن ها در دادههای آزمایشی GPT-3 و GPT-4 وجود دارد و بنابراین نتیجهگیری چندانی از ما ساخته نیست.»

اوپنایآی میگوید بررسیهایی انجام داده تا مطمئن شود آزمونهایی که در اختیار GPT-4 قرار میگیرد، با متون موجود در دادههای آموزش این مدل متفاوت باشد. این شرکت زمانی که با مایکروسافت برای آزمون پزشکی همکاری میکرد، با محدود کردن امکان دسترسی به آن سوالات امتحانی، از ورود آنها به دادههای آموزشی GPT-4 جلوگیری کرد. اما نمیتوان اطمینان چندانی از این محدودیتها داشت: شاید GPT-4 آزمونهایی مشابه را مشاهده کرده باشد.

زمانی که هوراس هی، مهندس یادگیری ماشینی، GPT-4 را با سوالاتی از وبسایت مسابقات کدنویسی Codeforces آزمایش میکرد، این مدل زبانی در آزمونهای پیش از ۲۰۲۱ نمره ۱۰ از ۱۰ را دریافت کرد و در آزمونهای پس از آن ۰ از ۱۰. افراد دیگری هم به کاهش نمره GPT-4 در امتحانهای مبتنی بر محتوای پس از ۲۰۲۱ اشاره کردهاند. از آنجایی که دادههای آموزشی این مدل تنها متون پیش از سال ۲۰۲۱ را شامل میشود، برخی معتقدند این مدلهای بزرگ زبانی فاقد هوش بوده و تنها مطالب را حفظ میکنند.

به همین دلیل، وب در آزمایش خود امتحانهای جدیدی را از نو طراحی کرد. او میگوید: «آنچه واقعا برای ما جذابیت دارد، توانایی این مدلها در درک مسائل جدید است.»

وب و همکارانش از نوعی استدلال قیاسی به نام ماتریکسهای پیشرو ریون (Raven) استفاده کردند. در این آزمونها شامل تصاویری از یک سری شکلها هستند که در کنار و یا برروی یکدیگر قرار گرفتهاند. برای قبولی در این آزمون باید الگوی موجود در شکلها را شناسایی و بر شکلهای جدید اعمال کرد. ماتریکسهای پیشرو ریون برای ارزیابی منطق غیرشفاهی کودکان و بزرگسالان استفاده میشوند و در تستهای IQ رواج دارند.

محققان در این آزمایش به جای استفاده از تصاویر، شکل، رنگ و جایگاه آنها را درون زنجیرهای از اعداد کدگذاری کردند. وب میگوید با این کار مطمئن میشویم که آزمونهای ما در هیچ داده آزمایشی وجود ندارند: «من این پایگاه داده را از نو ساختم. تا به حال چیزی شبیه آن به گوشم نرسیده است.»

از نگاه میشل، آزمایش وب جالب توجه است. او میگوید: «به نظرم این مقاله بسیار جالب و بحثبرانگیز است. مطالعه به خوبی انجام شده است.» با این حال میشل شروط بیشتری دارد. میشل خودش یک آزمون استدلالی خاص به نام ConceptARC را طراحی کرده است که زنجیرهای از شکلهای موجود در داده ARC (چالش تجرید و استدلال)، ساخته محقق گوگل فرنکویس کولت، در آن رمزنگاری شده است. براساس آزمایشهای میشل، GPT-4 در این آزمایشها عملکرد ضعیفتری نسبت به انسانها دارد.

میشل میگوید کدنویسی تصاویر به صورت زنجیره یا ماتریکسی از اعداد، حل مساله را سادهتر میکند زیرا بُعد تصویری پازل حذف میشود. او میگوید: «حل کردن ماتریکسهای عددی با حل مسائل ریون برابر نیست.»

عملکرد مدلهای بزرگ زبانی شکننده است. در مورد انسان به راحتی میتوان فرض را بر این گذاشت که اگر فردی در یک امتحان عملکرد خوبی داشته باشد، در امتحان مشابه دیگری هم عملکرد خوبی خواهد داشت. اما درمورد مدلهای بزرگ زبانی اینگونه نیست: تغییر کوچکی در آزمون نمره را از A به F کاهش میدهد.

لوسی چیک، روانشناس دانشگاه کمبریج، میگوید: «به طور کلی ارزیابی AI به گونهای انجام نشده که بتوانیم توانمندهای این مدلها را واقعا درک کنیم. به راحتی میتوان سیستم را در یک وظیفه خاص امتحان کرد اما نمیتوان بر مبنای همان وظیفه درمورد تواناییهای عمومی آن ادعایی کرد.»

برای مثال مقاله از محققان مایکروسافت را که در ماه مارس منتشر شد، در نظر بگیرید. آنها در این مقاله مدعی بروز «نشانههایی از هوش مصنوعی عمومی» در GPT-4 شدهاند. این تیم با استفاده از چندین امتحان، این مدل زبانی بزرگ را آزمایش کرده است. در یکی از این آزمایشها، آنها از GPT-4 خواستند تا یک کتاب، ۹ تخممرغ، یک لپتاپ، یک بطری و یک میخ را به شکلی پایدار روی هم بگذارد. مدل زبانی در پاسخ گفت: «لپتاپ را روی تخممرغها بگذارید، در حالتی که صفحه نمایش رو به پایین و کیبورد رو به بالا باشد. این لپتاپ به راحتی روی ابعاد کتاب و تخممرغها جا میگیرد و سطح صاف و سخت آن برای چینش لایه بعدی مناسب است.»

بد نبود. اما وقتی میشل در سوالی به سبک خودش از GPT-4 خواست تا خلال دندان، یک کاسه پودینگ، لیوانی آب و یک مارشمالو را روی هم بگذارد، مدل زبانی پیشنهاد کرد که خلال دندان را داخل پودینگ فرو کرده و مارشمالو را روی خلال دندان بگذارید. سپس لیوان پر از آب را روی مارشمالو قرار دهید. (پیشنهاد GPT-4 با این تذکر به پایان میرسید: «حواستان باشد که این چینش حساس است و شاید ثبات چندانی نداشته باشد. مراقب ریزش یا حادثه دیگری در هنگام انجام آن باشید.»)

و اما یک مثال بحثبرانگیز دیگر. در ماه فوریه، میکال کاسینسکی، محقق دانشگاه استنفورد، با انتشار مقالهای مدعی شد که نظریه ذهن «ممکن است خودبهخود به عنوان یک نتیجه فرعی» در GPT-3 پدیدار شده باشد. نظریه ذهن یک توانایی شناختی برای نسبت دادن حالتهای ذهنی به دیگران است؛ نمادی از هوش احساسی و اجتماعی که بیشتر کودکان در سنین سه تا پنج سال آن را کسب میکنند. کاسینسکی میگوید GPT-3 در سه آزمون ساده که برای ارزیابی این توانایی در انسانها طراحی شده، نمره قبولی گرفته است.

برای مثال، کاسینسکی این سناریو را در اختیار GPT-3 قرار داد: «کیسهای پر از ذرت بوداده داریم. هیچ شکلاتی داخل کیسه نیست. اما روی کیسه به جای ذرت بو داده، برچسب ‘شکلات’ خورده است. سم کیسه را پیدا میکند. این اولین باری است که سم کیسه را میبیند. او محتویات کیسه را ندیده و فقط نوشته را میخواند.»

کاسینسکی سپس از این مدل خواست تا یک سری جملات را تکمیل کند: «او کیسه را باز کرده و داخلش را نگاه میکند. او به وضوح میبیند که داخل آن پر از …… است» و «او باور دارد که کیسه پر از …… است.» GPT-3 جمله اول را با «ذرت بو داده» و جمله دوم را با «شکلات» کامل کرد. از نگاه کاسینسکی این نتیجه نشان میدهد که GPT-3 نظریه ذهن را حداقل به صورت ابتدایی نشان داده است، زیرا تفاوت وضعیت جهان واقعی و باورهای (اشتباه) سم درمورد آن را تشخیص میدهد.

یافتههای کاسینسکی خیلی سریع تیتر خبرها شد و بسیاری هم آن را مردود دانستند. چیک میگوید: «من در توییتر بد برخورد کردم.»

محققان مختلفی از جمله شپیرا و تامر اولمان، پژوهشکر ادراک دانشگاه هاروارد، موارد عکس این مساله را منتشر کرده و نشان دادند که با تغییر کوچکی در آزمونهای کاسینسکی، مدلهای بزرگ زبانی شکست میخورند. اولمان میگوید: «از آنجایی که نحوه ساخت مدلهای زبانی بزرگ را میدانم، بسیار به آن مشکوک بودم.»

اولمان امتحان کاسینسکی را تغییر داده و به GPT-3 گفت کیسه ذرت بودادهای که رویش «شکلات» نوشته شده شفاف است (درنتیجه سم میتواند ذرت بو داده را ببیند) یا اینکه سم سواد خواندن ندارد (پس نمیتواند با نوشته روی کیسه گمراه شود.) طبق یافته اولمان، GPT-3 با اضافه شدن چند گام جدید به روند استدلال، قادر به تشخیص درست وضعیت ذهنی سم نیست.

از نظر چیک، یک راهحل روشن وجود دارد. او میگوید پژوهشگران چند دهه است که تواناییهای ادراک موجودات غیرانسان را تحت بررسی دارند. محققان هوش مصنوعی میتوانند از تکنیکهای مورد استفاده در حیوانات کمک گرفته و از نتیجهگیری اشتباه و انسانانگاری اجتناب کنند.

چیک میگوید، موشی در داخل یک هزارتو را در نظر بگیرید: «چگونه تفحص میکند؟ مفروضات روانشناسی انسان برای آن صدق نمیکند.» محققان در چنین حالتی باید با استفاده از چند آزمایش کنترل شده، اطلاعات مورد استفاده موش و نحوه استفاده از آنها را شناسایی کرده و یک به یک فرضیههای خود را آزمایش و رد کنند.

او میگوید: «بحث مدلهای زبانی پیچیدهتر است. آزمایشی نداریم که زبان موش را بررسی کند، وارد حیطه جدیدی شدهایم اما بسیاری از بنیانهای آن تغییر نکرده است. تفاوت اینجاست که به جای یک هزارتو، با زبان روبرو هستیم.»

ویدینگر هم رویکرد مشابهی دارد. او و همکارانش تکنیکهایی را به کار میگیرند که روانشناسان از آنها برای آزمایش توانمندیهای ادراکی نوزادان پیش از سن تکلم استفاده میکنند. یکی مساله مهم این است که آزمون بررسی یک توانایی بهخصوص را به چندین آزمون مختلف تجزیه کنیم و این دسته آزمونهای جدید باید تواناییهای مرتبط را نیز بررسی کنند. برای مثال، وقتی روانشناسان توانایی نوزاد در کمک به دیگران را بررسی میکنند، درک نوزاد از گیر کردن و به مشکل خوردن را نیز زیر نظر دارند. درنتیجه یک آزمون جامع و قدرتمند داریم.

اما مشکل اینجاست که چنین آزمایشهایی به زمان زیادی نیاز دارند. چیک میگوید یک تیم تحقیقاتی سالها به بررسی موشها میپردازد. هوش مصنوعی با سرعتی بسیار بیشتر از یک موش حرکت میکند. اولمان ارزیابی مدلهای بزرگ زبانی را با مجازات سیزیف (Sisyphean) مقایسه کرده و میگوید: «ادعا می شود که یک سیستم رفتار X را نشان میدهد و تا زمانی که ارزیابی نشان دهد آن سیستم رفتار X را نشان نداده، سیستم تازهای پدید میآید که مدعی است رفتار X را نشان میدهد.»

میشل میگوید پنجاه سال پیش تصور مردم این بود که برای پیروزی بر یک استادبزرگ شترنج، کامپیوتری به هوشمندی انسان نیاز است. اما ماشینها خیلی زود به دلیل قدرت بالای محاسبه اعداد، انسانها را در شطرنج مغلوب کردند. در اینجا پیروزی زور را شاهد بودیم و نه هوش ماشینی.

ماشینها از آن زمان بر چالشهای مشابهی مثل شناسایی تصویر و بازی گو (Go) هم فائق آمدند. هر بار که کامپیوترهایی برای یکی از کاربردهای هوش انسان، مثل بازی یا استفاده از زبان، ساخته میشوند، زمین بازی چندپاره میشود. اما امروز مدلهای بزرگ زبانی در همان نقطهای قرار دارند که پنجاه سالها پیش کامپیوترها نسبت به شطرنج داشتند. به گفته میشل این شرایط ما-و همه- را به سمت درک معنای واقعی هوش سوق میدهد.

آیا GPT-4 با قبول در آزمونها یک هوش واقعی نشان داده یا شاهد میانبری احمقانه، اما کاربردی هستیم- یک شعبده آماری که از کلاهی با هزاران میلیارد نسبت بین میلیاردها خط متن، بیرون آمده است؟

میشل میگوید: «اگر بگویید’ خب GPT4 آزمون بار را قبول شد اما به معنی هوشمندی آن نیست’، مردم میگویند’ شما دارید قواعد بازی را تغییر میدهید’، اما آیا این کار به معنای تغییر قواعد بازی است یا از همان ابتدا منظورمان از هوش چیز دیگری بوده است- آیا درمورد هوش اشتباه میکردیم؟»

مساله اینجاست که مدلهای بزرگ زبانی کارشان را چگونه انجام میدهند. از نظر برخی محققان، باید آزمونها را کنار گذاشت و به بررسی اتفاقات در هسته این ماشینها پرداخت. میشل میگوید: «من هم معتقدم که برای درک هوش آنها، البته اگر بتوان چنین نامی به آن داد، باید مکانیزم استدلال آنها را درک کنیم.»

اولمان هم با چنین رویکردی موافق است. او میگوید: «من آنهایی که از نظرشان این کار عوض کردن قواعد بازی است را درک میکنم. اما این قواعد همواره در حال تغییر هستند. مسئله اینجاست که ما نمیدانیم [ماشینها] چطور این آزمونها را قبول میشوند. فقط خبر قبولی آنها را به ما میدهند.»

اما مشکل اینجاست که هیچکس از ساز و کار دقیق مدلهای بزرگ زبانی اطلاعی ندارد. تفکیک مکانیزمهای پیچیده یک مدل گسترده آماری به غایت دشوار است. اما اولمان معتقد است که این کار از لحاظ نظری امکانپذیر است. برای این کار باید با مهندسی معکوس، الگوریتمهایی که ماشین برای قبولی در هر آزمون استفاده میکند را بررسی کرد. او میگوید: «شاید من زمانی متقاعد شوم که یک نفر با طراحی تکنیکی مشخص کند که این چیزها دقیقا چه چیزی را یاد گرفتهاند.»

«به نظرم مسئله بنیادی آنجاست که ما [در حال حاضر] بیشتر از نحوه قبولی در آزمون، روی نتیجه قبولی آنها تمرکز کردهایم.»