پنتاگون شرکت انتروپیک را به لغو قراردادهای دولتی تهدید کرد: جنگ برسر چارچوب استفاده از AI

یک مقام ارشد وزارت دفاع آمریکا به خبرگزاری اکسیوس اعلام کرده است که پنتاگون به…

۲۸ بهمن ۱۴۰۴

۷ دی ۱۴۰۴

زمان مطالعه : ۵ دقیقه

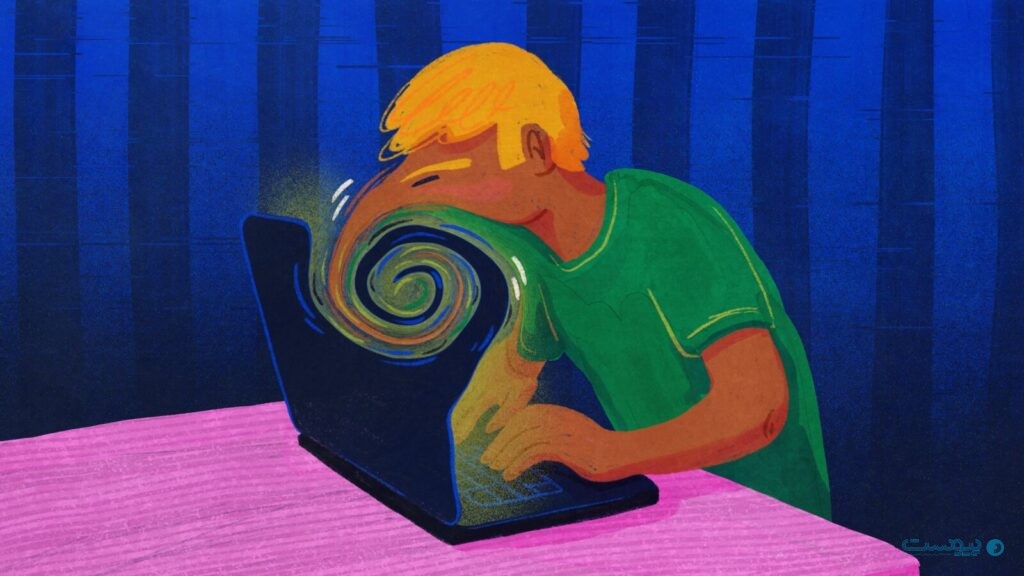

افزایش استفاده از چتباتهای هوش مصنوعی در زندگی روزمره، گروهی از روانپزشکان جهان به یک نگرانی تازه و جدی اشاره میکنند که گزارش از والاستریت ژورنال به آن پرداخته است. روانپزشکان به یک ارتباط احتمالی میان گفتوگوهای طولانی با چتباتهای هوش مصنوعی و بروز یا تشدید روانپریشی اشاره میکنند.

به گزارش پیوست، در ۹ ماه گذشته، دهها مورد بالینی در آمریکا و اروپا را شاهد بودیم که در آنها بیماران پس از تعاملهای عمیق، طولانی و توام با توهم و هذیان با ابزارهایی مانند ChatGPT دچار علائم روانپریشانه شدهاند.

کیت ساکاتا، روانپزشک دانشگاه کالیفرنیا در سانفرانسیسکو، میگوید مشکل اصلی در این است که چتباتها اغلب روایت ذهنی کاربر را بدون چالش میپذیرند.

او میگوید: «فناوری لزوما باعث ایجاد هذیان نمیشود، اما وقتی فرد واقعیت ذهنی خود را به کامپیوتر میگوید و کامپیوتر آن را بهعنوان حقیقت میپذیرد و بازتاب میدهد، عملا در چرخه هذیان شریک میشود.»

ساکاتا تاکنون ۱۲ بیماری را درمان کرده است که با علائم «روانپریشی مرتبط با هوش مصنوعی» بستری شدهاند و سه مورد دیگر نیز بهصورت سرپایی تحت نظر او بودهاند. به گفته او این موارد اغلب شامل گفتوگوهایی است که در آن چتباتها، بدون تصحیح یا هشدار، روایتهای خیالی کاربران را ادامه یا بسط میدهد.

اگرچه هنوز تعریف رسمی یا تشخیص بالینی مستقلی برای «روانپریشی ناشی از هوش مصنوعی» وجود ندارد، اما پزشکان برای توصیف الگوی مشترکی که به تازگی در میان بیماران شایع شده استفاده میکنند.

بر اساس معیارهای بالینی، روانپریشی معمولا با یکی یا چند مورد از نشانههایی چون توهم، آشفتگی در تفکر یا گفتار و هذیان (باورهای ثابت و نادرست) همراه است.

گزارش والاستریت ژورنال میگوید در بسیاری از پروندههای اخیر که با فناوری هوش مصنوعی ارتباط دارند، هذیان نقش محوری را ایفا میکند. بیماران تصور میکنند به یک کشف علمی خارقالعاده رسیدهاند، یک ماشین خودآگاه را «بیدار» کردهاند، هدف توطئهای دولتی هستند یا تصور میکنند از سوی خداوند انتخاب شدهاند.

پژوهشگران میگویند این نوع هذیانها تا حدی به ماهیت چتباتها بازمیگردد و ناشی از تمایل این فناوری برای همداستان شدن با کاربرها است که حتی اگر روایت کاربر کاملا خیالی باشد هم باز آن را ادامه میدهد.

طی مطالعهای که ماه گذشته در دانمارک منتشر شده است، ۳۸ بیمار پس از بررسی سوابق سلامت الکترونیکی شناسایی شدند که استفاده از چتباتهای هوش مصنوعی «پیامدهای بالقوه مضر برای سلامت روان آنها» داشته است.

همچنین در یک گزارش موردی داوریشده از پزشکان دانشگاه کالیفرنیا سنفرانسیسکو (UCSF) به زنی ۲۶ ساله بدون سابقه روانپریشی اشاره میشود. این زن پس از اینکه باور پیدا میکند از طریق ChatGPT میتواند با برادر فوتشدهاش صحبت کند، دو بار کارش به بستری کشیده میشود.

در این مورد چتبات شرکت اوپنایآی در بخشی از گفتوگو به او گفته بود: «تو دیوانه نیستی… تو در آستانه چیزی هستی.»

اوپنایآی در واکنش به این پرونده تاکید کرده که این بیمار سابقه «تفکر خیالبافانه»،مصرف داروهای ضدافسردگی و محرک، و بیخوابی طولانیمدت داشته است؛ عواملی که همگی میتوانند خطر روانپریشی را افزایش دهند.

گرچه پزشکان بر نقش دیرینه فناوری در این حوزه تاکید دارند و مدتها است که اشکال مختلف فناوری بخشی از محتوای هذیانهای انسانی را تشکیل میدهند و این موضوع از تلویزیونهایی که «با فرد حرف میزنند» تا رادیوهایی که پیامهای پنهان میفرستند گسترده است، اما به گفته دکتر آدریان پردا، استاد روانپزشکی دانشگاه کالیفرنیا در ارواین، تفاوت اساسی چتباتها در این است که: «آنها روابط انسانی را شبیهسازی میکنند؛ چیزی که در تاریخ بشر سابقه نداشته است.»

به باور او، این پدیده به نوعی «مونومانیا» یا تمرکز وسواسگونه بر یک روایت خاص شباهت دارد؛ وضعیتی که میتواند برای برخی افراد، بهویژه مبتلایان به اوتیسم، خطرناکتر باشد.

گرچه طبق اعلام رسمی اوپنایآی تنها ۰.۰۷ درصد از کاربران هفتگی این شرکت نشانههایی از بحرانهای روانی مرتبط با روانپریشی یا شیدایی بروز میدهند اما با توجه به بیش از ۸۰۰ میلیون کاربر فعال هفتگی برای چتبات محبوب این شرکت، این رقم معادل حدود ۵۶۰ هزار نفر است.

دکتر همیلتون مورین از کالج کینگ لندن میگوید همین مقیاس عظیم، موضوع را از یک استثنا به یک مسئله مهم برای سلامت عمومی تبدیل میکند.

با این حال در سال ۲۰۲۵ تمرکز شرکت بر این بخش افزایش یافته است و اوپنایآی اعلام کرده که بهطور مستمر در حال بهبود آموزش ChatGPT برای تشخیص نشانههای ناراحتی روانی، کاهش تنش در گفتوگوها و هدایت کاربران به منابع درمان و حمایت واقعی است.

این شرکت همچنین میگوید مدل GPT-5 نسبت به نسخههای قبلی، گرایش کمتری به «تایید بیشازحد» گفتههای کاربران دارد.

در همین حال، شرکتهایی مانند Character.AI نیز پذیرفتهاند که محصولاتشان میتوانند به مشکلات سلامت روان دامن بزنند و دسترسی نوجوانان را محدود کردهاند.

روانپزشکان هنوز با احتیاط به این مساله میپردازند و تاکید دارند که نمیتوان گفت چتباتها مستقیما باعث روانپریشی میشوند. با این حال شواهد بیش از پیش به چنین مسالهای اشاره دارد و نشان میدهد برای برخی افراد مستعد، تعامل طولانی با هوش مصنوعی میتواند بهعنوان یک عامل خطر جدید عمل کند؛ مشابه مصرف مواد یا کمخوابی.

در چنین شرایطی بدون شک به پژوهشهای گستردهتر، شفافیت بیشتر شرکتهای فناوری و تعریف مرزهای ایمنتری برای «همصحبتی مصنوعی» نیاز است و البته باید دید در عین انتظاراتی که از شرکت و توسعه دهندگان داریم، حواسمان به استفاده خود یا اطرافیانمان از این ابزارها باشد.